c语言搜索oracle中的空位

- 行业动态

- 2024-04-22

- 6

在C语言中,我们可以通过编写程序来搜索Oracle数据库中的空位,为了实现这个功能,我们需要遵循以下步骤:

1、安装Oracle客户端库和头文件

2、编写C语言程序

3、连接到Oracle数据库

4、执行查询以查找空位

5、处理查询结果

6、关闭数据库连接

下面是详细的技术教学:

1、安装Oracle客户端库和头文件

我们需要在计算机上安装Oracle客户端库和头文件,这些文件可以从Oracle官方网站下载,安装完成后,我们需要将头文件的路径添加到编译器的包含路径中。

2、编写C语言程序

接下来,我们需要编写一个C语言程序来实现搜索Oracle数据库中的空位的功能,以下是一个简单的示例:

#include <stdio.h>

#include <stdlib.h>

#include <string.h>

#include <oci.h>

int main() {

OCIEnv *envhp;

OCIServer *srvhp;

OCIError *errhp;

OCISvcCtx *svchp;

OCISession *usrhp;

OCIStatement *stmthp;

OCIBind *bindhp;

ub4 iter;

text *sql;

sb4 status;

sword err;

// 初始化OCI环境

OCIInitialize(NULL, NULL, NULL, NULL, NULL);

OCIEnvInit(&envhp, OCI_DEFAULT, 0, NULL);

OCIHandleAlloc(envhp, (dvoid **)&errhp, OCI_HTYPE_ERROR, 0, NULL);

OCIHandleAlloc(envhp, (dvoid **)&srvhp, OCI_HTYPE_SERVER, 0, NULL);

OCIHandleAlloc(envhp, (dvoid **)&svchp, OCI_HTYPE_SVCCTX, 0, NULL);

OCIHandleAlloc(envhp, (dvoid **)&usrhp, OCI_HTYPE_SESSION, 0, NULL);

OCIHandleAlloc(envhp, (dvoid **)&stmthp, OCI_HTYPE_STMT, 0, NULL);

OCIHandleAlloc(envhp, (dvoid **)&bindhp, OCI_HTYPE_BIND, 0, NULL);

// 连接到Oracle数据库

err = OCILogon2(envhp, errhp, &usrhp, "username", strlen("username"), "password", strlen("password"), "dbname", strlen("dbname"), OCI_DEFAULT);

if (err != OCI_SUCCESS) {

printf("登录失败: %s

", errhp>sqlerr);

return 1;

}

// 准备SQL查询语句

sql = (text *)"SELECT * FROM table_name WHERE column_name IS NULL";

status = OCIStmtPrepare(svchp, envhp, stmthp, errhp, (text *)sql, strlen((char *)sql), OCI_NTV_SYNTAX, OCI_DEFAULT);

if (status != OCI_SUCCESS) {

printf("准备语句失败: %s

", errhp>sqlerr);

return 1;

}

// 执行查询以查找空位

status = OCIStmtExecute(svchp, envhp, stmthp, errhp, 0, NULL, NULL, OCI_DEFAULT);

if (status != OCI_SUCCESS) {

printf("执行语句失败: %s

", errhp>sqlerr);

return 1;

}

// 处理查询结果

while ((status = OCIStmtFetch(svchp, envhp, stmthp, errhp, 1, OCI_FETCH_BOTH)) == OCI_SUCCESS) {

for (iter = 1; iter <= stmthp>cursor.arraylen; iter++) {

if (stmthp>cursor.array[iter] == SQLT_VNULL) {

printf("找到空位: %s

", stmthp>buf[iter]);

} else {

printf("%s

", stmthp>buf[iter]);

}

}

}

if (status != OCI_NO_DATA) {

printf("获取数据失败: %s

", errhp>sqlerr);

return 1;

}

// 关闭数据库连接和释放资源

OCILogoff(svchp, envhp, errhp);

OCIHandleFree(svchp, OCI_HTYPE_SVCCTX);

OCIHandleFree(usrhp, OCI_HTYPE_SESSION);

OCIHandleFree(stmthp, OCI_HTYPE_STMT);

OCIHandleFree(bindhp, OCI_HTYPE_BIND);

OCIHandleFree(errhp, OCI_HTYPE_ERROR);

OCIHandleFree(srvhp, OCI_HTYPE_SERVER);

OCIHandleFree(envhp, OCI_HTYPE_ENV);

OCIUninitialize();

return 0;

}

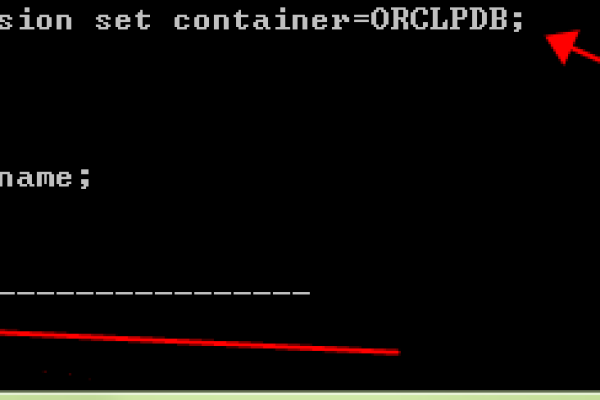

3、连接到Oracle数据库

在上面的程序中,我们使用OCILogon2函数连接到Oracle数据库,需要提供用户名、密码和数据库名,如果连接成功,err变量的值将为OCI_SUCCESS,否则,我们可以从errhp>sqlerr获取错误信息。

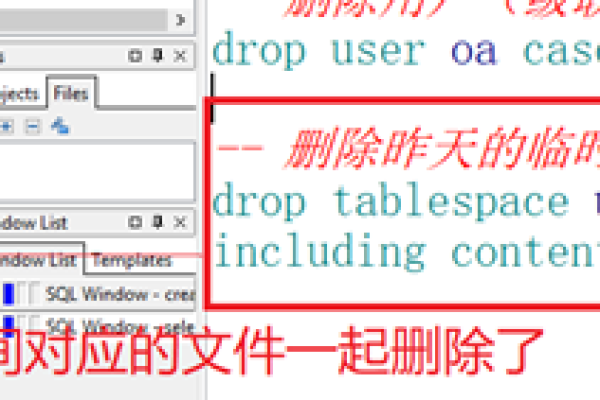

4、执行查询以查找空位

我们使用OCIStmtPrepare函数准备SQL查询语句,然后使用OCIStmtExecute函数执行查询,在这个例子中,我们查询table_name表中column_name为空的记录,如果查询成功,我们将遍历查询结果并打印出空位,如果查询失败,我们可以从errhp>sqlerr获取错误信息。