如何配置Kafka以拉取MySQL数据库镜像?

- 行业动态

- 2024-07-27

- 2

bash,docker pull mysql:latest,`

,,在Kafka的配置文件中(server.properties),添加以下内容:,,“

properties,kafka.connect.source.connector.class=io.debezium.connector.mysql.MySqlConnector,kafka.connect.source.hostname=,kafka.connect.source.port=,kafka.connect.source.database=,kafka.connect.source.username=,kafka.connect.source.password=,kafka.connect.source.server.id=,kafka.connect.source.topic.prefix=,“,,将尖括号内的内容替换为实际的数据库连接信息。保存配置文件后,重新启动Kafka以应用更改。Kafka应该能够拉取MySQL数据库的镜像并进行处理。

在当今数据驱动的业务环境中,实时数据流处理变得日益重要,Kafka作为广泛使用的分布式流处理平台,常用于构建实时数据管道和应用,将深入探讨如何利用Docker拉取并配置Kafka以及MySQL的镜像,以搭建一个实时的数据同步和处理环境,具体步骤和配置清晰列出,确保能高效准确地启动并运行这些服务。

1、基础环境搭建

拉取Zookeeper镜像:Zookeeper是Kafka运行所依赖的关键组件,可以通过执行docker pull wurstmeister/zookeeper命令来拉取Zookeeper的镜像,这一步是必要的因为几乎所有的Kafka集群都需要Zookeeper来协调和管理。

检查Zookeeper镜像:拉取完成后,运行docker images | grep zookeeper来确认镜像是否已成功拉取到本地。

2、Kafka镜像拉取与配置

拉取Kafka镜像:在确认Zookeeper镜像无误后,接着拉取Kafka镜像,使用命令docker pull wurstmeister/kafka即可开始拉取过程。

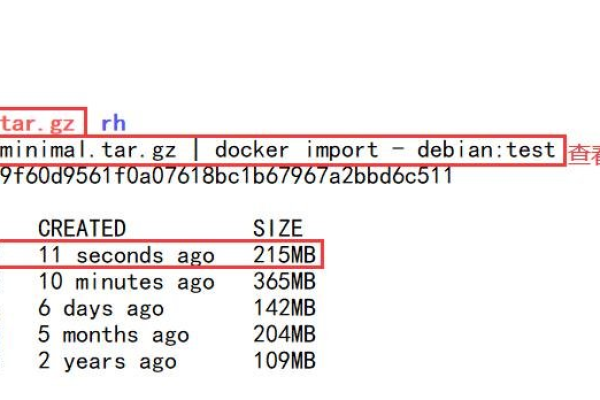

查看与验证Kafka镜像:通过运行docker images | grep kafka来检查Kafka镜像是否已经正确拉取到本地环境。

3、启动Zookeeper与Kafka服务

启动Zookeeper容器:使用命令docker run d name zookeeper p 2181:2181 t wurstmeister/zookeeper启动Zookeeper容器,这里映射的端口是2181,是Zookeeper默认的客户端连接端口。

启动Kafka容器:通过运行命令docker run d name kafka p 2181:2181 link zookeeper:zookeeper e KAFKA_ADVERTISED_LISTENERS=INSIDE://localhost:9092 t wurstmeister/kafka启动Kafka容器,同时将其与前面启动的Zookeeper容器链接起来。

4、配置Canal实现MySQL到Kafka的数据同步

安装配置Canal:Canal的主要作用是解析MySQL的增量日志,支持数据的实时订阅和消费,需先下载并配置Canal,使其能够连接到MySQL数据库并解析日志。

配置Kafka生产者:在Canal的配置中,需要设置Kafka作为消息生产者,确保Canal解析的数据能够发送到Kafka相应的主题中。

5、环境验证与调整

验证服务运行状态:使用docker ps命令查看所有运行中的容器,确认Zookeeper和Kafka容器都已正常启动并运行。

测试数据同步:可以通过在MySQL中插入一些测试数据,然后观察是否能在Kafka中收到这些数据,以此来验证整个数据流是否已经正确配置和运行。

在进行上述操作时,用户需要注意几个关键因素,以避免可能出现的配置错误或同步问题:

确保在拉取镜像前,服务器或本地主机已经设置了正确的安全策略和端口开放,特别是需要确保9092(Kafka默认端口)和2181(Zookeeper默认端口)是可访问的。

在配置Canal时,要确保MySQL的用户权限和连接设置是正确的,否则会影响Canal到MySQL的连接及日志读取。

当有多个Kafka消费者时,应适当设置分组和主题以保证数据的正确路由和消费。

您应该已经拥有了一个基于Docker的Zookeeper和Kafka运行环境,并且通过Canal实现了从MySQL到Kafka的数据同步,此配置不仅提供了实时数据处理的能力,还极大地简化了环境的搭建和配置过程。

本站发布或转载的文章及图片均来自网络,其原创性以及文中表达的观点和判断不代表本站,有问题联系侵删!

本文链接:http://www.xixizhuji.com/fuzhu/72052.html