ASP.NET数据库连接方法与技巧解析

- 行业动态

- 2025-03-02

- 6

在ASP.NET中连接数据库是一个关键步骤,它允许应用程序与数据库进行交互,实现数据的存储、检索和管理,以下是详细的步骤和示例代码:

配置连接字符串

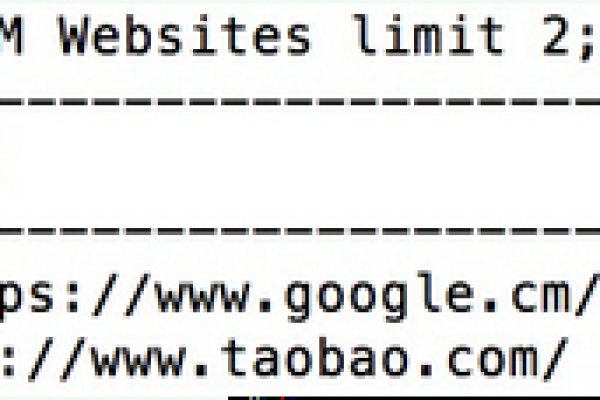

连接字符串是数据库连接的桥梁,它存储了数据库服务器的位置、数据库名称、认证信息等,在ASP.NET项目中,连接字符串通常被存储在web.config文件中,以下是一个典型的连接字符串示例:

<configuration>

<connectionStrings>

<add name="MyDbConnection" connectionString="Server=myServerAddress;Database=myDataBase;User Id=myUsername;Password=myPassword;" providerName="System.Data.SqlClient"/>

</connectionStrings>

</configuration> 在这个示例中:

Server: 这是数据库服务器的地址,可以是本地服务器(如localhost)或远程服务器的IP地址或名称。

Database: 数据库名称,即您要连接的具体数据库。

User Id 和Password: 数据库用户的身份验证信息。

ProviderName: 数据库提供程序的名称,通常为System.Data.SqlClient,表示使用SQL Server。

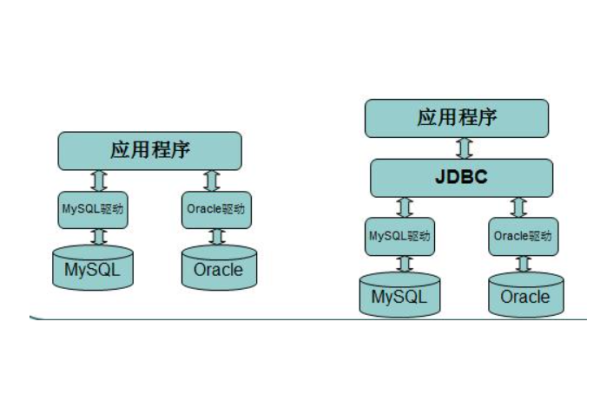

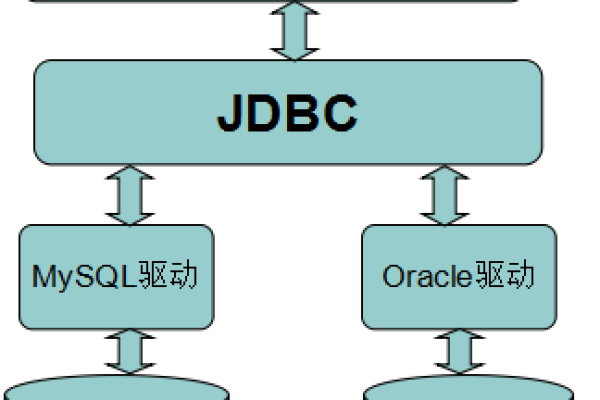

使用ADO.NET组件

ADO.NET是.NET框架中用于数据访问的组件库,主要组件包括SqlConnection、SqlCommand、SqlDataReader等,以下是如何使用这些组件来连接数据库并执行SQL命令的示例:

初始化和打开连接

需要使用SqlConnection对象来建立与数据库的连接,以下是一个示例:

using System;

using System.Data.SqlClient;

public class DatabaseHelper

{

private string connectionString;

public DatabaseHelper()

{

connectionString = System.Configuration.ConfigurationManager.ConnectionStrings["MyDbConnection"].ConnectionString;

}

public void OpenConnection()

{

using (SqlConnection connection = new SqlConnection(connectionString))

{

connection.Open();

Console.WriteLine("Connection Opened Successfully");

}

}

} 在这个示例中,DatabaseHelper类通过读取web.config文件中的连接字符串来初始化SqlConnection对象,并在OpenConnection方法中打开连接。

执行SQL命令

要在数据库中执行SQL命令,可以使用SqlCommand对象,以下是一个执行查询命令的示例:

using System;

using System.Data.SqlClient;

public class DatabaseOperations

{

public void ExecuteQuery()

{

string connectionString = System.Configuration.ConfigurationManager.ConnectionStrings["MyDbConnection"].ConnectionString;

using (SqlConnection connection = new SqlConnection(connectionString))

{

connection.Open();

string query = "SELECT FROM Users";

SqlCommand command = new SqlCommand(query, connection);

using (SqlDataReader reader = command.ExecuteReader())

{

while (reader.Read())

{

Console.WriteLine($"ID: {reader["ID"]}, Name: {reader["Name"]}");

}

}

}

}

} 在这个示例中,ExecuteQuery方法首先打开与数据库的连接,然后创建一个SqlCommand对象来执行查询命令。SqlDataReader对象用于逐行读取查询结果。

处理结果

处理结果通常涉及读取数据并将其转换为应用程序中的对象或显示在用户界面上,以下是一个将查询结果转换为对象列表的示例:

using System;

using System.Collections.Generic;

using System.Data.SqlClient;

public class User

{

public int ID { get; set; }

public string Name { get; set; }

}

public class DatabaseOperations

{

public List<User> GetUsers()

{

List<User> users = new List<User>();

string connectionString = System.Configuration.ConfigurationManager.ConnectionStrings["MyDbConnection"].ConnectionString;

using (SqlConnection connection = new SqlConnection(connectionString))

{

string query = "SELECT FROM Users";

SqlCommand command = new SqlCommand(query, connection);

connection.Open();

using (SqlDataReader reader = command.ExecuteReader())

{

while (reader.Read())

{

User user = new User

{

ID = Convert.ToInt32(reader["ID"]),

Name = reader["Name"].ToString()

};

users.Add(user);

}

}

}

return users;

}

} 在这个示例中,GetUsers方法将查询结果转换为一个User对象的列表,并返回该列表。

最佳实践

1、使用参数化查询避免SQL注入:参数化查询可以防止SQL注入攻击,以下示例展示了如何使用参数化查询来插入用户数据:

using System;

using System.Data.SqlClient;

public class DatabaseOperations

{

public void InsertUser(string name)

{

string connectionString = System.Configuration.ConfigurationManager.ConnectionStrings["MyDbConnection"].ConnectionString;

using (SqlConnection connection = new SqlConnection(connectionString))

{

string query = "INSERT INTO Users (Name) VALUES (@Name)";

SqlCommand command = new SqlCommand(query, connection);

command.Parameters.AddWithValue("@Name", name);

connection.Open();

command.ExecuteNonQuery();

}

}

} 在这个示例中,InsertUser方法使用参数化查询来插入用户数据,从而避免了SQL注入攻击。

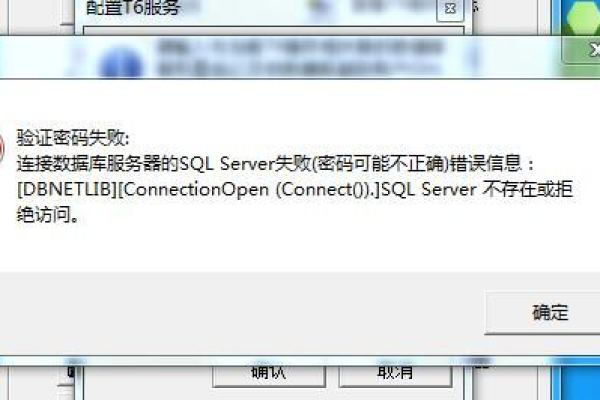

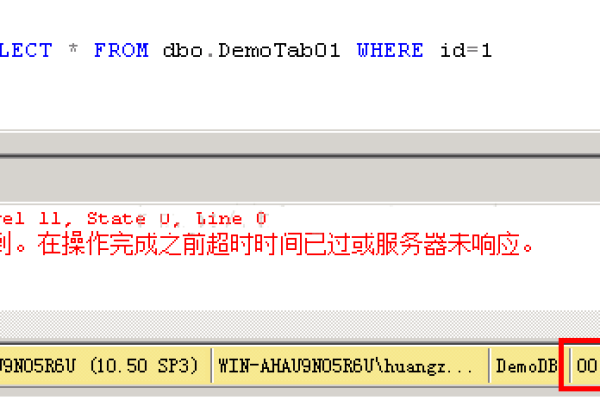

2、异常处理:在数据库操作中,可能会遇到各种异常情况,如连接失败、查询错误等,为了确保应用程序的稳定性,必须进行异常处理,以下是一个包含异常处理的示例:

using System;

using System.Data.SqlClient;

public class DatabaseOperations

{

public void ExecuteQueryWithExceptionHandling()

{

string connectionString = System.Configuration.ConfigurationManager.ConnectionStrings["MyDbConnection"].ConnectionString;

try

{

using (SqlConnection connection = new SqlConnection(connectionString))

{

connection.Open();

string query = "SELECT FROM MyTable";

using (SqlCommand command = new SqlCommand(query, connection))

{

SqlDataReader reader = command.ExecuteReader();

while (reader.Read())

{

// Process each row

var columnValue = reader["ColumnName"];

}

reader.Close();

}

}

}

catch (SqlException ex)

{

// Log and handle the exception

Console.WriteLine("SQL Error: " + ex.Message);

}

catch (Exception ex)

{

// Log and handle other exceptions

Console.WriteLine("Error: " + ex.Message);

}

}

} 在这个示例中,ExecuteQueryWithExceptionHandling方法包含了对SqlException和其他异常的处理逻辑。

在ASP.NET中连接数据库涉及到配置连接字符串、使用ADO.NET组件、执行SQL命令以及处理结果等步骤,通过遵循上述步骤和最佳实践,您可以有效地连接到数据库并执行各种数据操作,请注意保护连接字符串的安全性,并妥善处理可能遇到的异常情况。