解决WordPress升级“正在执行例行维护,请一分钟后回来”(正在执行service操作是什么意思)

- 行业动态

- 2024-02-01

- 9

WordPress升级时出现“正在执行例行维护”提示,需等待或检查.maintenance文件。

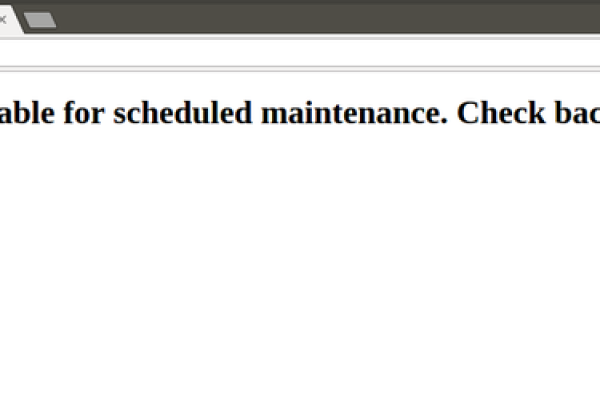

在WordPress升级过程中,用户可能会遇到一个常见的问题,即浏览器显示“正在执行例行维护,请一分钟后回来”的消息,这通常是由于WordPress在升级过程中执行数据库操作或文件操作时,触发了维护模式,本文将详细介绍如何解决这一问题,并解释“正在执行service操作”的含义。

理解维护模式

WordPress的维护模式是网站更新、升级或执行其他需要时间的任务时的一种状态,在这个模式下,WordPress会生成一个特殊的.maintenance文件在你的网站的根目录中,用以告知访问者网站暂时不可用,并在前端显示上述消息。

解决步骤

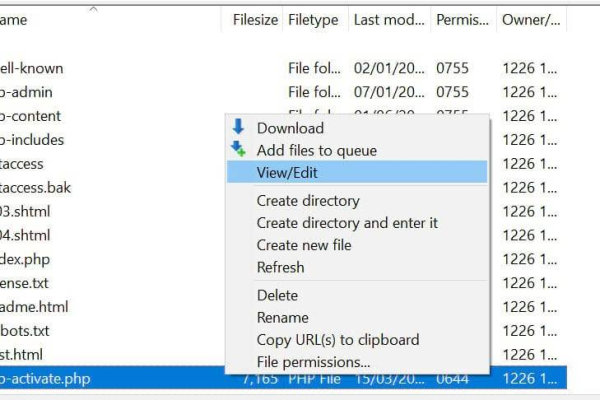

1. 检查.maintenance文件

你需要登录到你的服务器,检查WordPress根目录下是否存在一个名为.maintenance的文件,如果该文件存在,WordPress会认为维护模式仍然激活,你可以通过FTP客户端或SSH删除该文件来解除维护模式。

2. 修复权限问题

有时,文件和文件夹的权限设置不正确也可能导致WordPress无法完成升级过程,确保你的wp-content目录以及其子目录和文件有正确的读写权限,通常,这些权限应设置为755(目录)和644(文件)。

3. 清除缓存

如果你使用缓存插件或CDN服务,尝试清除缓存,这些服务可能会存储旧版本的页面,导致维护模式持续存在。

4. 增加PHP执行时间限制

在某些情况下,WordPress升级可能需要更多的时间来完成所有的任务,如果PHP执行时间限制设置得太低,可能会导致升级过程中断,你可以尝试通过修改wp-config.php文件或.htaccess文件来增加PHP的执行时间限制。

5. 检查数据库问题

如果数据库服务出现问题或者连接不稳定,WordPress升级可能无法正确完成,确保数据库服务运行正常,并且WordPress与之的连接没有问题。

“正在执行service操作”的含义

在WordPress的上下文中,“正在执行service操作”通常指的是WordPress正在进行后台服务性质的操作,如升级、维护数据库、安装插件或主题等,这些操作往往需要一定的处理时间,期间WordPress会自动进入维护模式,以告知用户站点暂时不可用。

相关问题与解答

Q1: 如果删除.maintenance文件后问题依旧存在怎么办?

A1: 如果删除.maintenance文件后问题仍然存在,可能是由于其他因素导致的问题,比如插件冲突、主题问题或是服务器配置错误,建议先禁用所有插件,切换到默认主题,然后再次尝试升级。

Q2: 如何防止未来升级时再次出现维护模式?

A2: 确保服务器稳定,定期备份你的网站,包括数据库和文件,在升级之前,最好禁用所有插件,避免潜在的冲突,并在流量较低的时段进行升级操作。

Q3: 增加PHP执行时间限制是否会影响网站性能?

A3: 增加PHP执行时间限制不会直接影响网站性能,因为这仅针对当前的升级过程,不过,不建议将其设得过高,因为长时间运行的脚本可能会占用过多服务器资源。

Q4: 是否可以手动更新WordPress而不是等待自动更新?

A4: 当然可以,手动更新WordPress可以让你更好地控制更新过程,包括选择更新的时间点以及备份数据,但请确保遵循官方的更新指南,以避免可能出现的问题。