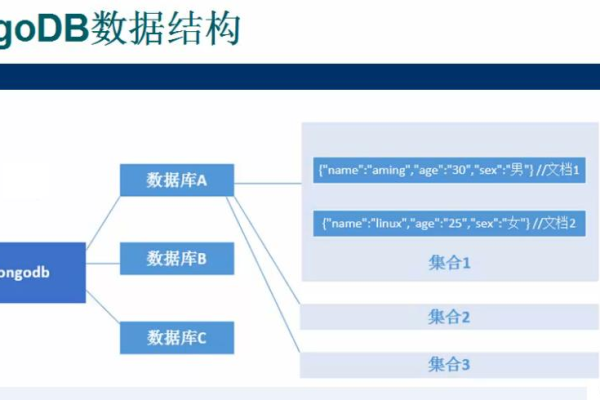

云服务器mongodb怎么配置

- 行业动态

- 2024-03-02

- 4

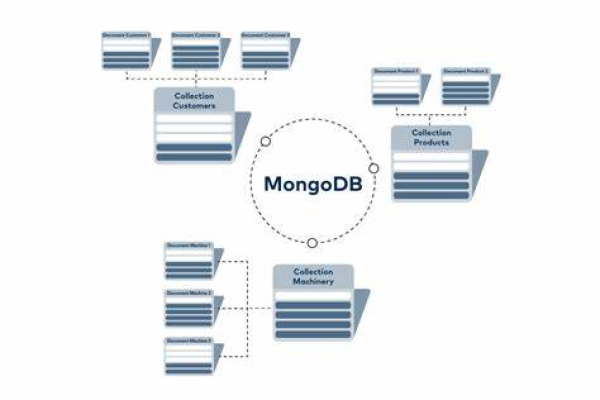

要在云服务器上配置MongoDB,需安装MongoDB软件、创建数据存储目录、配置文件、启动服务,并确保防火墙允许相关端口通信。

云服务器上的MongoDB配置是一个涉及多个步骤的过程,包括安装、安全设置、性能调优等,下面将详细介绍如何在云服务器上配置MongoDB。

安装MongoDB

在开始配置之前,确保你的云服务器操作系统已选定(如Ubuntu、CentOS等),这里以Ubuntu为例进行说明。

1、更新系统包列表:

“`

sudo apt-get update

“`

2、安装MongoDB软件包:

“`

sudo apt-get install -y mongodb

“`

3、启动MongoDB服务:

“`

sudo systemctl start mongodb

“`

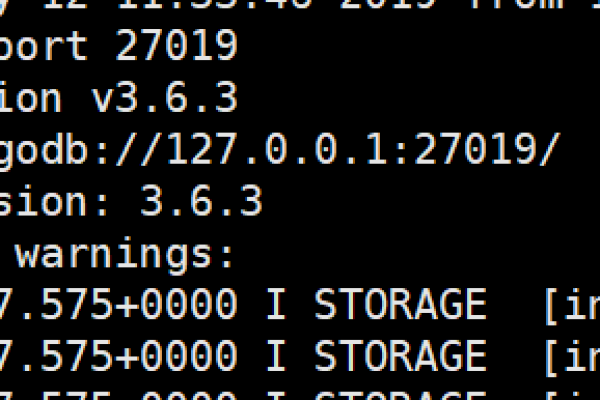

4、确认MongoDB服务状态:

“`

sudo systemctl status mongodb

“`

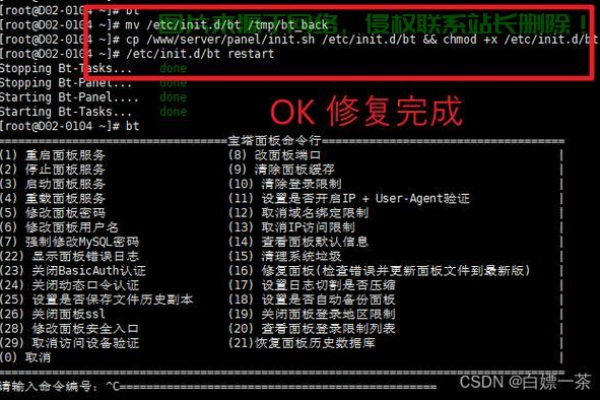

安全配置

出于安全考虑,你应该对MongoDB进行适当的安全设置。

1、修改MongoDB配置文件通常位于/etc/mongod.conf或/etc/mongodb.conf,使用文本编辑器打开它。

2、在配置文件中,设置bindIp为127.0.0.1以外的IP地址,例如0.0.0.0,以便能够从外部访问MongoDB。

3、启用认证授权,设置security:下的authorization为enabled。

4、保存并关闭配置文件。

5、重启MongoDB服务使更改生效:

“`

sudo systemctl restart mongodb

“`

6、使用mongo命令行工具创建管理员用户:

“`

use admin

db.createUser({ user: "adminUser", pwd: "securePassword", roles: [{ role: "userAdminAnyDatabase", db: "admin" }] })

“`

性能调优

为了提升MongoDB的性能,你可能需要根据实际使用情况调整配置。

1、增加日志级别,记录更详细的日志信息,便于问题排查。

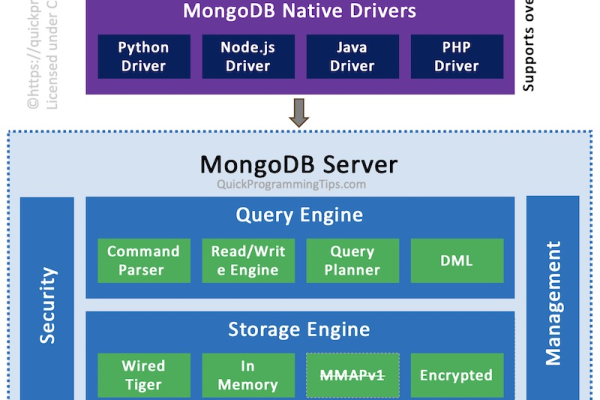

2、调整存储引擎选项,比如WiredTiger的配置。

3、根据机器的内存大小和数据库的使用模式,优化缓存大小。

4、调整读写操作的并发级别。

5、如果数据集非常大,可以启用分片功能来分散数据和负载。

备份与恢复

定期备份是保证数据安全的重要措施。

1、使用mongodump命令进行数据备份。

2、使用mongorestore命令进行数据恢复。

监控和维护

1、利用MongoDB自带的mongostat和mongotop工具监控数据库性能。

2、定期运行db.serverStatus()检查数据库状态。

3、使用第三方监控工具,如MMS(MongoDB Management Service)或Nagios插件等。

相关问题与解答

Q1: 如何远程访问MongoDB?

A1: 确保MongoDB配置文件中的bindIp设置允许远程访问,并且防火墙规则允许MongoDB端口(默认27017)的入站连接。

Q2: MongoDB的安全机制有哪些?

A2: MongoDB的安全机制包括用户认证、角色授权、SSL/TLS加密通信以及通过防火墙限制访问。

Q3: MongoDB备份时需要注意什么?

A3: 在进行备份前确认数据库处于正常状态,备份过程中保持数据的一致性,并确保备份文件存储在安全的地方。

Q4: 如何监控MongoDB的性能?

A4: 可以使用MongoDB自带的mongostat和mongotop工具,或者使用第三方监控工具,如MMS、Prometheus结合Grafana等进行性能监控。