如何编辑香港Linux主机的授权设置?

- 行业动态

- 2024-09-27

- 3

香港Linux主机_编辑Linux主机授权

在管理Linux服务器时,授权和权限设置是确保系统安全和有效运行的关键,本文将详细介绍如何编辑和管理Linux主机的授权,包括用户权限、文件权限以及服务权限等方面的内容。

1. 用户权限管理

在Linux系统中,用户权限的管理是通过用户账户和用户组来实现的,每个用户可以属于一个或多个用户组,而每个文件或目录的权限可以基于用户、组和其他用户来设置。

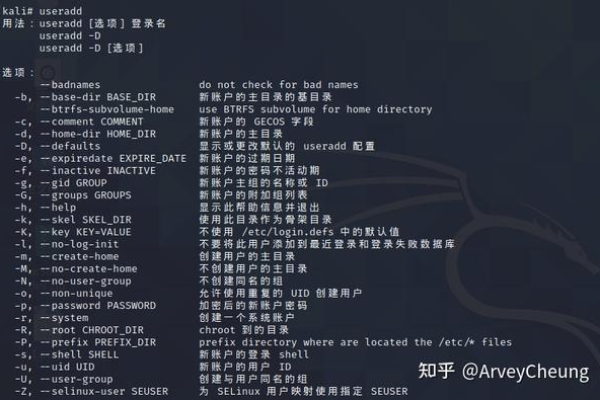

添加新用户

要添加一个新用户,可以使用useradd命令:

sudo useradd newusername

为新用户设置密码:

sudo passwd newusername

修改用户组

可以使用usermod命令将用户添加到新的用户组:

sudo usermod -aG groupname newusername

查看用户信息

使用id命令可以查看指定用户的UID(用户标识符)、GID(组标识符)和所属的用户组:

id username

2. 文件和目录权限

Linux系统中的文件和目录权限分为读(r)、写(w)和执行(x),这些权限可以分别设置给文件的所有者、所属组和其他用户。

查看文件/目录权限

使用ls -l命令可以查看文件或目录的详细信息,包括权限:

ls -l filename

输出示例:

-rw-r--r-1 user group 0 Jan 1 00:00 filename

解释:

第一个字符表示文件类型(表示普通文件,d表示目录)

接下来的九个字符分为三组,每组三个字符,分别表示所有者、所属组和其他用户的权限

修改文件/目录权限

使用chmod命令可以修改文件或目录的权限:

chmod u=rwx,g=rx,o=r filename

u表示所有者,g表示所属组,o表示其他用户,r表示读,w表示写,x表示执行。

3. 服务权限

在Linux系统中,某些服务需要特定的权限才能正常运行,Web服务器(如Apache或Nginx)需要对特定目录有读取权限,而数据库服务器(如MySQL)则需要对数据目录有读写权限。

配置服务权限

以Apache为例,默认情况下,Apache的Web根目录为/var/www/html,要确保Apache对该目录有读取权限,可以使用以下命令:

sudo chown -R www-data:www-data /var/www/html sudo chmod -R 755 /var/www/html

这里,www-data是Apache运行的用户和组,755表示所有者有读、写和执行权限,所属组和其他用户只有读和执行权限。

相关问题与解答

问题1:如何查看当前登录用户的信息?

答:使用whoami命令可以查看当前登录用户的用户名:

whoami

使用id命令可以查看当前用户的UID、GID和所属的用户组:

id

问题2:如何限制某个用户只能访问特定的目录?

答:可以通过设置该用户主目录的权限来限制其访问范围,假设要限制用户newuser只能访问/home/newuser目录,可以使用以下命令:

mkdir /home/newuser sudo chown newuser:newuser /home/newuser sudo chmod 750 /home/newuser

这样,只有newuser及其所属组的成员才能访问该目录。

小伙伴们,上文介绍了“香港linux主机_编辑Linux主机授权”的内容,你了解清楚吗?希望对你有所帮助,任何问题可以给我留言,让我们下期再见吧。