如何选择合适的香水网站模板来提升品牌形象?

- 行业动态

- 2024-09-23

- 8

香水网站模板设置

1. 首页设计

导航栏:包含品牌故事、产品分类、新品上市、促销活动、会员中心等。

轮播图:展示最新或最热的香水产品,可点击进入详细页面。

品牌介绍:简要说明品牌历史和理念。

热门产品展示:突出显示畅销或新推出的香水系列。

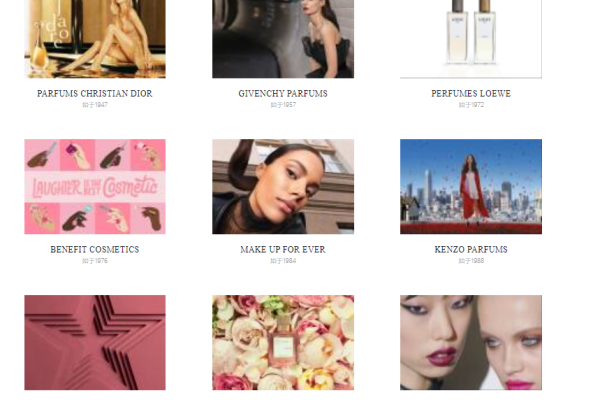

2. 产品分类页

分类列表:如女士香水、男士香水、中性香水、限量版等。

筛选功能:根据价格、香调、容量等进行筛选。

排序功能:按价格、销量、新品等排序。

3. 产品详情页

产品图片:多角度展示产品细节。

产品描述:包括香调、主要成分、设计理念等。

用户评价:展示购买过此产品的用户评价。

购买选项:选择容量、包装等,加入购物车或立即购买。

4. 购物车与结算

购物车列表:显示已选择的产品及其数量、单价和总价。

优惠券/积分使用:提供优惠券或积分抵扣选项。

支付方式:支持多种支付方式,如信用卡、支付宝、微信支付等。

订单确认:确认收货地址、联系方式等信息后提交订单。

5. 会员中心

个人资料:编辑个人信息,包括地址、电话等。

订单管理:查看订单状态,跟踪物流信息。

收藏夹:保存感兴趣的产品。

积分查询:查询积分余额,了解积分获取和使用规则。

6. 客服与帮助

常见问题:解答关于购买流程、支付方式、退换货政策等的疑问。

在线客服:提供实时咨询。

售后服务:详细说明退换货流程和售后保障。

7. 移动端适配

响应式设计:确保网站在手机和平板等移动设备上的浏览体验。

触屏优化:调整按钮大小和间距,适应触屏操作。

相关问题与解答

Q1: 如何提高香水网站的用户体验?

A1: 提高用户体验可以通过以下几个方面实现:确保网站加载速度快;设计简洁直观的用户界面;提供清晰的产品分类和高效的搜索功能;优化移动端访问体验;提供详细的产品信息和高质量的图片;设置便捷的支付和物流跟踪系统;建立有效的客户反馈和售后服务机制。

Q2: 香水网站如何处理库存和物流问题?

A2: 处理库存和物流问题需要:使用高效的库存管理系统来实时监控库存水平;与可靠的物流合作伙伴合作,确保快速准确的产品配送;提供订单追踪功能,让顾客能实时了解订单状态;设立合理的退换货政策,以处理可能的产品问题或顾客不满意的情况。