MapReduce中的slot概念是如何优化数据处理的?

- 行业动态

- 2024-08-01

- 3887

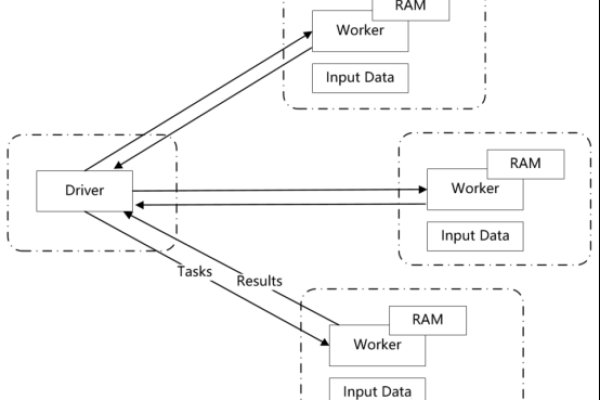

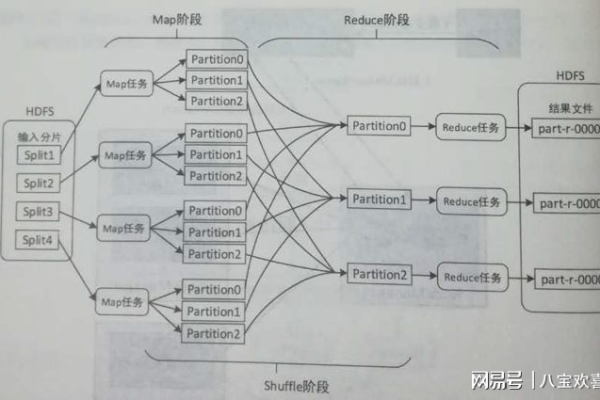

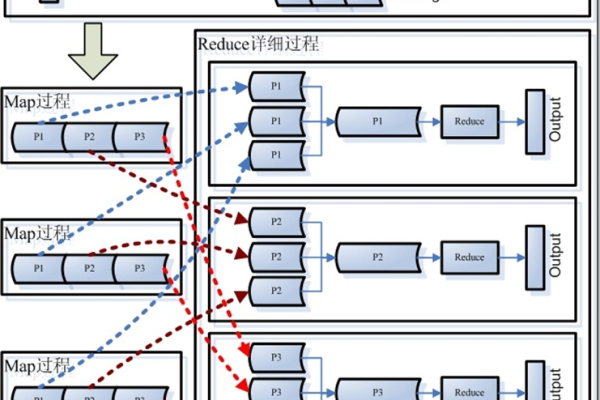

MapReduce是一种编程模型,用于处理和生成大数据集。在Hadoop中,一个节点的计算能力由其slot数决定,分为Map slot和Reduce slot,分别用于执行Map任务和Reduce任务。合理分配和使用这些slots是提高作业效率的关键。

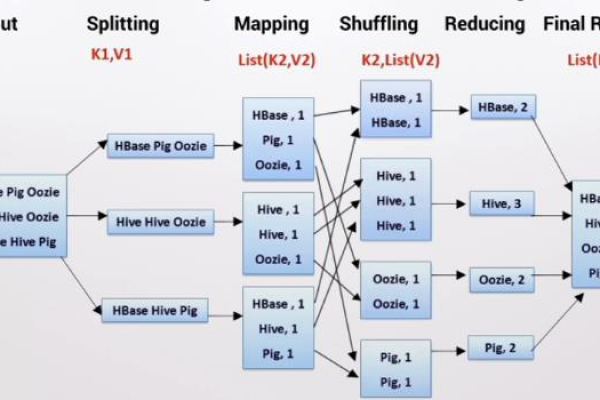

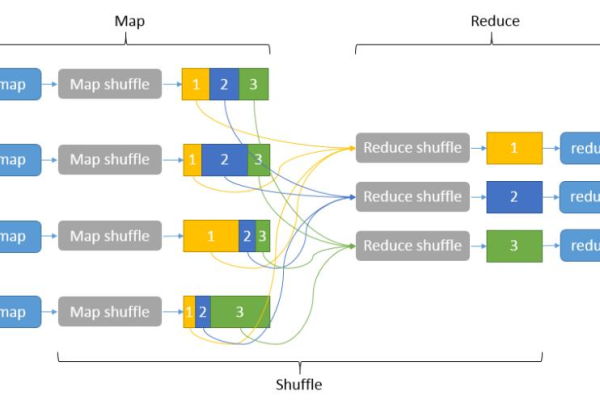

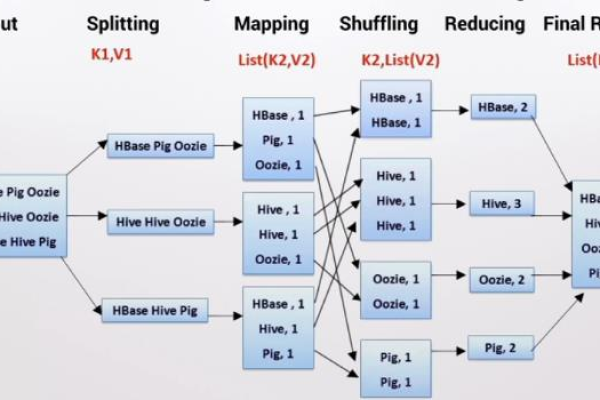

MapReduce是一种编程模型,用于处理和生成大数据集的并行算法,它由两个主要阶段组成:Map阶段和Reduce阶段,下面是一个详细的解释,包括小标题和单元表格:

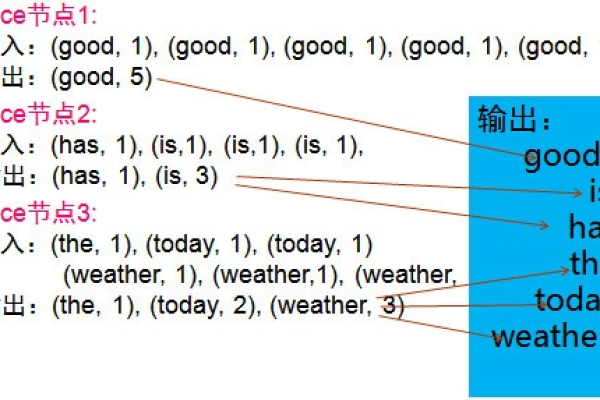

1、Map阶段

输入:原始数据(例如文本文件)

输出:中间键值对(keyvalue pairs)

功能:将输入数据分割成多个独立的块,并对每个块应用map函数,生成一组中间键值对。

2、Reduce阶段

输入:来自Map阶段的中间键值对

输出:最终结果(例如汇总统计信息)

功能:将所有具有相同键的中间键值对分组在一起,并对每个组应用reduce函数,以生成最终结果。

以下是一个简单的MapReduce示例,用于计算文本文件中单词的出现次数:

from collections import defaultdict

import itertools

Map函数

def map_function(document):

"""将文档分割成单词并生成键值对"""

words = document.split()

for word in words:

yield (word, 1)

Reduce函数

def reduce_function(item):

"""计算每个单词的总出现次数"""

word, counts = item

return (word, sum(counts))

模拟MapReduce过程

def map_reduce(documents):

# Map阶段

mapper_output = list(itertools.chain(*[map_function(doc) for doc in documents]))

# Shuffle阶段(在真实环境中由框架自动完成)

grouped_data = defaultdict(list)

for key, value in mapper_output:

grouped_data[key].append(value)

# Reduce阶段

result = [reduce_function((key, values)) for key, values in grouped_data.items()]

return result

示例文档列表

documents = [

"hello world",

"hello python",

"python is great",

"hello again"

]

执行MapReduce

result = map_reduce(documents)

print(result)在这个示例中,我们首先定义了map_function和reduce_function,分别对应于Map阶段和Reduce阶段的操作,我们使用map_reduce函数来模拟整个MapReduce过程,包括Map、Shuffle和Reduce阶段,我们使用一些示例文档来测试我们的MapReduce实现。

本站发布或转载的文章及图片均来自网络,其原创性以及文中表达的观点和判断不代表本站,有问题联系侵删!

本文链接:http://www.xixizhuji.com/fuzhu/71362.html