为什么服务器会出现繁忙状态?

- 行业动态

- 2025-01-07

- 7

服务器忙的原因可能有很多,以下是一些常见的原因:

1、硬件资源不足:服务器的CPU、内存、硬盘等硬件资源有限,当访问量过大时,可能会导致服务器无法处理所有的请求,从而出现服务器忙的情况。

2、软件问题:服务器上运行的软件可能存在bug或者性能问题,导致服务器无法正常工作,数据库查询语句执行效率低下,可能会导致服务器响应变慢。

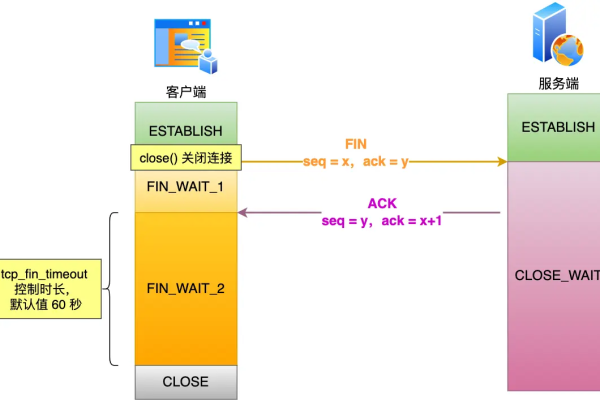

3、网络问题:服务器所在的网络环境可能不稳定,导致服务器无法正常与客户端通信,网络延迟、丢包等问题都可能导致服务器忙。

4、反面攻击:服务器可能遭受到DDoS攻击等反面攻击,导致服务器资源被耗尽,无法正常提供服务。

5、配置问题:服务器的配置可能不合理,导致服务器无法充分发挥其性能,线程池大小设置过小,可能导致服务器在高并发情况下无法处理所有请求。

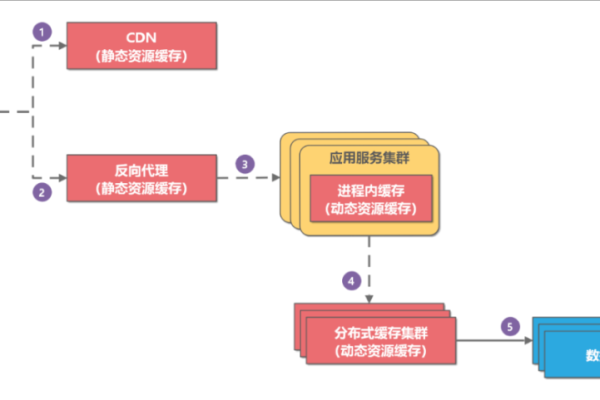

6、第三方服务故障:服务器可能依赖于第三方服务,如CDN、DNS等,当这些服务出现故障时,可能导致服务器无法正常提供服务。

为了更直观地展示服务器忙的原因,我们可以使用表格进行分类:

| 类别 | 具体原因 |

| 硬件资源 | CPU、内存、硬盘等资源不足 |

| 软件问题 | 软件bug、性能问题 |

| 网络问题 | 网络延迟、丢包等 |

| 反面攻击 | DDoS攻击等 |

| 配置问题 | 线程池大小、连接数等配置不合理 |

| 第三方服务 | CDN、DNS等第三方服务故障 |

相关问答FAQs:

1、如何判断服务器是否繁忙?

答:可以通过以下几种方法来判断服务器是否繁忙:(1)查看服务器的CPU、内存、硬盘等硬件资源使用情况;(2)查看服务器的日志文件,分析请求响应时间;(3)使用性能监控工具,如Zabbix、Prometheus等,实时监控服务器的性能指标。

2、如何解决服务器繁忙的问题?

答:解决服务器繁忙的问题需要根据具体原因采取相应的措施:(1)如果是硬件资源不足,可以考虑升级服务器硬件或者增加服务器数量;(2)如果是软件问题,可以优化软件代码,提高性能;(3)如果是网络问题,可以检查网络设备,优化网络配置;(4)如果是反面攻击,可以使用防火墙、WAF等安全设备进行防护;(5)如果是配置问题,可以调整服务器配置,提高性能;(6)如果是第三方服务故障,可以联系第三方服务提供商进行排查和修复。

小编有话说:

服务器忙是一个常见的问题,但是通过合理的分析和处理,我们可以找到问题的根本原因并采取相应的措施来解决,作为运维人员,我们需要时刻关注服务器的性能状况,及时发现并解决问题,确保服务器能够稳定、高效地为用户提供服务,我们还需要不断学习和掌握新的技术和方法,提高自己的运维能力,为公司的业务发展提供有力的支持。