如何在C Web API中有效管理和使用Cookie?

- 行业动态

- 2025-01-29

- 9

在C# Web API项目中,Cookie的使用与配置是一个相对复杂但非常重要的主题,以下是关于如何在C# Web API中使用Cookie的详细回答:

一、服务端配置

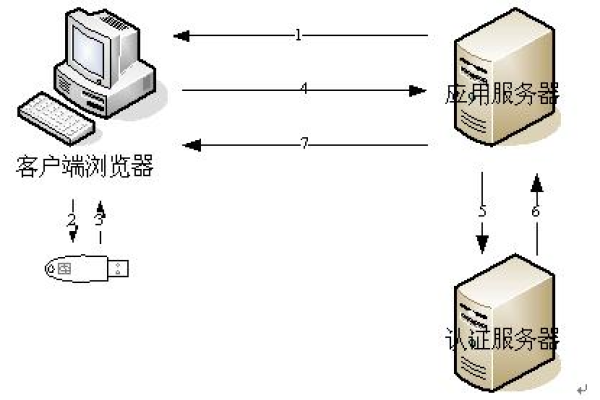

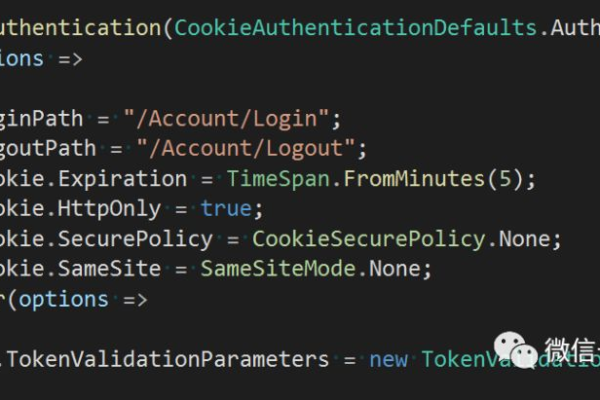

1、添加认证中间件:在Startup.cs的ConfigureServices方法中配置验证中间件,指定默认的认证方案为“Cookies”,并设置Cookie的名称、同源策略等属性。

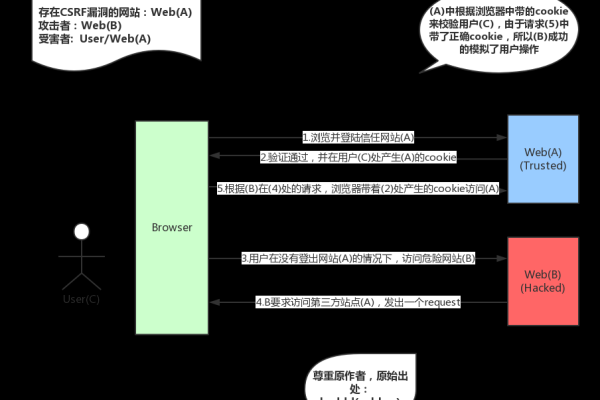

2、配置CORS:由于Web API通常需要跨域访问,因此需要配置CORS策略,允许客户端所在域的请求携带Cookie,在Startup.cs的Configure方法中,使用app.UseCors方法配置CORS策略,允许任意来源、任意头信息和任意HTTP方法。

二、写入Cookie

1、创建响应消息:在控制器的操作方法中,创建一个HttpResponseMessage对象作为响应消息。

2、创建Cookie对象:使用CookieHeaderValue类创建一个表示Cookie的对象,并设置其名称、值、过期时间、域和路径等属性。

3、添加Cookie到响应:调用HttpResponseMessage对象的Headers.AddCookies方法,将创建好的Cookie对象添加到响应消息的Cookie集合中。

4、返回响应:返回包含Cookie的响应消息给客户端。

三、读取Cookie

1、从请求中获取Cookie:在控制器的操作方法中,通过调用Request.Headers.GetCookies方法,并传入要获取的Cookie名称,来获取客户端发送的Cookie集合。

2、提取Cookie值:从获取到的Cookie集合中,找到对应的Cookie对象,并提取其值。

四、处理结构化数据

1、创建NameValueCollection:创建一个NameValueCollection对象,用于存储Cookie的数据。

2、添加数据到集合:将需要存储的数据以键值对的形式添加到NameValueCollection对象中。

3、创建Cookie对象:使用CookieHeaderValue类的构造函数,将NameValueCollection对象传递给它,创建一个包含结构化数据的Cookie对象。

4、添加到响应:将创建好的包含结构化数据的Cookie对象添加到响应消息的Cookie集合中,并发送给客户端。

五、示例代码

以下是一个完整的示例代码,展示了如何在C# Web API中写入和读取Cookie:

// 写入Cookie

public HttpResponseMessage Get()

{

var resp = new HttpResponseMessage();

var cookie = new CookieHeaderValue("session-id", "12345");

cookie.Expires = DateTimeOffset.Now.AddDays(1);

cookie.Domain = Request.RequestUri.Host;

cookie.Path = "/";

resp.Headers.AddCookies(new CookieHeaderValue[] { cookie });

return resp;

}

// 读取Cookie

string sessionId = "";

CookieHeaderValue cookie = Request.Headers.GetCookies("session-id").FirstOrDefault();

if (cookie != null)

{

sessionId = cookie["session-id"].Value;

}

六、FAQs

1、问:为什么需要在服务端配置CORS?

答:因为Web API通常需要跨域访问,而浏览器出于安全考虑,会限制跨域请求中的Cookie传递,通过配置CORS策略,可以明确允许哪些域名的请求可以携带Cookie,从而解决跨域Cookie问题。

2、问:如何确保Cookie的安全性?

答:为了确保Cookie的安全性,可以采取以下措施:设置合理的过期时间、使用HttpOnly属性防止客户端脚本访问Cookie、使用Secure属性确保Cookie仅在HTTPS连接下传输、以及定期更新Cookie的值以防止被窃取或改动。