关于CDN解析接口的疑问,如何实现高效稳定的解析服务?

- 行业动态

- 2025-03-10

- 15

一、CDN解析接口

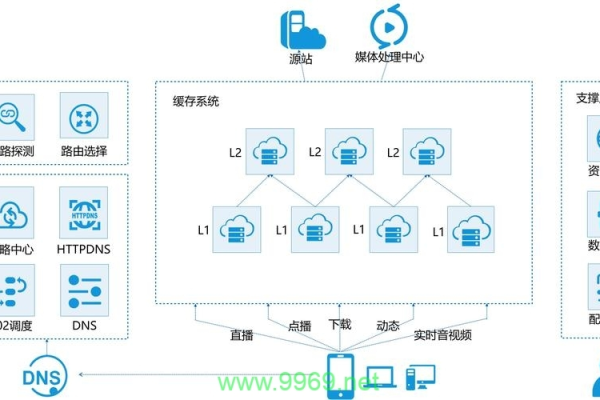

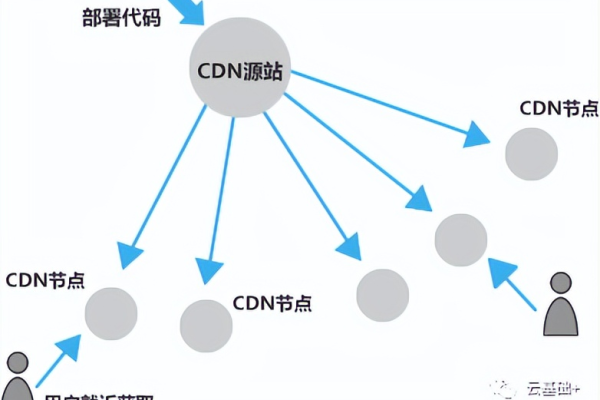

CDN(Content Delivery Network,内容分发网络)解析接口是用于将用户请求引导至距离最近的CDN节点,从而实现快速内容分发的关键接口,它通过智能调度和缓存机制,优化用户体验,减少延迟,提高网站访问速度和稳定性。

二、CDN解析接口的主要功能

1、域名解析:将用户请求的域名转换为对应的IP地址,确保请求能够到达最佳的CDN节点。

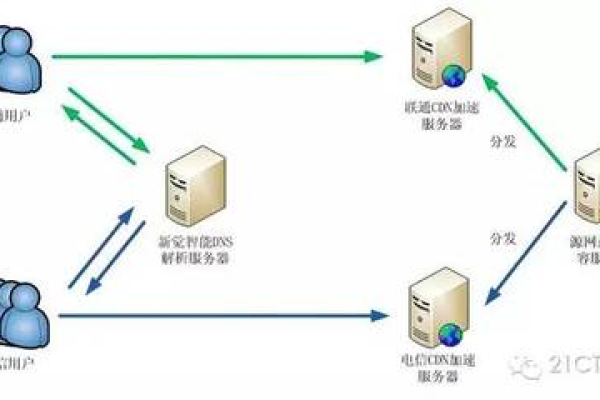

2、智能调度:根据用户的地理位置、网络状况、CDN节点负载等因素,选择最优的CDN节点进行内容分发。

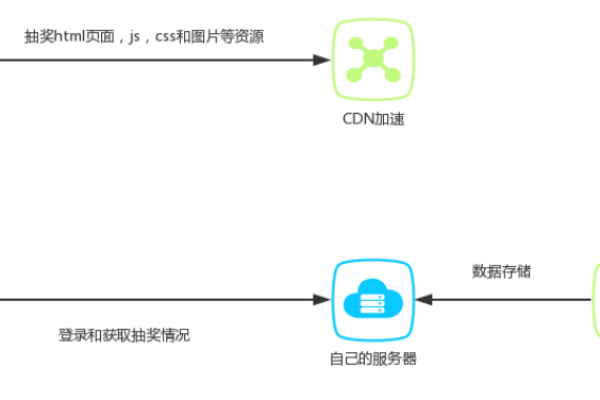

3、缓存机制:在CDN节点上缓存静态内容,如图片、CSS、JavaScript等,减少源站服务器的负载。

4、回源策略:当CDN节点未缓存用户请求的内容时,通过优化的回源路径向源站获取数据。

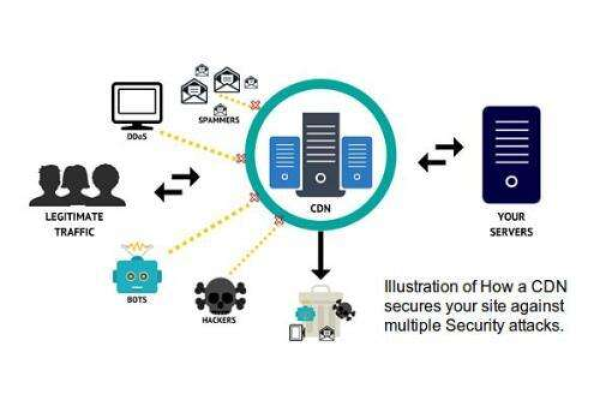

5、负载均衡:通过DNS解析或应用层技术,将用户请求分配到不同的CDN节点,避免单个节点过载。

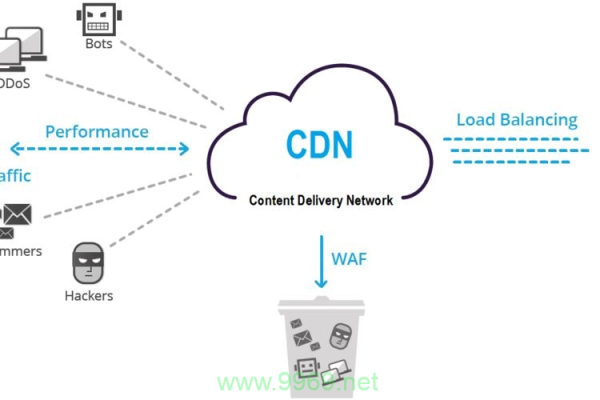

6、安全防护:提供DDoS防护、SSL加密等安全措施,保障数据传输的安全性。

三、CDN解析接口的操作流程

1、灰度验证服务可用性(可选):对于已创建完成的CDN域名,可以通过本机将域名静态解析到某个CDN节点上,用于验收经过CDN加速后的业务是否正常服务。

2、操作CNAME配置:登录域名所托管的DNS后台,添加或修改CNAME记录,将其指向CDN服务商提供的CNAME地址。

3、检查解析配置是否生效(可选):提交成功后,等待DNS解析生效(一般需要10分钟左右),然后参考步骤三验证是否CDN加速成功。

四、CDN解析接口的应用场景

1、高流量网站:如视频网站、社交网站等,通过CDN解析接口实现内容的快速分发。

2、跨地域或跨国访问的网站:通过CDN解析接口优化跨运营商转发,减少延迟。

3、实时更新的内容:如新闻网站、电商网站等,通过CDN解析接口实现动态内容的快速传输。

4、需要保障安全性和稳定性的网站:通过CDN解析接口提供的安全措施,保障数据传输的安全性。

五、相关问题与解答

1、什么是CDN解析?

答:CDN解析是将域名解析到最优的CDN节点,以便用户能够快速加载网站内容的过程,它是CDN服务中的一部分,通过智能调度和缓存机制,优化用户体验,减少延迟。

2、如何判断一个链接是否是CDN链接?

答:判断一个链接是否是CDN链接可以通过以下几个特征:CDN链接通常使用了CDN服务商的域名作为链接的一部分;CDN链接的URL可能包含特定的路径或参数,用于指定要加速的内容或进行其他配置;CDN链接的请求响应时间通常比普通链接快。