如何将数据库数据导出到Excel?

- 行业动态

- 2025-03-07

- 9

一、使用ODBC(开放数据库连接)

1、配置数据源

在Windows系统中,需要先配置数据源,可以通过“控制面板” -> “管理工具” -> “数据源(ODBC)”来添加系统DSN(数据源名称),如果要连接SQL Server数据库,选择对应的SQL Server驱动程序,然后填写数据源名称、服务器名称、登录ID和密码等信息。

2、在C语言中包含必要的头文件

要使用ODBC相关的函数,需要包含<sql.h>和<sqlext.h>头文件,这些头文件提供了与ODBC API交互所需的函数声明和数据类型定义。

3、建立与数据库的连接

调用SQLAllocHandle函数为环境句柄分配内存,然后使用SQLSetEnvAttr设置环境属性,如ODBC版本等,接着为连接句柄分配内存,并通过SQLConnect函数连接到之前配置好的数据源。

SQLHENV env; SQLHDBC dbc; SQLAllocHandle(SQL_HANDLE_ENV, SQL_NULL_HANDLE, &env); SQLSetEnvAttr(env, SQL_ATTR_ODBC_VERSION, (void)SQL_OV_ODBC3, 0); SQLAllocHandle(SQL_HANDLE_DBC, env, &dbc); SQLCHAR outstr[1024]; SQLSMALLINT outstrlen; SQLDriverConnect(dbc, NULL, (SQLCHAR)"DSN=your_dsn_name;", SQL_NTS, outstr, sizeof(outstr), &outstrlen, SQL_DRIVER_NOPROMPT);

4、执行SQL查询获取数据

使用SQLAllocHandle为语句句柄分配内存,然后通过SQLExecDirect函数执行SQL查询语句,要查询某个表中的所有数据:

SQLHSTMT stmt; SQLAllocHandle(SQL_HANDLE_STMT, dbc, &stmt); SQLExecDirect(stmt, (SQLCHAR)"SELECT FROM your_table", SQL_NTS);

5、读取查询结果并写入Excel文件

可以使用第三方库如libxl来创建和操作Excel文件,首先初始化libxl的相关结构体,然后遍历查询结果,将数据写入Excel的单元格中。

// 假设已经包含了libxl相关头文件并正确初始化了libxl结构体

libxl_book_t book = libxl_book_alloc();

libxl_sheet_t sheet = libxl_sheet_alloc(book, "Sheet1");

int row = 0;

while (SQLFetch(stmt) == SQL_SUCCESS) {

int col = 0;

for (int i = 1; i <= number_of_columns; i++) {

char data[256];

SQLGetData(stmt, i, SQL_C_CHAR, data, sizeof(data), NULL);

libxl_write_cell(sheet, row, col, data);

col++;

}

row++;

}

libxl_save_book(book, "output.xlsx"); 6、清理资源

需要释放所有分配的资源,包括语句句柄、连接句柄、环境句柄以及libxl相关的资源。

SQLFreeHandle(SQL_HANDLE_STMT, stmt); SQLDisconnect(dbc); SQLFreeHandle(SQL_HANDLE_DBC, dbc); SQLFreeHandle(SQL_HANDLE_ENV, env); libxl_free_book(book);

二、使用数据库特定的API(以MySQL为例)

1、包含MySQL客户端库头文件

在使用MySQL C API时,需要包含mysql/mysql.h头文件,这个头文件定义了与MySQL数据库交互的各种函数和数据类型。

2、连接到MySQL数据库

首先创建MYSQL结构体实例,然后使用mysql_real_connect函数连接到数据库,需要提供数据库主机名、用户名、密码、数据库名等参数。

MYSQL conn;

conn = mysql_init(NULL);

if (!mysql_real_connect(conn, "localhost", "username", "password", "database_name", 0, NULL, 0)) {

fprintf(stderr, "%s

", mysql_error(conn));

exit(1);

} 3、执行查询获取数据

使用mysql_query函数执行SQL查询语句,然后通过mysql_store_result获取查询结果集。

if (mysql_query(conn, "SELECT FROM your_table")) {

fprintf(stderr, "%s

", mysql_error(conn));

exit(1);

}

MYSQL_RES result = mysql_store_result(conn); 4、读取查询结果并写入Excel文件

同样可以使用libxl库来创建和操作Excel文件,通过mysql_fetch_row函数逐行读取查询结果,并将数据写入Excel单元格中。

libxl_book_t book = libxl_book_alloc();

libxl_sheet_t sheet = libxl_sheet_alloc(book, "Sheet1");

int row = 0;

MYSQL_ROW row_data;

while ((row_data = mysql_fetch_row(result))) {

for (int col = 0; col < mysql_num_fields(result); col++) {

libxl_write_cell(sheet, row, col, row_data[col]);

}

row++;

}

libxl_save_book(book, "output.xlsx"); 5、清理资源

释放查询结果集和关闭数据库连接。

mysql_free_result(result); mysql_close(conn); libxl_free_book(book);

三、注意事项

错误处理:在上述过程中,无论是使用ODBC还是特定数据库API,都需要进行充分的错误处理,检查每个函数的返回值,对于可能出现的错误情况(如连接失败、查询执行失败等),要及时输出错误信息并进行适当的处理,避免程序崩溃或出现不可预期的行为。

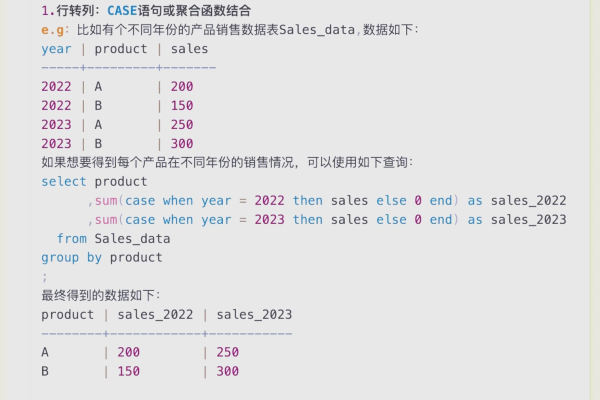

数据类型转换:从数据库中获取的数据类型可能与写入Excel时期望的数据类型不同,数据库中的日期类型可能需要转换为字符串类型后再写入Excel,在进行数据类型转换时,要确保转换的正确性,避免数据丢失或格式错误。

性能优化:如果数据库中的数据量较大,一次性读取所有数据可能会导致内存不足或性能下降,可以考虑分批次读取数据,每次读取一部分数据进行处理,以提高程序的性能和稳定性。

四、相关问答FAQs

问题1:如果数据库中有大量数据,使用上述方法导出到Excel时性能很差,有什么优化建议?

答:可以采用分页查询的方式,每次只查询一部分数据(每次查询1000条记录),然后将这部分数据写入Excel,这样可以避免一次性加载大量数据导致的内存占用过高和性能下降问题,还可以考虑在服务器端进行数据处理和文件生成,而不是在客户端(C语言程序)进行,利用服务器的强大计算能力和资源来提高性能。

问题2:使用ODBC连接数据库时,出现“数据源名称未找到”的错误,可能是什么原因?

答:可能有以下原因,一是没有正确配置数据源,需要检查在“数据源(ODBC)”管理器中是否正确添加了数据源名称、驱动程序等信息,二是在C语言程序中指定的数据源名称与实际配置的名称不匹配,要确保程序中使用的数据源名称与配置时的名称完全一致,三是可能存在环境变量或权限问题,导致程序无法正确访问数据源配置信息,可以尝试以管理员身份运行程序或者检查相关环境变量是否正确设置。