Discuz ISAPI CGI是什么?它在论坛系统中扮演什么角色?

- 行业动态

- 2025-01-20

- 10

Discuz ISAPI CGI

ISAPI和CGI是两种常用的Web服务器接口技术,它们在功能和性能上各有特点,本文将详细介绍这两种技术的区别、优缺点以及在Discuz论坛中的应用。

ISAPI与CGI

通用网关接口(CGI)是一种允许Web服务器执行外部程序的标准接口,CGI程序通常以独立的可执行文件形式存在,通过URL调用或表单提交来激活,CGI的跨平台性能极佳,几乎可以在任何操作系统上实现,如DOS、Windows、Unix等。

互联网服务器应用程序编程接口(ISAPI)是微软提供的一种面向互联网服务的API接口,能够实现CGI的全部功能并进行扩展,ISAPI应用程序以动态链接库(DLL)的形式存在,可以在同一进程空间内运行,从而提高了效率。

性能对比

| 特性 | CGI | ISAPI |

| 执行方式 | 独立进程,每个请求启动一个新进程 | 共享进程,多个请求可以复用同一个DLL实例 |

| 资源消耗 | 高,每个请求都需要创建和销毁进程,占用大量系统资源 | 低,多个请求共享同一进程,资源利用率更高 |

| 平台兼容性 | 跨平台,支持多种操作系统 | 仅限于微软Windows操作系统 |

| 开发语言 | 多种语言,如C、Perl、Shell、VB等 | 主要使用Visual C++、Visual Basic、Borland C++等 |

| 安全性 | 相对较低,可能受到模拟线程攻击 | 相对较高,但需要确保线程安全 |

| 应用场景 | 简单交互式应用,如用户注册、留言板等 | 高性能需求的应用,如大型网站、电子商务平台等 |

ISAPI与CGI的具体区别

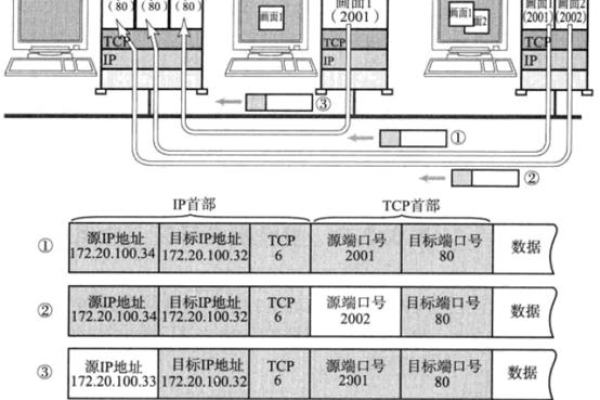

1、执行方式:CGI程序作为独立进程运行,每个请求都会启动一个新的进程,而ISAPI则作为DLL加载到Web服务器进程中,多个请求可以共享同一个DLL实例。

2、资源消耗:由于CGI每次请求都启动新进程,资源消耗较大;ISAPI则因为多个请求共享同一进程,资源利用更加高效。

3、平台兼容性:CGI具有较好的跨平台性能,可以在多种操作系统上运行;ISAPI则仅限于微软Windows操作系统。

4、开发语言:CGI支持多种编程语言,而ISAPI主要使用微软的开发工具,如Visual C++、Visual Basic等。

5、安全性:CGI的安全性相对较低,容易受到模拟线程攻击;ISAPI则需要确保线程安全,避免因多线程带来的安全问题。

6、应用场景:CGI适用于简单的交互式应用,如用户注册或留言板;ISAPI则更适合高性能需求的应用,如大型网站或电子商务平台。

ISAPI筛选器的作用

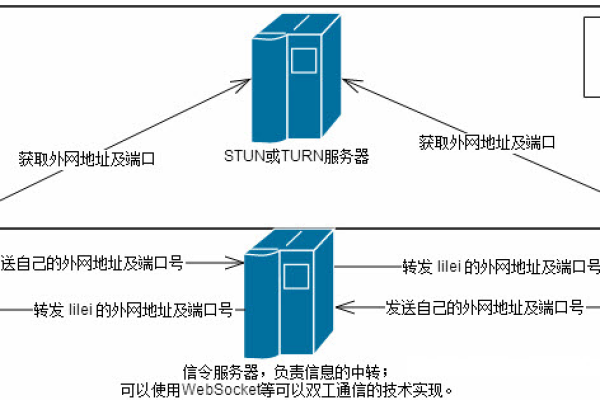

ISAPI筛选器是在启用ISAPI的HTTP服务器上运行的DLL,用于筛选与服务器之间来回传送的数据,筛选器可以注册事件通知,例如登录或URL映射,当发生选定事件时被调用,可以监视及更改数据,这使得ISAPI筛选器非常适合进行增强的HTTP请求记录、自定义加密、自定义压缩或其他身份验证方法。

常见问题解答

问:如何将PHP从CGI模式转换为ISAPI模式?

答:要将PHP从CGI模式转换为ISAPI模式,首先需要安装ISAPI模块,然后在IIS中配置处理程序映射,将*.php映射到FastCgiModule并指定PHP解释器的路径,还需要确保PHP版本支持ISAPI模式,建议使用5.2.x版本的PHP。

问:ISAPI和CGI在性能上有何差异?

答:ISAPI的性能优于CGI,因为ISAPI作为DLL加载到Web服务器进程中,多个请求可以共享同一进程,减少了创建和销毁进程的开销,而CGI每次请求都会启动一个新进程,资源消耗较大,效能较低。

小编有话说

在选择ISAPI还是CGI时,需要根据具体的应用场景和需求来决定,如果需要跨平台支持和简单的交互式应用,可以选择CGI;如果追求高性能和资源利用率,ISAPI则是更好的选择,无论选择哪种技术,都需要确保代码的安全性和稳定性,以提供最佳的用户体验。