如何在Linux运维领域开辟盈利渠道?

- 行业动态

- 2024-09-16

- 4604

在当今的互联网时代,服务器和网络系统的稳定运行是企业能否顺畅开展业务的关键,Linux运维工作显得尤为重要,其涉及保障系统的正常运行、优化系统性能、确保数据安全等多项关键任务,对于从事该职业的专业人士来说,掌握Linux运维技能不仅有助于职业发展,还开辟了多元化的收入来源,下面将详细探讨Linux运维赚钱的多个方面:

1、提升专业技能

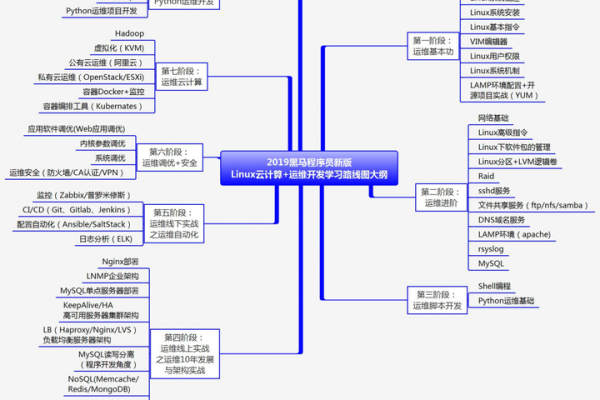

系统学习Linux知识:作为Linux运维人员,首先必须掌握Linux的基础知识,包括文件系统、进程管理、用户权限等,还需要熟悉网络知识,如TCP/IP协议、DNS配置等。

掌握运维工具和编程:必须熟练使用各类运维工具,比如Ansible、Puppet等自动化运维工具,并至少掌握一门编程语言,如Python或Shell,以便编写自动化脚本,提升工作效率。

高级技能的积累:随着职业的发展,还应学习更复杂的技术,如系统安全、虚拟化技术和容器技术(如Docker、Kubernetes)等,这些技能可以帮助运维人员处理更复杂的问题,从而承担更高级别的工作和自由职业项目。

2、建立个人服务

提供系统部署服务:可以向中小企业或个人提供Linux系统的安装、配置和优化服务,这些客户往往没有专业的IT团队,但对于服务器稳定运行有较高的需求。

网络和数据库维护:许多公司或个人需要对其网络进行设置或优化,数据库的维护也是常见的需求之一,提供这类服务可以获得稳定的客户群。

安全咨询服务:随着网络安全威胁的增加,提供系统安全咨询和服务也成为了一个有利可图的市场,这包括但不限于系统破绽检测、防火墙配置和载入检测系统的设置。

3、定价策略和市场营销

合理定价:定价时必须考虑到市场竞争、客户的支付能力以及自身的服务水平,合理的定价策略能够帮助吸引更多的客户,同时确保服务的高质量。

品牌建设:通过建立专业的在线平台,如个人网站或博客,展示个人的服务项目、案例研究和客户评价,可以提高个人品牌的可信度和知名度。

利用社交平台:充分利用LinkedIn、GitHub等专业社交平台,展示个人技能和项目经验,增加与潜在客户的互动,扩大人脉圈,有助于获取更多的合作机会。

4、远程工作和兼职机会

参与开源项目:加入开源项目不仅可以提高技术能力,还可以通过贡献代码、文档等方式在社区中建立声誉,这对职业生涯大有裨益。

远程兼职岗位:很多公司倾向于雇佣兼职或远程工作者来降低运营成本,通过平台如Upwork、Freelancer等可以找到相关的远程工作机会。

5、就业方向的选择

系统运维工程师:负责维护和管理企业的服务器和网络设备,确保系统稳定运行,这是最基础的运维岗位。

自动化运维工程师:通过编写脚本和利用自动化工具,提高系统管理的效率和准确性,减少人为错误,对企业尤其是大型企业来说至关重要。

云计算运维工程师:随着企业越来越多地采用云服务,云计算运维工程师的需求也在增加,职责包括管理和优化云资源,保障云服务的稳定性和安全性。

在探讨了Linux运维如何赚钱后,还需要考虑一些其他因素,以确保业务的持续发展和个人职业生涯的稳步提升,对于刚入行的新手以及想要扩展服务的资深专业人士,不断学习新技术和保持对市场动态的关注是必要的,了解最新的云技术和网络安全趋势能够提供更全面的服务,从而吸引更广泛的客户群,建立良好的客户关系也是不可忽视的一环,定期与客户沟通,了解他们的需求和反馈,可以不断调整服务内容,提高客户满意度。

作为一名Linux运维专家,有多种途径可以实现职业发展和收入增长,无论是通过提升个人技能、建立个人服务,还是通过远程工作和选择合适的就业方向,关键在于不断提升自己的专业技能,并保持对新技的学习和掌握,建立个人品牌和良好的客户关系也是成功的重要因素。

本站发布或转载的文章及图片均来自网络,其原创性以及文中表达的观点和判断不代表本站,有问题联系侵删!

本文链接:http://www.xixizhuji.com/fuzhu/69260.html