购买云服务器时是否还需另外配置数据库?选错规格的L实例如何进行更换?

- 行业动态

- 2024-08-31

- 11

购买云服务器后是否还需购买数据库取决于您的具体需求和预期的数据处理量,对于大多数中小型项目,在云服务器上自行搭建数据库通常是可行的,如果涉及到大量数据处理或需要高可用性、安全性以及高性能的情况,那么单独购买专业的云数据库服务就变得必要,至于L实例买错规格的问题,可以通过升级实例规格来解决。

买云服务器还用买数据库吗?

购买云服务器后是否需要再购买数据库服务,主要取决于以下几个因素:

1、项目规模

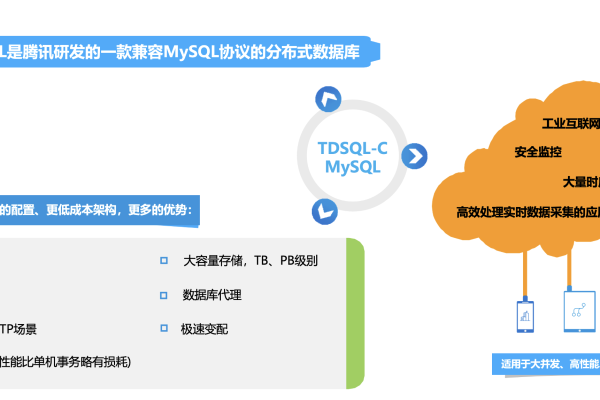

小型项目:对于多数中小型项目,开发者完全可以在云服务器上自行安装并配置所需的数据库软件,例如MySQL、PostgreSQL等,这种方式初期可以节省成本,同时满足项目的基本需求。

大型项目:当项目数据量巨大或访问量很高时,自行搭建的数据库可能无法满足性能需求,此时建议购买专业的云数据库服务。

2、性能需求

性能与优化:专业云数据库服务通常提供更优秀的性能、自动备份、安全更新和高级优化等功能,这些是自行搭建难以比拟的。

扩展性:云数据库服务如AWS RDS或Azure SQL Database等,提供了很好的弹性扩展能力,能够根据实际需求动态调整资源。

3、成本考量

初始成本:对于初创企业或预算有限的项目,开始时可以在云服务器上自行搭建数据库以降低初期成本。

长期成本:虽然初期自建数据库成本较低,但随着业务的扩展和数据的增长,管理和维护的复杂性及成本可能会超过专业数据库服务的费用。

4、维护与管理

自行搭建:需要开发者有较强的技术背景来进行安装、配置和维护,自行处理数据库的备份、恢复和升级等操作相对复杂且耗时。

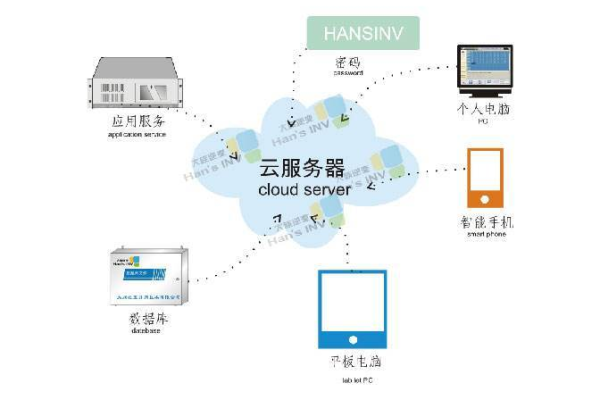

云数据库服务:通常由供应商负责维护和管理,减少了系统管理员的工作负担,让团队可以专注于业务开发和其他核心技术问题。

5、安全性考虑

数据安全:云数据库服务提供了更为严格和可靠的安全措施,如网络隔离、数据加密和访问控制等。

合规要求:对于需要符合特定行业标准或法规要求的项目,使用专业的云数据库服务更容易达到这些标准。

L实例买错规格了怎么换?

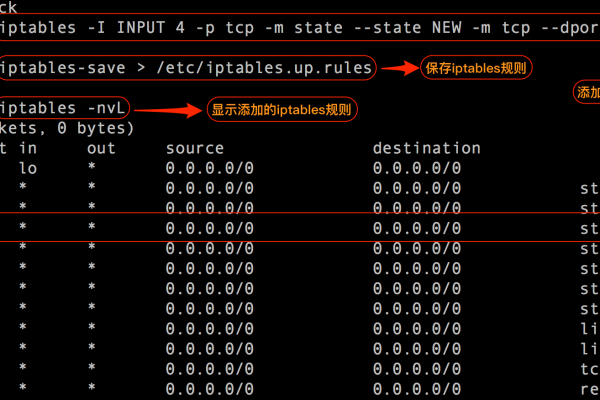

当发现购买的L实例规格不符合需求时,可以通过以下步骤进行规格更换:

1、确定需求

评估当前需求与未来扩展:清晰了解当前项目的需求和未来可能的发展,以便选择适合的实例规格。

性能与成本考量:比较不同规格的性能指标与价格,找到性价比最高的选项。

2、选择变更方式

直接升级实例规格:大多数云服务提供商支持直接升级实例规格,但一般不支持降级。

退订后重新购买:如果升级选项不满足需求或成本过高,可以考虑退订现有实例并重新购买合适的规格。

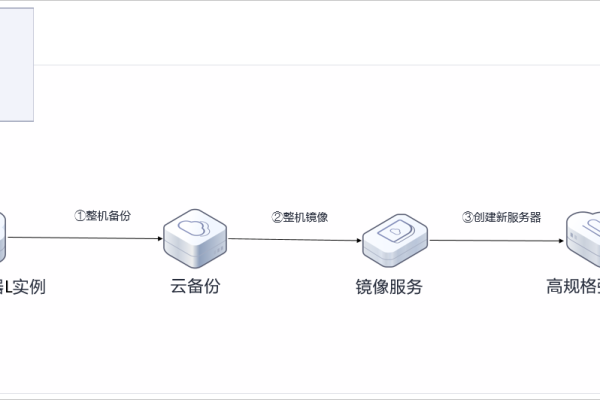

3、备份重要数据

数据备份:在进行任何硬件变更之前,确保所有重要数据和配置都有完整的备份,以防数据丢失。

检查兼容性:确认新规格的实例兼容现有的应用软件和数据。

4、执行升级或更换

选择合适的时间窗口:计划在访问量较低的时段执行升级或更换操作,减少对业务的影响。

遵循提供商指导:严格按照云服务提供商的指导文档操作,以确保过程的平滑和安全。

5、测试并优化

全面测试:升级或更换后进行全面的功能和性能测试,确保一切运行正常。

优化配置:根据新的实例规格调整和优化应用配置,以充分利用新资源。

通过以上步骤,可以有效地解决买错L实例规格的问题,确保您的项目能够在适合的硬件上平稳运行。

相关问答FAQs

Q1: 如何知道我是否需要购买额外的云数据库服务?

A1: 考虑以下几个指标:项目的数据量和访问量、预期的系统性能、可维护性和安全性需求,如果你的项目数据增长快,对性能和安全性要求高,那么购买专业的云数据库服务是有益的,反之,如果项目较小,初始阶段可以在云服务器上自行搭建数据库。

Q2: 如果升级实例规格后应用程序出现兼容性问题怎么办?

A2: 在升级前,应该详细检查新规格的兼容性,并与应用程序供应商或开发团队确认,如果确实遇到问题,可以先回滚到旧的实例规格,然后分析问题所在,寻求技术支持,或调整应用程序配置以适应新环境。