MySQL函数去重时日志重复或丢失,原因何在?

- 行业动态

- 2024-09-01

- 2648

MySQL数据库_日志出现重复或丢失的原因可能包括:1) 数据库未正常关闭;2) 系统崩溃或断电;3) 硬件故障;4) 存储引擎的问题;5) 并发事务冲突;6) 网络问题等。

在数据库管理与操作过程中,数据去重是一个常见且重要的需求,特别是在使用MySQL这类关系型数据库时,由于数据输入错误、系统异常或操作不当等原因,可能会产生重复的日志记录,这些重复或丢失的日志不仅占用存储空间,还可能影响数据的统计分析和后续的数据质量,有效地识别和处理这些重复日志至关重要,本文将深入探讨MySQL中日志重复和丢失的原因,并提供相应的解决策略。

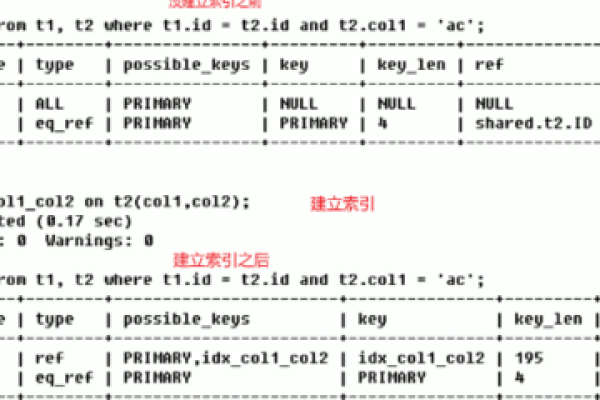

我们来看看MySQL中日志重复的主要原因,一种常见的情况是在数据导入过程中,由于缺乏有效的数据验证机制,相同的数据被多次导入,应用程序逻辑错误也可能导致生成重复的日志条目,在事务处理中,如果同一个操作被错误地执行多次而没有适当的检查,就可能产生重复日志,系统故障,如意外的服务器重启或数据库服务中断,也可能在恢复过程中导致日志重复。

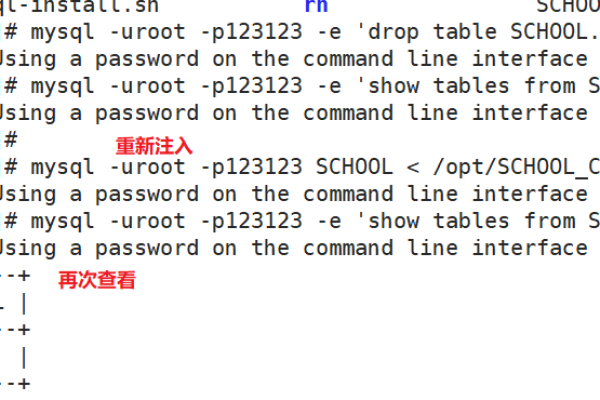

针对日志重复的问题,MySQL提供了多种解决方案,使用DELETE语句结合子查询是一种直接的方法,可以通过以下SQL命令实现:

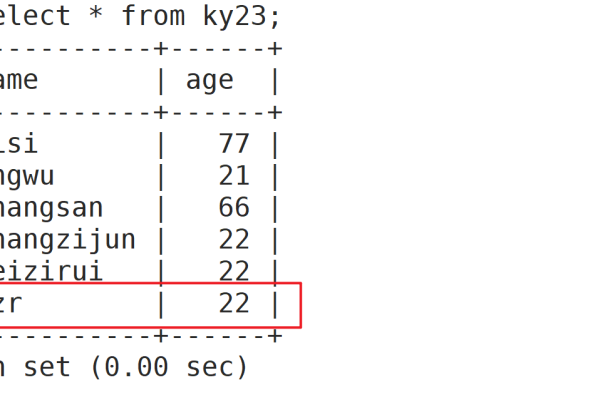

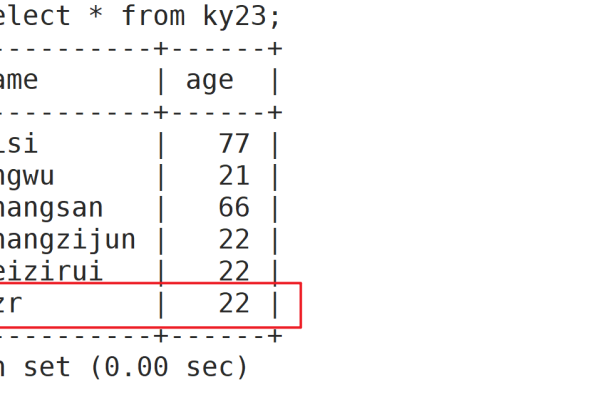

DELETE t1 FROM your_table t1, your_table t2 WHERE t1.id < t2.id AND t1.column_name = t2.column_name;

这条命令将删除your_table中所有与其他行在column_name上具有相同值且id较小的行,从而保留id最大的那一行。

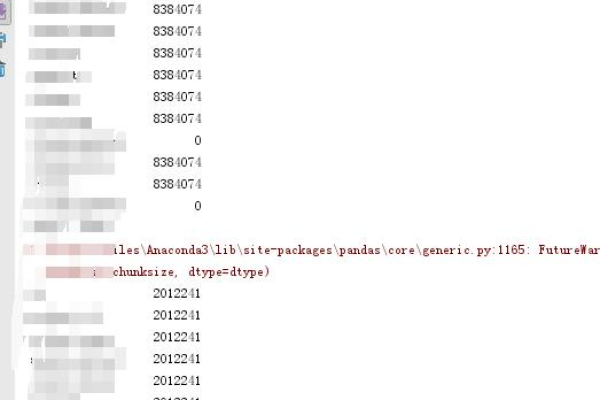

窗口函数如ROW_NUMBER()也是非常强大的工具,通过为结果集中的每一行分配一个唯一的序号,可以根据特定顺序(如时间戳或ID)决定哪些行是重复的,并据此进行删除。

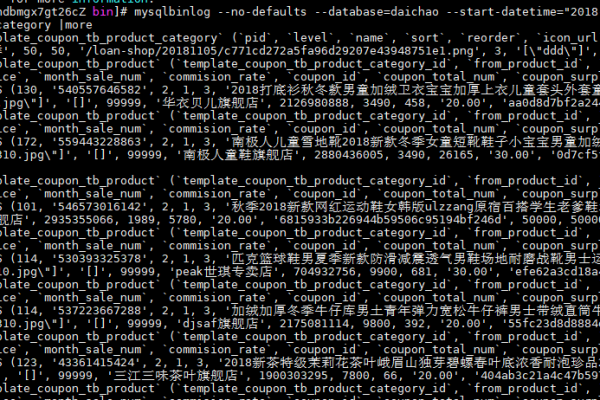

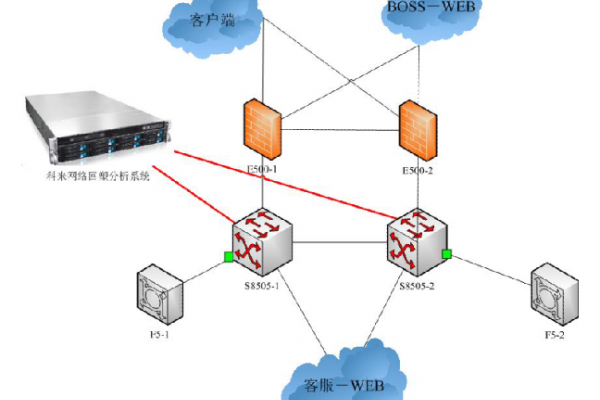

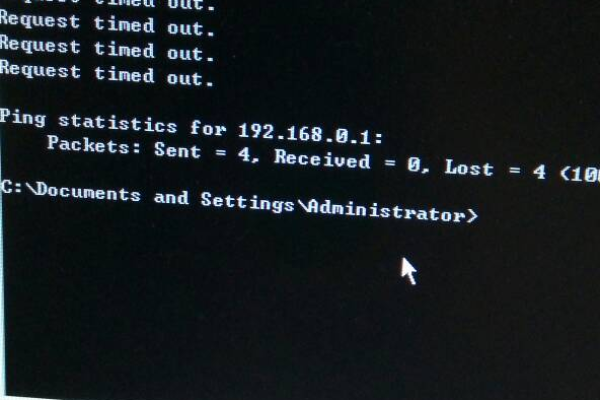

对于日志丢失问题,原因可能包括数据库备份和恢复操作不当、网络问题导致的数据传输失败,或者数据库软件本身的bug,在进行数据库复制或镜像时,如果网络连接不稳定,一些交易日志可能在传输过程中丢失,存储介质的损坏也可能导致数据丢失。

解决日志丢失的首要步骤通常是恢复从最后一次成功备份开始的数据,MySQL提供了多种数据恢复方法,如使用mysqlbinlog工具来读取二进制日志文件,这可以帮助找回未写入数据库的交易,确保所有数据库操作都有完整的事务日志记录,可以最大限度地减少数据丢失的风险。

归纳而言,MySQL数据库中日志的重复和丢失问题可以通过多种技术手段来解决,通过合理配置数据库、优化应用逻辑、及时做好数据备份和采取恰当的恢复措施,可以有效避免这些问题的发生,理解并运用正确的数据处理和清理策略,对于维护数据完整性和准确性至关重要。

相关问答 FAQs

Q1: 如何选择合适的去重策略?

A1: 选择去重策略时需要考虑数据的特点和业务需求,如果数据量不大,可以考虑使用简单的DELETE语句,对于大数据量,使用窗口函数如ROW_NUMBER()可能更高效,因为它们可以在一个查询中完成去重,减少读写次数。

Q2: 如何预防日志的重复和丢失?

A2: 预防日志重复和丢失的最佳方法是确保良好的数据库设计和严格的事务管理,定期进行数据备份,使用稳定的数据库和服务器硬件,以及监控数据库性能和日志文件的完整性,都是防止问题发生的有效措施。

本站发布或转载的文章及图片均来自网络,其原创性以及文中表达的观点和判断不代表本站,有问题联系侵删!

本文链接:http://www.xixizhuji.com/fuzhu/68677.html