MapReduce API 如何优化数据处理性能?

- 行业动态

- 2024-09-01

- 1

MapReduce API是大数据处理中非常关键的一个技术接口,它为开发人员提供了一套编写分布式计算程序的规范和工具,通过MapReduce,复杂的数据处理任务可以在大量的机器节点上并行处理,从而有效支持海量数据集的分析,下面详细介绍MapReduce API的核心组件、功能以及使用场景:

1、MapReduce的基本概念

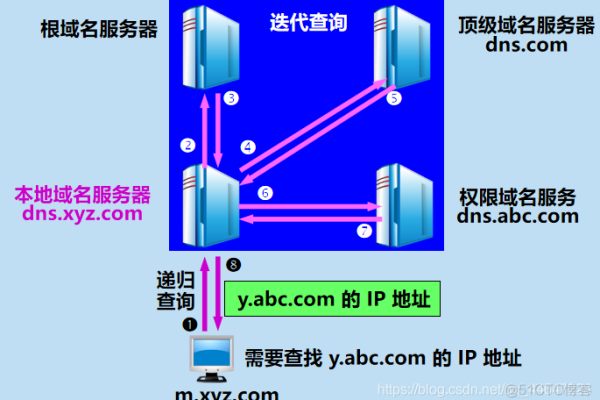

定义与阶段:MapReduce是一个分布式计算框架,分为Map(映射)和Reduce(归约)两个阶段,在Map阶段,系统将输入数据分成多个独立的数据块,每个数据块由一个Map任务处理生成键值对;在Reduce阶段,根据键将Map阶段的输出聚合起来,进行归约操作。

为什么需要MapReduce:由于单机在处理海量数据时存在硬件资源的限制,分布式运算程序的开发和运行复杂度高,因此引入了MapReduce框架来简化开发并提升效率。

2、核心API组件

Job类和JobConf接口:用户可以通过org.apache.hadoop.mapreduce.Job类来提交和管理MapReduce作业,例如设置作业参数、提交作业等,org.apache.hadoop.mapred.JobConf是MapReduce作业的配置类,用于设定各种参数,如输入输出格式、减少任务的数量等。

Map和Reduce接口:开发者需要实现Map和Reduce接口,编写处理数据的业务逻辑,在Map阶段,通常进行数据的过滤和转换;在Reduce阶段,则进行数据的聚合操作。

3、编程模型和数据处理流程

数据输入与输出:MapReduce作业的数据输入通常是HDFS(Hadoop Distributed File System)中的文件,输出可以是文件或者其他存储系统,在Map阶段,系统会自动分割输入数据成小块,并分配给不同的Map任务处理。

数据流:Map任务执行后,其输出的键值对会根据键进行排序和分区,确保具有相同键的值被发送到同一个Reduce任务,Reduce任务聚合这些值,产生最终结果。

4、容错性和系统性能

容错机制:MapReduce框架设计了有效的错误处理机制,可以自动重新执行失败的任务,无需人工干预,这对于处理大规模数据集非常重要,因为机器故障是常态。

优化技巧:为了优化作业的执行效率,可以考虑合适的数据结构、优化算法和合理设置Reduce任务的数量等措施。

MapReduce API是处理大规模数据集的强有力工具,通过合理的API使用和优化,可以显著提高数据处理的效率和可靠性,对于初学者而言,理解其基本工作原理和如何利用其接口进行编程是基础;对于经验丰富的开发者,则更应关注如何优化作业配置和业务逻辑,以达到最佳的性能表现。

本站发布或转载的文章及图片均来自网络,其原创性以及文中表达的观点和判断不代表本站,有问题联系侵删!

本文链接:http://www.xixizhuji.com/fuzhu/68397.html