Android调用JS的实现方式及注意事项

- 行业动态

- 2025-03-07

- 6

Android调用JS的详细方法

在Android开发中,与JavaScript进行交互是一个常见需求,特别是在需要将Web功能集成到原生应用中时,以下是几种常见的Android调用JS的方法:

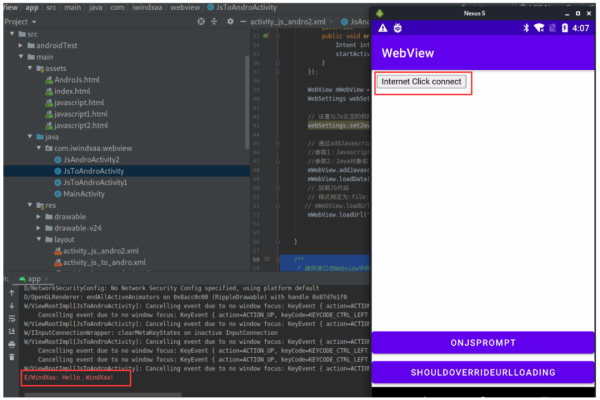

1、通过WebView加载网页并调用JavaScript代码

初始化WebView:需要在布局文件中添加一个WebView组件,并在Activity或Fragment中初始化它。

启用JavaScript支持:确保WebView启用了JavaScript支持,这可以通过设置WebSettings来实现。

加载网页内容:WebView可以加载本地的HTML文件或远程的URL。

调用JavaScript代码:在网页加载完成后,可以使用WebView的loadUrl方法或evaluateJavascript方法来调用JavaScript代码。

2、通过JavaScript Interface与JavaScript进行交互

定义JavaScript接口类:创建一个继承自Object类(或任意其他合适的基类)的类,并在其中定义一些公共方法,使用@JavascriptInterface注解标记这些方法,以便它们能够在JavaScript中被调用。

向WebView添加JavaScript接口:使用addJavascriptInterface方法将JavaScript接口添加到WebView中。

在JavaScript中调用接口方法:在JavaScript代码中,可以通过接口名称(即在addJavascriptInterface方法中传入的别名)来调用接口中的方法。

3、通过JavaScript Bridge进行更高级的交互

引入JS Bridge库:需要在项目中引入相应的桥接库,如Android JS Bridge。

配置WebView:在Activity中配置WebView,并绑定桥接接口。

注册Handler:在Android中定义并注册Handler,用于处理JavaScript的调用。

在JavaScript中调用Handler:在JavaScript中,可以使用桥接方法调用Android代码。

相关单元表格

| 方法 | 描述 | 优点 | 缺点 |

| 通过WebView加载网页并调用JavaScript代码 | 使用WebView的loadUrl或evaluateJavascript方法直接执行JavaScript代码 | 简单直接,适用于基本的JavaScript调用 | 只能在页面加载完成后调用,否则JavaScript代码可能执行失败 |

| 通过JavaScript Interface与JavaScript进行交互 | 定义一个Java类,使用@JavascriptInterface注解暴露方法给JavaScript调用 | 实现双向交互,JavaScript可以调用Android方法 | 需要注意安全性问题,避免暴露敏感操作给未经验证的网页 |

| 通过JavaScript Bridge进行更高级的交互 | 使用桥接库实现Android和JavaScript的双向通信 | 功能强大,支持复杂的交互需求 | 设置较为复杂,需要引入额外的库 |

相关问题与解答

1、问:如何在Android中调用JS的alert函数?

答:可以在JavaScript代码中直接定义alert函数,并在Android中使用evaluateJavascript或loadUrl方法调用它,在JavaScript中定义function showAlert(message) { alert(message); },然后在Android中调用webView.evaluateJavascript("showAlert('Hello from Android')", null);。

2、问:如何确保在Android中调用JS代码时的安全性?

答:为了确保安全性,可以采取以下措施:

使用@JavascriptInterface注解时限制接口方法的访问范围,避免暴露不必要的方法给JavaScript。

对从JavaScript传递到Android的数据进行验证和过滤,防止注入攻击等安全风险。

避免在WebView中加载不受信任的网页内容,特别是当使用addJavascriptInterface方法时。