CDN加速器如何优化网站性能和用户体验?

- 行业动态

- 2024-10-08

- 16

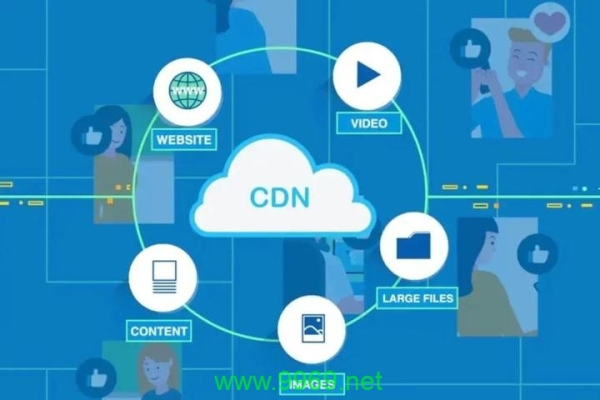

CDN加速器是一种通过内容分发网络(Content Delivery Network)技术,实现网站、图片、音视频等多业务内容的快速、稳定、安全、可靠地全球分发加速服务,以下是对CDN加速器的详细介绍:

CDN加速器的基本概念

1、定义:CDN即内容分发网络,其核心原理是将服务内容分发至全网加速节点,使用户能够从就近的服务器节点上获取所需内容,从而显著提高网站的访问速度和用户体验。

2、工作原理:当用户访问使用CDN服务的网站时,本地DNS服务器会通过CNAME方式将域名请求重定向到CDN服务,然后CDN会根据预设的策略(如内容类型、地理区域、网络负载状况等),将能够最快响应用户的CDN节点IP地址提供给用户,使用户可以以最快的速度获取网站内容。

3、节点分布:CDN加速器通常拥有大量的全球或国内节点,这些节点覆盖了不同的地区和运营商,确保用户无论身处何地都能获得快速的访问速度。

CDN加速器的主要功能

1、网站加速:适用于有加速需求的网站,包括门户网站、电商平台、资讯APP等,加速各类型图片、html、css、js小文件等。

2、文件下载加速:适用于有文件下载业务的网站、下载工具、游戏客户端等,如游戏安装包获取、应用程序包下载等场景。

3、点播加速:适用于提供音视频点播服务的客户,如在线教育类网站、在线视频分享网站等。

4、全站加速:适用于各行业动静态内容混合,含较多动态资源请求(如asp、jsp、php等格式的文件)的网站。

CDN加速器的优势

1、提高访问速度:通过将内容缓存到离用户更近的节点上,CDN加速器可以显著减少数据传输距离和时间,从而提高网站的访问速度。

2、增强稳定性:CDN加速器通过智能调度和负载均衡技术,可以有效应对高并发访问和网络波动,提高网站的稳定性。

3、提升安全性:CDN加速器通常配备有完善的安全机制,如DDoS防护、WAF防护等,可以有效抵御各种网络攻击,保障网站的安全运行。

4、节省成本:对于中小型网站来说,许多CDN服务商提供免费或低成本的CDN服务,可以帮助网站在有限的预算内实现加速效果。

常见的CDN加速器服务商

1、腾讯云CDN:腾讯云提供的CDN服务,具有丰富的节点资源和强大的技术支持。

2、阿里云CDN:阿里云的CDN服务以其稳定的性能和广泛的节点覆盖而受到用户的青睐。

3、七牛云CDN:七牛云专注于提供高质量的CDN服务,支持多种应用场景。

4、华为云CDN:华为云CDN以其高性能和可靠性著称,广泛应用于各类企业级应用中。

CDN加速器作为一种高效的网站加速解决方案,在提高访问速度、增强稳定性、提升安全性以及节省成本等方面都发挥着重要作用,对于需要优化网站性能的用户来说,选择合适的CDN加速器服务商并合理配置相关参数是至关重要的。

| 特征 | CDN加速器描述 |

| 定义 | CDN加速器是一种通过在全球范围内部署边缘节点来提供网站内容分发服务的技术。 |

| 工作原理 | 将用户请求的内容缓存到离用户最近的服务器上,从而减少数据传输距离,提高访问速度。 |

| 优势 | 提高访问速度 降低带宽成本 提高网站可用性 支持高并发访问 |

| 应用场景 | 大型网站 在线视频和音频流媒体 游戏服务器 在线商店 |

| 类型 | 公共CDN 私有CDN 混合CDN |

| 性能指标 | 吞吐量 延迟 可用性 丢包率 |

| 费用结构 | 按流量计费 按带宽计费 按带宽和流量组合计费 |

| 安全特性 | HTTPS支持 DDoS防护 内容安全策略(CSP) |

| 技术支持 | 24/7技术支持 API集成 多语言支持 |

| 部署方式 | 云服务 自建服务器 虚拟化部署 |