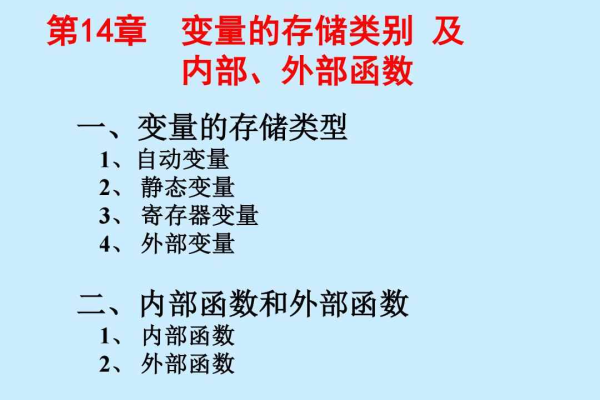

c 变量的存储类型

- 行业动态

- 2025-02-27

- 1

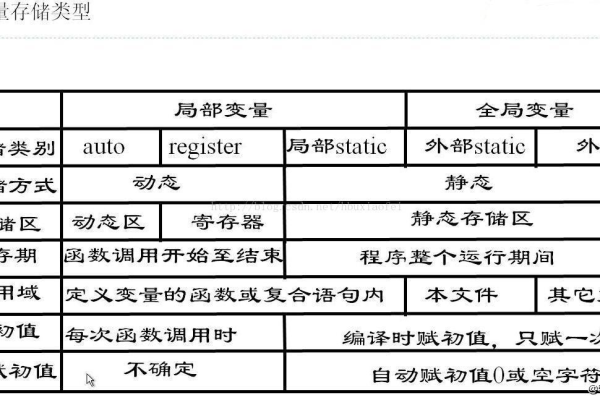

在C语言中,变量的存储类型决定了其在内存中的存储方式、作用域以及生命周期,以下是对C语言中变量存储类型的详细解释:

一、自动变量(auto)

1、定义:使用auto关键字声明的变量称为自动变量,如果函数内部声明一个变量而没有指定存储类型,默认情况下该变量是auto类型。

2、作用域:仅限于声明它的代码块(函数或循环),当控制离开声明它的代码块时,变量会被销毁。

3、生命周期:当控制离开声明它的代码块时,变量会被销毁。

4、示例:

void func() { auto int x = 10; }

二、寄存器变量(register)

1、定义:使用register关键字声明的变量称为寄存器变量,建议编译器将变量存储在CPU寄存器中,以提高访问速度,但最终是否存储在寄存器中由编译器决定。

2、作用域:仅限于声明它的代码块。

3、生命周期:当控制离开声明它的代码块时,变量会被销毁。

4、示例:

void func() { register int y; }

三、静态变量(static)

1、定义:使用static关键字声明的变量称为静态变量,静态变量在整个程序运行期间都存在,但其作用域仅限于声明它的文件或代码块。

2、作用域:如果在函数内部声明,则仅在该函数内可见;如果在文件级别声明,则仅在该文件内可见。

3、生命周期:整个程序运行期间。

4、示例:

void func() { static int z = 0; }

static int a = 10;

四、外部变量(extern)

1、定义:使用extern关键字声明的变量称为外部变量,用于声明一个在其他文件中定义的变量,通常用于多个文件之间共享全局变量。

2、作用域:声明它的文件或代码块。

3、生命周期:整个程序运行期间。

4、示例:

// file1.c

int global_var = 20;

// file2.c

extern int global_var;

C语言提供了多种变量存储类型,以满足不同的编程需求和场景,了解并正确使用这些存储类型,对于编写高效、可维护的C代码至关重要。