服务器怎么安装微擎模块

- 行业动态

- 2025-02-26

- 6

服务器安装微擎模块是一个涉及多个步骤的过程,以下是详细的操作指南:

1、下载源码:

确保从官方渠道或其他信任的源码平台获取微擎源码,下载后的文件通常是一个压缩包,包含所有必要的文件和数据库脚本。

2、上传到服务器:

选择合适的服务器环境,推荐使用Linux系统(如CentOS或Ubuntu),因为它们在性能和安全性上更有优势。

使用FTP工具(如FileZilla)将源码上传到服务器的根目录或指定目录,确保文件夹权限设置正确,一般情况下,设置为755权限。

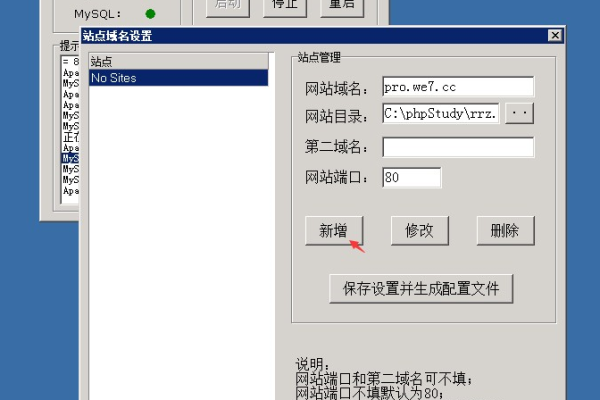

3、配置环境:

确保服务器安装了LAMP(Linux, Apache, MySQL, PHP)或LNMP(Linux, Nginx, MySQL, PHP)环境。

微擎一般需要PHP 7.1或更高版本,并确保安装了必要的PHP扩展,如pdo_mysql、gd、mbstring等。

创建一个新的MySQL数据库,并记录数据库名称、用户名和密码,这些将在安装过程中用到。

4、安装程序:

在浏览器中输入域名或IP地址,进入微擎的安装界面,系统会自动检测服务器环境,并提醒是否满足安装要求。

在安装界面中,输入数据库信息(包括数据库名称、用户名和密码),并设置管理员账号和密码。

系统会自动导入数据库脚本,完成数据库的初始化操作,这个过程可能需要几分钟时间,请耐心等待。

5、完成初始设置:

安装完成后,进入微擎的后台管理界面,进行一些初始设置,包括站点名称、管理员邮箱等。

根据需求,安装所需的功能模块,这些模块可以从微擎的应用市场下载,或者自行上传。

6、相关问答FAQs:

问:如果忘记了微擎后台的账号密码怎么办?

答:可以通过访问数据库中的用户表,修改密码字段来重置密码,或者删除数据库后重新安装微擎,但这样会丢失之前的所有数据。

问:如何更新微擎到最新版本?

答:可以在微擎的官方网站或应用市场下载最新版本的安装包,然后按照上述步骤重新安装,注意备份数据库和重要文件,以防数据丢失。

是服务器安装微擎模块的详细步骤和相关问答,在实际操作过程中,可能会遇到各种问题,建议参考官方文档或寻求专业技术支持。