如何提升服务器速度?揭秘高效运行的秘密!

- 行业动态

- 2025-01-08

- 5

服务器快速响应,处理能力强,稳定性高,是高效运行的关键。

为了提高服务器的速度,可以采取以下几种方法:

1、优化网页内容:压缩图片、删除不必要的代码、使用CDN服务以及利用网页缓存技术来减少网络请求次数,通过这些措施,可以显著减小网页大小,从而加快加载速度。

2、选择合适的主机:根据网站的需求和流量选择合适的主机类型,小型个人网站可以选择共享主机,而大型电商网站则应选择独立服务器或云服务器。

3、确保软件更新:定期检查并更新服务器软件版本,以提高安全性和性能,备份网站数据以防不测。

4、合理配置服务器参数:包括PHP和MySQL配置文件、HTTP服务器设置、内存和磁盘空间等,合理的配置可以避免服务器崩溃或运行缓慢。

5、使用缓存技术:通过浏览器端缓存、CDN缓存、应用程序缓存和数据库缓存等多种缓存技术结合使用,以获得最佳性能提升。

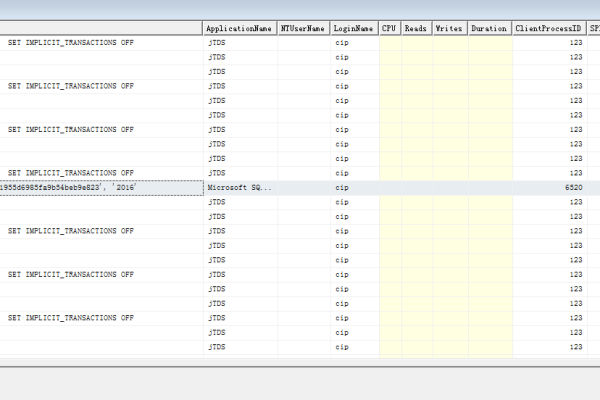

6、优化数据库:使用高速数据库,并在高峰期之前进行数据库备份,使用索引加快数据检索速度,减少冗余数据,优化数据库空间。

7、增加并发处理能力:通过增加服务器硬件配置和使用负载均衡等方式来提升服务器的并发处理能力。

8、使用轻量级框架和插件:选择执行速度快且资源消耗低的轻量级框架和插件,避免使用过于臃肿的框架。

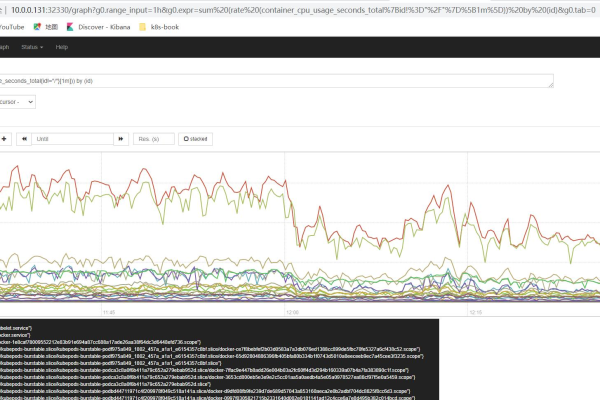

9、监控和优化性能:定期监控服务器性能,并根据监控结果进行优化,使用性能监控工具来检测服务器的负载、响应时间和其他关键性能指标。

通过上述方法的综合应用,可以有效提高服务器的速度,从而提升用户体验和搜索引擎排名,需要注意的是,每种方法都有其适用场景和局限性,因此在实际操作中应根据具体情况灵活运用,持续关注新技术和新方法的发展动态也是非常重要的。