如何有效管理云服务器系统权限以确保数据安全?

- 行业动态

- 2024-09-22

- 10

云服务器系统权限管理是云计算环境中的一项关键功能,它确保了系统的安全和数据的完整性,在云服务器上,系统权限通常涉及对操作系统、网络配置及应用软件的访问控制,合理的权限分配可以防止未授权的访问和潜在的安全威胁,同时保证系统的高效运行。

权限管理的基本原则

最小权限原则:用户仅被赋予完成其工作所必需的权限。

责任分离原则:关键操作应由多个用户或部门共同完成,以减少风险。

审计跟踪原则:所有权限变更和关键操作应被记录并可供审计。

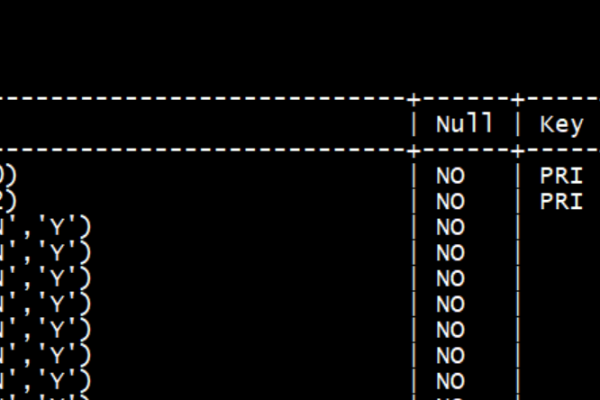

权限类型

云服务器的系统权限通常分为以下几类:

1、系统级权限:涉及操作系统核心组件的访问,如系统文件、注册表(在Windows系统中)等。

2、网络权限:包括对网络配置、端口设置、防火墙规则的修改权限。

3、数据访问权限:涉及数据库、文件存储和其他形式的数据存储的读写权限。

4、应用权限:针对特定应用程序的操作权限,例如安装、配置和执行。

权限分配策略

| 角色 | 权限范围 | 权限内容 |

| 系统管理员 | 全系统 | 操作系统更新、硬件管理、用户账号管理 |

| 网络管理员 | 网络配置 | 配置IP地址、路由、防火墙 |

| 数据库管理员 | 数据库系统 | 管理数据库、执行备份与恢复 |

| 应用管理员 | 特定应用程序 | 部署、维护、更新应用程序 |

| 普通用户 | 受限资源访问 | 访问特定文件或服务 |

权限审核与监控

定期的权限审核和监控系统活动对于维护系统的安全性至关重要,这包括检查异常登录尝试、不寻常的系统改动以及权限使用情况,自动化工具和手动检查的结合可以有效地进行这一过程。

相关问题与解答

Q1: 如果一个用户意外获得了过高的权限,该如何处理?

A1: 应立即撤销该用户的额外权限,以防止任何可能的滥用,审查权限分配流程,找出错误发生的原因,并修正流程以防止未来发生类似问题,对用户的行为进行审计,以确保没有不当行为发生,并加强员工的安全意识教育。

Q2: 如何确保云服务器权限的正确管理?

A2: 正确管理云服务器权限需要实施严格的政策和程序,包括但不限于:使用身份和访问管理(IAM)工具来控制权限分配;实现多因素认证增加安全性;定期进行权限审计;培训员工关于最佳安全实践;并且持续监控和评估权限使用情况,采用自动化工具可以帮助简化权限管理过程,减少人为错误。