CDN审批制度,如何确保内容分发网络的安全与合规?

- 行业动态

- 2025-01-08

- 8

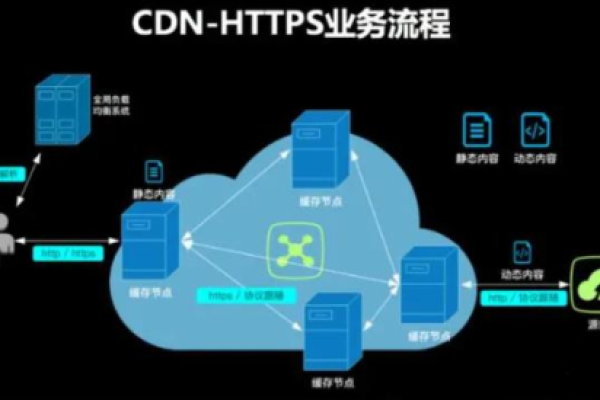

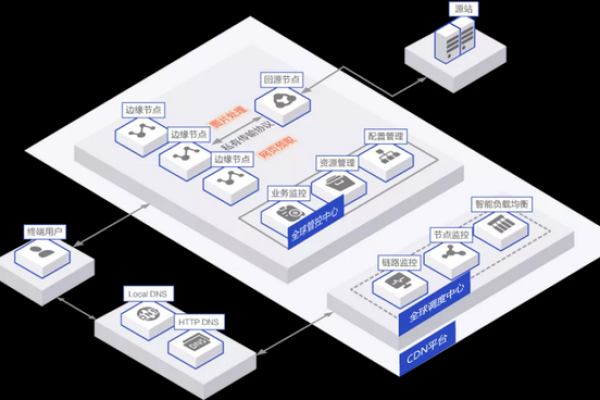

CDN审批制度是指对内容分发网络(CDN)服务提供商进行资质审核和许可管理的一系列流程和规定,这一制度旨在确保CDN服务的合法性、安全性和稳定性,保护用户权益,促进互联网行业的健康发展,以下是关于CDN审批制度的详细介绍:

一、CDN许可证的定义与重要性

CDN许可证,即内容分发网络业务经营许可证,是从事内容分发网络业务的企业必须获取的资质,CDN业务通过分布在不同区域的节点服务器群,为用户提供内容的分散存储和高速缓存,有效提升网站访问速度和服务可用性,拥有CDN许可证的企业可以合法地运营CDN服务,为客户提供高速、稳定的内容传输服务,避免法律风险,并在市场上更具竞争力。

二、申请条件

申请CDN许可证需要满足以下条件:

经营者资质:依法设立的独立法人公司。

注册资本:跨地区经营的企业注册资本最低认缴限额为1000万元人民币,省内经营的企业注册资本最低认缴限额为100万元人民币。

专业人员:拥有与开展经营活动相适应的专业人员。

无违法记录:公司及其主要出资者和主要经营管理人员三年内无违反电信监督管理制度的违法记录。

三、申请流程

申请CDN许可证的流程通常包括以下几个步骤:

1、了解法律法规:熟悉并遵守《中华人民共和国电信条例》、《互联网信息服务管理办法》等相关法律法规。

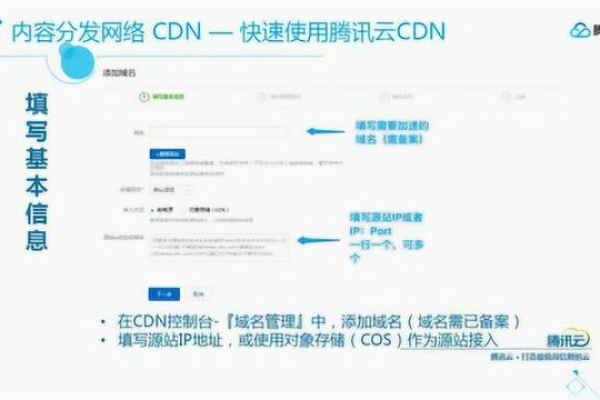

2、准备申请材料:包括但不限于企业营业执照副本、公司章程、法定代表人身份证明、技术方案和安全保障措施、业务发展计划等。

3、提交申请:将准备好的申请材料提交至省通信管理局或工信部等相关审批部门,提交方式可以是线上提交或线下提交。

4、等待审批:审批部门将对申请材料进行审核,包括材料审核、技术评估、现场检查等环节,审批时间一般为40-60个工作日左右。

5、获得批准:若审批通过,企业将获得CDN许可证,可以合法地提供CDN服务。

四、注意事项

材料准备要充分:确保材料的完整性和准确性,任何缺失或错误的材料都可能导致审核不通过。

技术方案要详细:技术方案是资质审核和技术测试的核心内容,需要详细描述CDN技术架构、内容传输策略和安全防护措施。

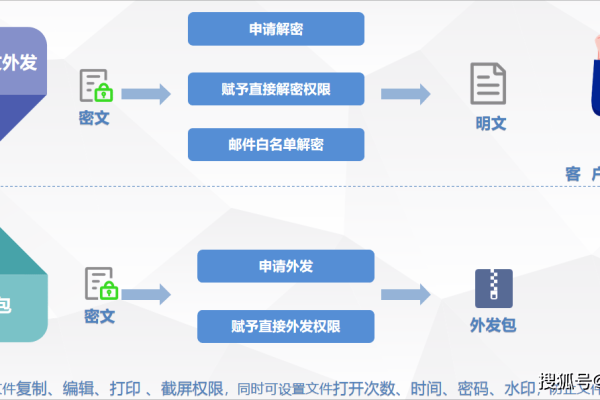

安全保障措施要到位:在资质审核和技术测试中,安全保障措施是一个重要的审核内容,需要确保能够有效防范网络攻击和数据泄露。

定期进行安全检查和技术升级:获得CDN许可证后,企业需要定期进行安全检查和技术升级,确保服务质量和安全性。

五、FAQs

Q1: CDN许可证的有效期是多久?

A1: CDN许可证的有效期根据不同地区和法规的要求而有所不同,许可证的有效期为一年,但也有可能是三年或更长时间,在许可证到期前,运营商需要办理续签手续,以确保继续提供CDN服务的合法性。

Q2: 未办理CDN许可证会面临哪些处罚?

A2: 根据《中华人民共和国电信条例》规定,擅自经营或超范围经营电信业务的企业,将面临责令改正、没收违法所得、罚款等处罚,具体罚款金额根据违法所得情况而定,最高可达100万元;情节严重的,还可能被责令停业整顿。

六、小编有话说

CDN审批制度对于保障互联网行业健康发展具有重要意义,作为CDN服务提供商,应严格遵守相关法律法规,认真准备申请材料,积极配合审批部门的审核工作,在获得CDN许可证后,还应持续关注行业动态和技术发展,不断提升服务质量和安全性,为用户提供更加高效、稳定的CDN服务,希望本文能为您了解CDN审批制度提供有益的参考。