负载均衡的原理及使用方法是什么

- 行业动态

- 2024-05-30

- 3297

负载均衡的原理

1. 定义

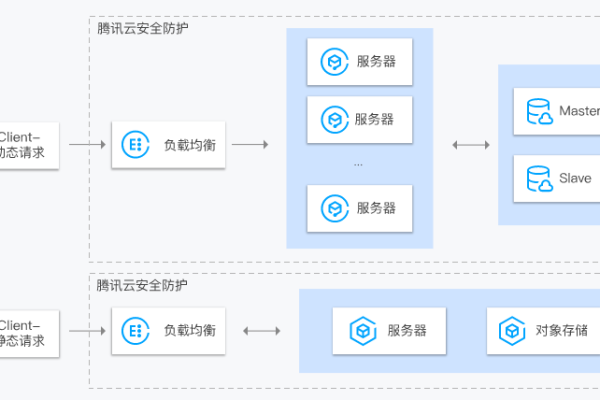

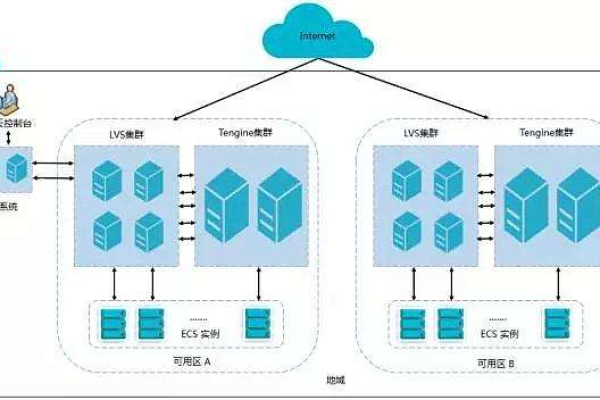

负载均衡(Load Balancing)是一种网络技术,它通过将网络流量分配到多个服务器或资源上,以提高系统的整体性能和可靠性。

2. 目的

提高性能:通过分散请求,避免单个服务器过载。

增加可靠性:如果一个服务器失败,其他服务器可以接管其工作。

扩展性:随着需求的增长,可以轻松添加更多服务器。

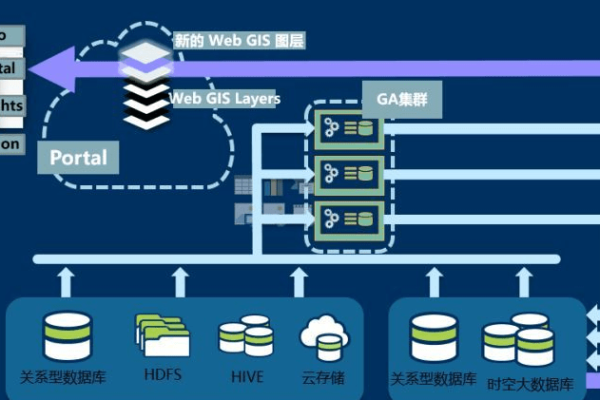

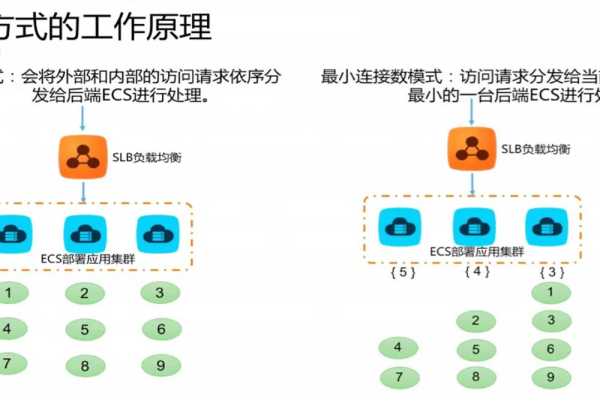

3. 工作原理

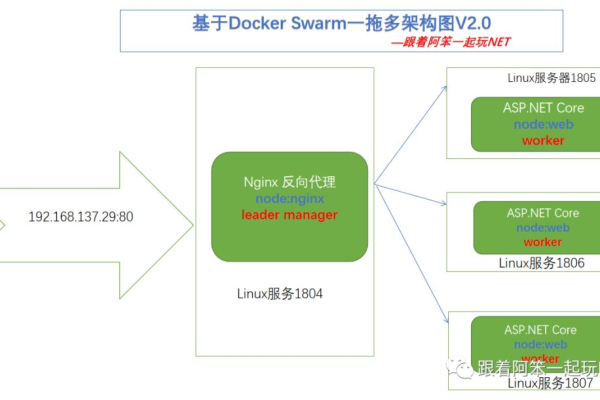

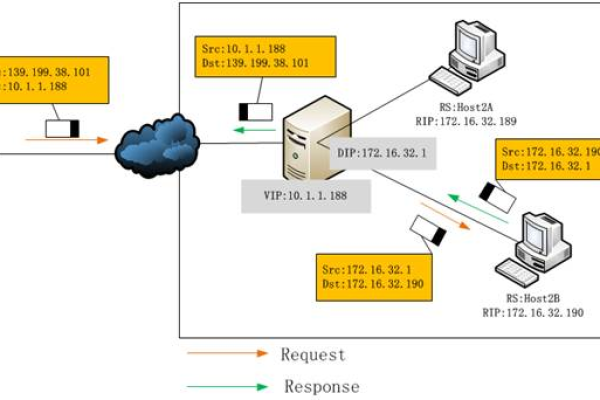

负载均衡器通常位于客户端和服务器群之间,它根据一定的算法(如轮询、最少连接数等)来决定哪个服务器应该处理到来的请求。

负载均衡的使用方法

1. 硬件负载均衡器

设备:如F5、Citrix NetScaler等。

优点:高性能,适合大型企业。

缺点:成本高。

2. 软件负载均衡器

软件:如Nginx、HAProxy、LVS等。

优点:成本低,灵活性高。

缺点:可能需要更多的配置和维护。

3. 云服务负载均衡器

服务:AWS ELB、Google Cloud Load Balancing、Azure Load Balancer等。

优点:易于使用,自动扩展。

缺点:依赖于特定的云服务提供商。

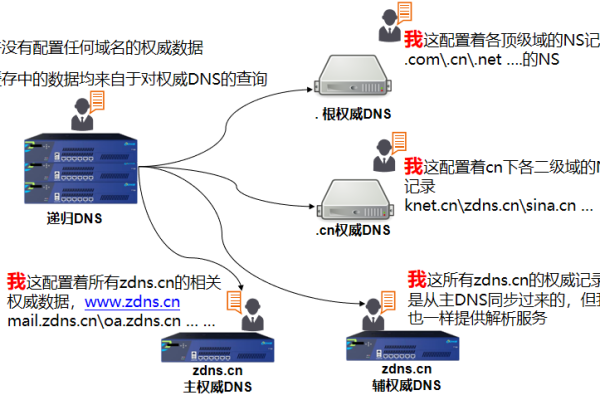

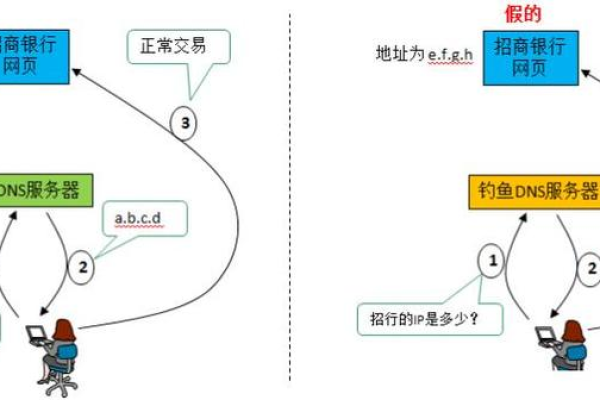

4. DNS负载均衡

原理:通过DNS解析将请求分发到不同的服务器。

优点:简单易用。

缺点:不能保证请求均匀分布。

表格归纳

| 类型 | 优点 | 缺点 | 适用场景 |

| 硬件 | 高性能 | 成本高 | 大型企业 |

| 软件 | 成本低 | 需要配置 | 中小型企业 |

| 云服务 | 易于使用 | 依赖云服务 | 云基础设施用户 |

| DNS | 简单易用 | 不均匀 | 轻量级应用 |

上文归纳

选择合适的负载均衡解决方案需要考虑性能需求、成本预算、维护能力以及系统的可扩展性等因素。

本站发布或转载的文章及图片均来自网络,其原创性以及文中表达的观点和判断不代表本站,有问题联系侵删!

本文链接:http://www.xixizhuji.com/fuzhu/64385.html