openwrt 赚钱 cdn

- 行业动态

- 2025-03-12

- 20

OpenWrt 赚钱与 CDN 应用全解析

一、OpenWrt 系统

| 特点 | 详情 |

| 性能与稳定性 | OpenWrt 是一个灵活且可定制的路由器操作系统,适合高性能需求,它支持多种硬件平台,并且有丰富的插件和扩展功能,能保障系统稳定运行,为后续的 CDN 应用等提供坚实基础 |

| 易用性 | 对于有一定技术背景的用户来说,OpenWrt 的配置和管理相对简单,通过 SSH 或 Web 界面可以进行系统配置,方便用户对路由器进行个性化设置与管理 |

| 应用场景广泛性 | 可用于家庭网络、小型办公室网络等多种场景,满足不同用户对于网络功能与性能的需求,在搭建个人 CDN 节点等方面也有出色表现 |

二、利用 OpenWrt 赚钱的方式

1、CDN(内容分发网络)服务

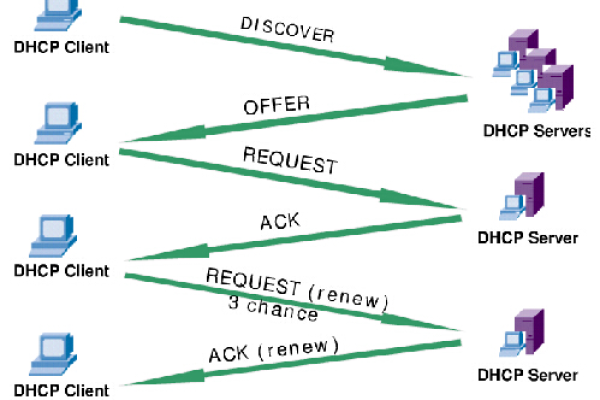

原理:通过在自己的网络设备(如使用 OpenWrt 系统的路由器)上安装特定的 CDN 软件(如 Squid 或 Nginx 等),将一些热门的网络内容缓存到本地设备中,当周边用户的设备访问这些相同的内容时,可以直接从本地设备获取,从而减少数据传输量,提高内容访问速度,而用户可以从相关的 CDN 服务提供商那里获得一定的收益,一些视频网站、文件下载站点等内容提供商会租用用户的 CDN 带宽来加速内容的分发。

收益情况:收益的多少取决于多个因素,如设备所连接网络的上行带宽大小、所在地区的网络流量需求以及所选择的 CDN 业务类型等,网络带宽越高、所在地区网络活跃度越高,潜在的收益可能越大,但实际收益并不稳定,可能会受到市场竞争、服务提供商政策调整等因素的影响。

2、Pcdn(边缘计算内容分发网络)服务

原理:Pcdn 是利用边缘设备(如家庭中的路由器、电脑等)的存储和带宽资源来参与内容分发,以网心云为例,用户在设备上部署网心云客户端软件后,该软件会根据设备的闲置资源情况,自动从内容提供商处获取相关内容并进行缓存和分发,当其他用户请求这些内容时,如果附近的边缘设备中有缓存,就可以直接从这些设备获取数据,提高内容传输效率。

收益情况:对于普通家庭用户利用闲置带宽和设备参与 Pcdn 的情况,收益相对较低,一般一台设备每天的收益可能在几毛钱到几块钱不等,而且收益会受到设备性能、网络质量、Pcdn 服务提供商的政策等多种因素影响,不过,如果有多台设备同时参与,收益可能会有所增加。

三、OpenWrt 在 CDN 中的应用优势

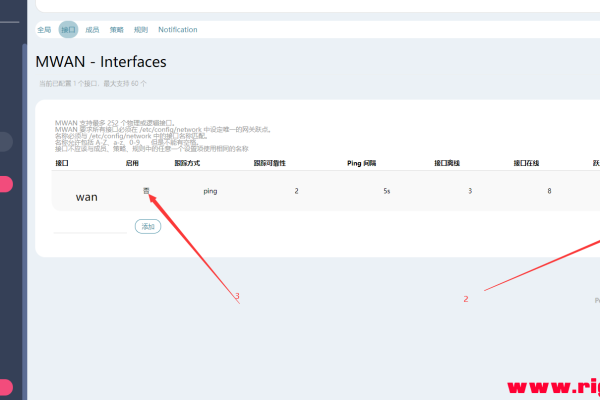

1、高度可定制性:OpenWrt 拥有众多的插件和扩展功能,用户可以根据自己的需求选择合适的 CDN 软件(如 Squid、Nginx 等)并进行详细的配置优化,以满足不同的 CDN 应用场景和性能要求,用户可以根据网络带宽、存储容量等因素调整缓存策略和分发规则。

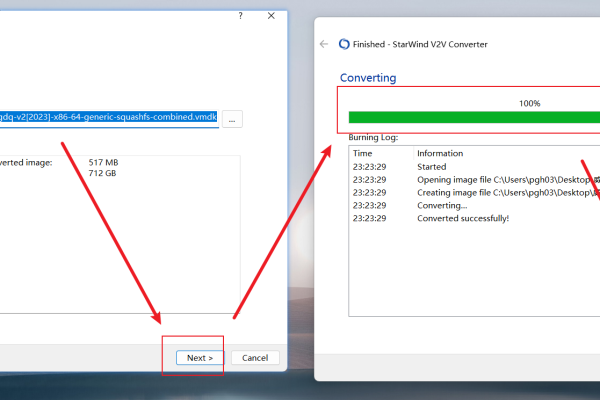

2、支持多种硬件平台:这使得用户可以在不同的设备上部署 OpenWrt 系统来实现 CDN 功能,无论是低功耗的嵌入式设备还是性能较强的路由器、小型服务器等都可以成为 CDN 节点,增加了应用的灵活性和可扩展性。

3、成本低廉:相比专业的 CDN 服务器设备,使用 OpenWrt 系统可以利用现有的网络设备(如家中的旧路由器等),只需进行简单的软件配置和可能的硬件升级(如添加硬盘用于缓存),即可搭建起一个基本的 CDN 节点,大大降低了入门门槛和成本。

四、相关问题与解答

1、问题:OpenWrt 搭建 CDN 节点是否需要公网 IP?

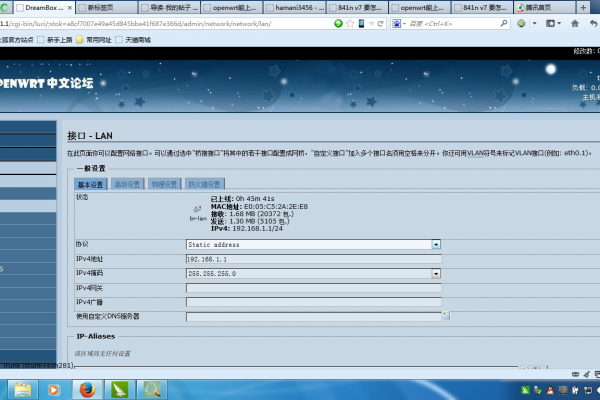

解答:一般情况下是需要公网 IP 的,因为 CDN 的目的是为互联网上的其他用户提供内容缓存和加速服务,如果没有公网 IP,其他用户无法访问到你的 CDN 节点,不过,在一些特殊的网络环境(如内网环境中的部分应用)下,可能可以通过一些网络地址转换(NAT)技术或特定的组网方式在一定程度上实现类似 CDN 的功能,但这并非传统意义上的面向互联网的 CDN 服务。

2、问题:在 OpenWrt 上安装 CDN 软件是否会影响路由器的其他功能?

解答:这取决于具体的配置和使用情况,如果合理分配设备资源(如 CPU、内存、带宽等),安装 CDN 软件一般不会对路由器的其他基本功能(如路由功能、Wi-Fi 发射等)产生明显影响,但如果设备资源有限或者 CDN 软件配置不当(如缓存设置过大占用过多磁盘空间或内存),可能会导致路由器性能下降,出现卡顿、网络延迟增加等问题,在安装和使用 CDN 软件时,需要根据设备的实际性能进行适当的优化和调整。