服务器上部署深度学习 并一直运行

- 行业动态

- 2025-02-27

- 11

在服务器上部署深度学习模型并确保其持续运行,涉及到一系列的步骤和考虑因素,以下是详细指南:

准备工作

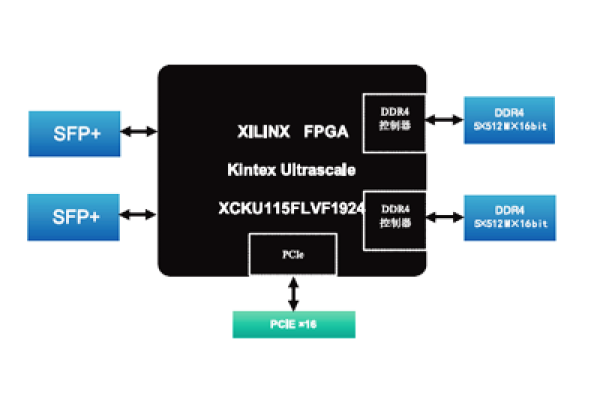

硬件选择:确保服务器具备足够的计算能力(如GPU),内存和存储空间来支持深度学习模型的训练或推理需求。

操作系统:选择一个稳定且兼容的操作系统,如Linux发行版(Ubuntu, CentOS等)。

软件依赖:安装必要的软件,包括Python、深度学习框架(如TensorFlow, PyTorch)、CUDA(如果使用GPU)等。

环境配置

虚拟环境:使用venv或conda创建隔离的Python环境,以管理项目依赖。

版本控制:使用Git进行代码版本管理,便于追踪更改和回滚。

配置文件:使用配置文件(如YAML, JSON)管理模型参数、服务器设置等。

模型部署

容器化:考虑使用Docker将模型及其依赖打包,实现环境一致性和易于部署。

Web框架:选择合适的Web框架(如Flask, Django, FastAPI)搭建API服务,使模型可以通过HTTP请求访问。

负载均衡:对于高并发场景,使用Nginx或其他负载均衡工具分发请求。

持续运行与监控

进程管理:使用systemd或supervisord管理后台进程,确保服务稳定运行。

日志记录:集中管理日志,使用ELK Stack(Elasticsearch, Logstash, Kibana)或Graylog等工具分析日志。

性能监控:利用Prometheus, Grafana等工具监控系统性能,及时发现并解决问题。

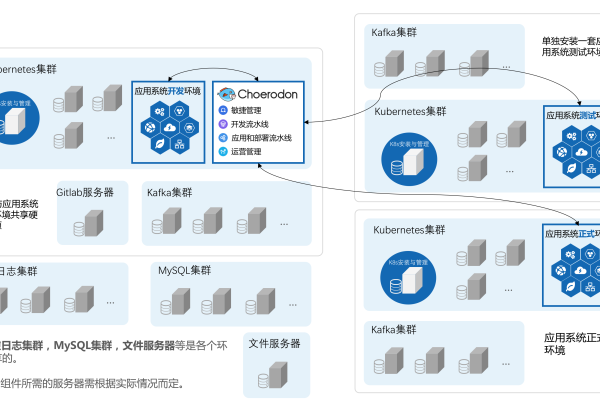

自动扩展:根据负载自动调整资源,可以使用Kubernetes进行容器编排和管理。

安全性考虑

访问控制:限制对API的访问,使用API密钥或OAuth认证。

数据加密:传输层使用HTTPS加密,保护数据安全。

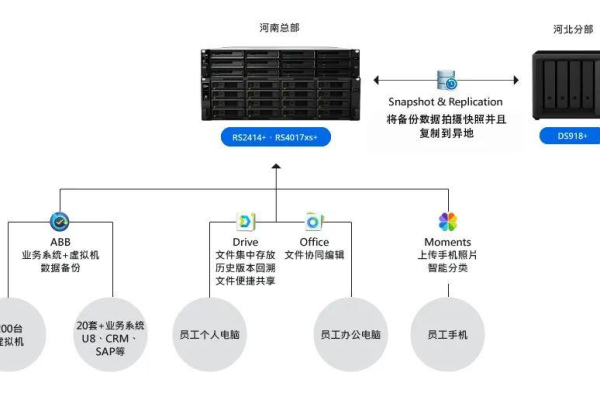

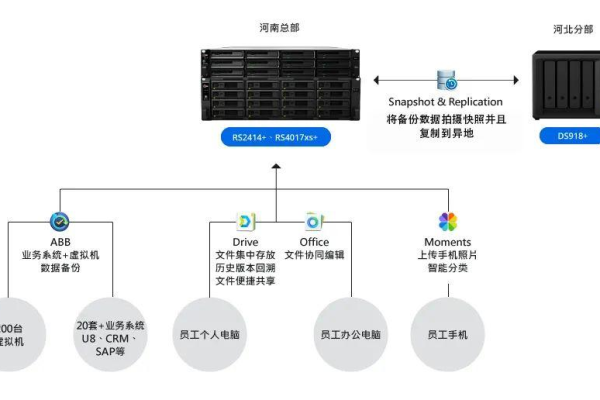

定期备份:定期备份模型和重要数据,防止数据丢失。

更新与维护

持续集成/持续部署(CI/CD):设置CI/CD流水线,自动化测试和部署流程。

模型更新:定期评估模型性能,必要时重新训练并部署新版本。

FAQs

Q1: 如何选择合适的服务器配置?

A1: 根据模型复杂度、预期用户量和预算综合考虑,对于大规模模型或高并发应用,推荐使用带有高性能GPU的服务器,并确保有足够的内存和存储空间。

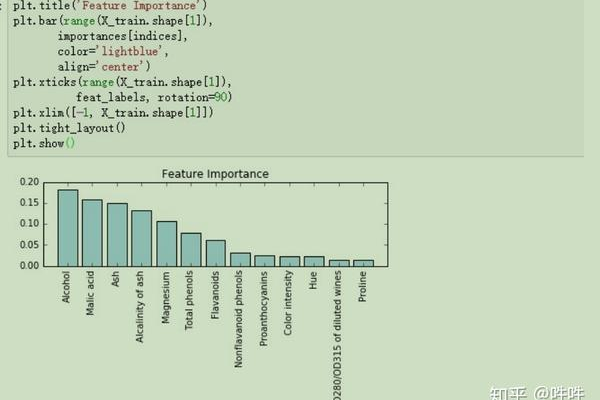

Q2: 如何处理模型过拟合问题?

A2: 可以采用正则化技术(如L1/L2正则化)、增加数据增强、早停法(Early Stopping)或使用更简单的模型架构等方法来缓解过拟合,通过交叉验证评估模型泛化能力也很重要。

小编有话说

部署深度学习模型到服务器并保持其长期稳定运行是一个复杂但至关重要的过程,它不仅需要技术知识,还需要良好的运维实践,通过上述步骤和建议,可以帮助您更有效地管理和优化您的深度学习服务,确保为用户提供高效、可靠的体验,记得持续关注最新技术和最佳实践,不断迭代改进您的系统。