如何在Linux系统中高效调试程序?

- 行业动态

- 2024-11-16

- 14

在软件开发的广阔天地里,Linux调试程序是开发者不可或缺的技能之一,它不仅能够帮助开发者定位代码中的错误,还能优化程序性能,提高软件质量,本文将深入探讨Linux环境下的调试工具和技术,帮助读者掌握这一关键技能。

Linux调试工具概览

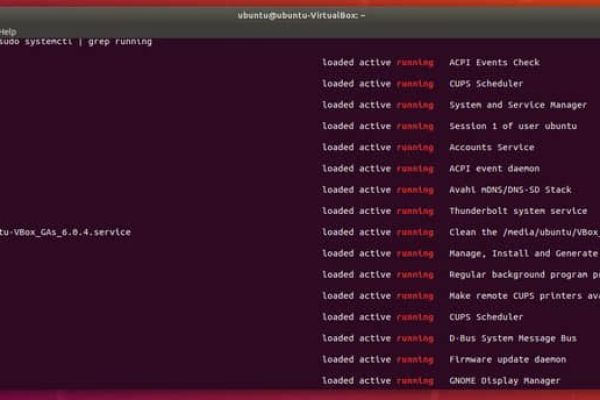

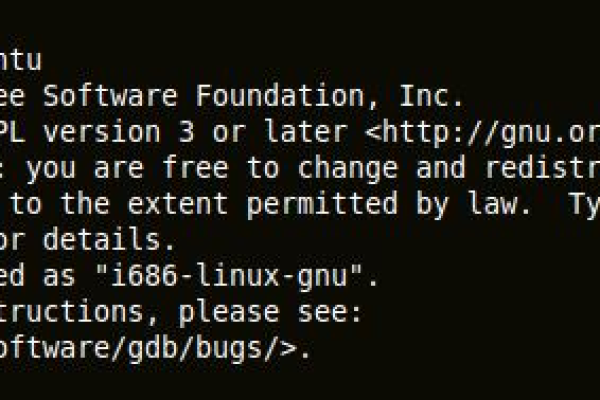

Linux提供了多种强大的调试工具,其中最常用的包括GDB(GNU Debugger)、Valgrind、Strace等,这些工具各有特色,适用于不同的调试场景。

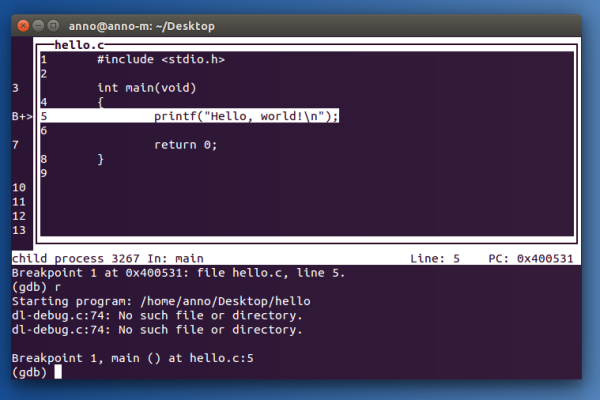

GDB:作为Linux下最流行的调试器,GDB支持多种编程语言,能够进行源码级调试,包括设置断点、单步执行、查看变量值等。

Valgrind:主要用于内存调试和分析,能够检测内存泄漏、非规内存访问等问题。

Strace:用于跟踪系统调用和信号,帮助开发者了解程序与操作系统之间的交互。

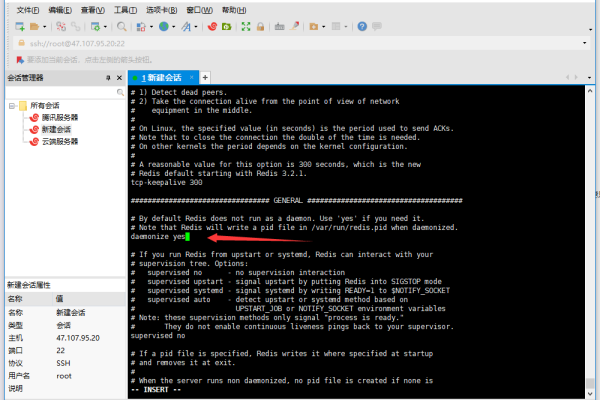

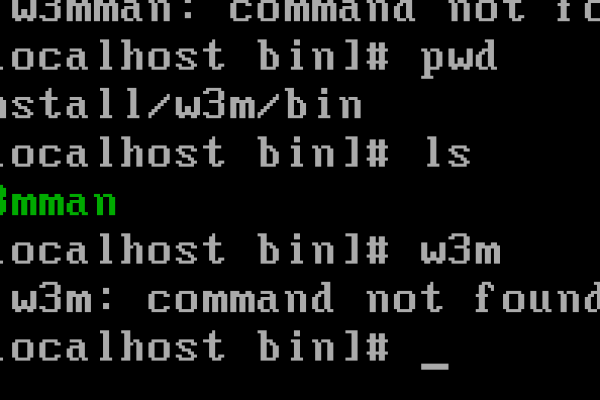

使用GDB进行程序调试

基本命令

1、启动GDB:gdb <program>

2、设置断点:break <function> 或b <line number>

3、运行程序:run

4、单步执行:step 或next

5、查看变量值:print <variable>

6、继续执行:continue

7、退出GDB:quit

高级功能

条件断点:可以设置条件,只有满足条件时才触发断点。

观察点:监控特定内存区域的变化。

回溯:当程序崩溃时,使用bt命令查看调用栈信息。

Valgrind的使用

Valgrind是一个动态分析工具,主要用于检测内存错误,常用的命令包括:

Memcheck:检查内存泄漏和非规内存访问。

Callgrind:分析程序的性能瓶颈。

Massif:分析堆内存使用情况。

Strace的应用

Strace可以跟踪程序的系统调用和信号,对于理解程序行为非常有帮助,常用命令有:

跟踪系统调用:strace ./<program>

跟踪特定系统调用:strace -e trace=<syscall>

跟踪子进程:strace -f ./<program>

调试技巧与最佳实践

合理使用断点:不要过度依赖断点,过多的断点会干扰程序的正常流程。

利用日志:在关键位置添加日志输出,有助于快速定位问题。

保持代码整洁:良好的代码风格和结构可以提高调试效率。

版本控制:使用Git等版本控制系统,便于回溯和比较代码变化。

FAQs

Q1: GDB中如何设置条件断点?

A1: 在GDB中设置条件断点可以使用以下命令:break <function> | b <line number> if <condition>,要在main函数的第10行设置一个条件断点,条件是变量x等于5,可以使用命令:break main if x == 5。

Q2: Valgrind报告了大量的内存错误,如何解读这些报告?

A2: Valgrind的报告可能会很长,但通常会包含错误类型、发生错误的地址和相关的源代码行,首先关注“Definitely lost”和“Indirectly lost”部分,这些通常表示内存泄漏,对于每个错误,Valgrind会提供一个详细的堆栈跟踪,帮助你定位问题源头,如果报告过于复杂,可以尝试简化代码或使用更具体的分析工具来缩小问题范围。

通过上述介绍,我们可以看到Linux下的调试工具和技术是非常丰富和强大的,掌握这些工具,将极大地提升开发者的调试效率和程序质量,希望本文能为你的Linux调试之旅提供有价值的参考。

以上就是关于“linux调试程序”的问题,朋友们可以点击主页了解更多内容,希望可以够帮助大家!