如何成功申请一年免费的外国虚拟主机服务?

- 行业动态

- 2024-08-26

- 10

申请外国免费虚拟主机试用一年的流程和注意事项

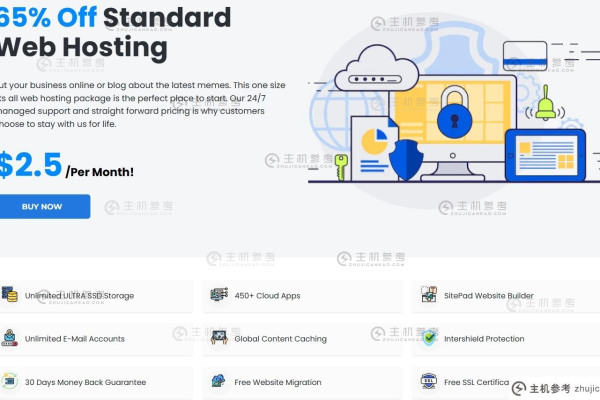

申请外国免费虚拟主机试用一年对于许多希望建立网站或进行网络测试的开发者而言,是一个吸引人的选择,通过免费试用,用户可以在不支付费用的情况下,体验虚拟主机服务的质量与性能,下面将详细介绍如何申请外国免费虚拟主机试用一年的具体步骤和需要注意的事项。

1、选择目标国家和虚拟主机提供商

确定目标国家:根据网站主要访问者的地理位置,选择目标国家可以提高网站的访问速度和响应时间,如果主要访问者位于美国,则应选择美国的虚拟主机提供商。

选择合适的提供商:可以通过搜索引擎或参考用户评价和推荐来选择信誉良好和服务可靠的虚拟主机提供商,比较不同提供商的优势和服务是关键步骤之一。

2、访问官方网站并选择试用计划

**进入官网*:访问所选虚拟主机提供商的官方网站,通常在主页就可以找到关于免费试用的相关信息和链接。

选择试用计划:在官网找到试用计划选项,如“免费试用一年”等,点击进入详细页面获取计划的具体内容和条件。

3、填写试用申请表格

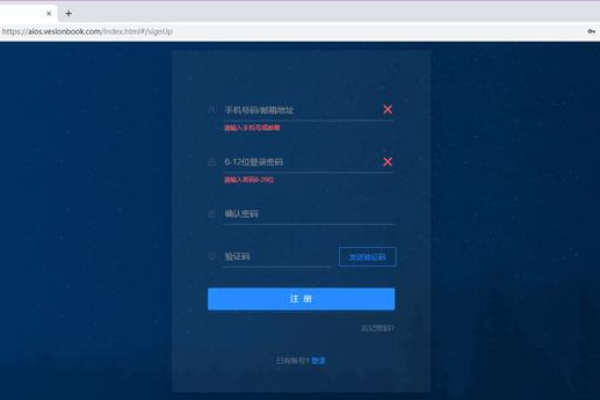

提供个人信息:根据提供商的要求填写试用申请表,通常需要提供的信息包括姓名、电子邮件地址、联系方式等。

阅读并同意条款:在填写信息前,务必详细阅读提供商的服务条款,确保理解并接受所有条件,特别是那些涉及试用期限制和服务功能的条款。

4、提交申请并等待审核

提交申请:确认所有信息无误后,提交申请,有些提供商可能会要求创建账户,以便在试用期间管理服务。

等待审核:提交申请后,需要耐心等待提供商的审核,审核时间可以从几小时到几天不等,这取决于提供商的审核流程和工作负载。

5、获取并使用试用账户

查收账户信息:一旦审核通过,你将收到包含试用账户信息的电子邮件,如登录网址、用户名及密码等。

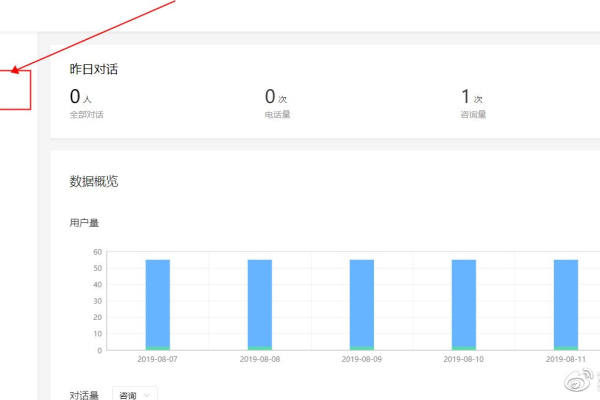

**开始使用*:使用收到的账户信息登录虚拟主机的控制面板,开始根据需要配置和使用虚拟主机,这一阶段可以测试主机的性能和功能是否符合需求。

表格:关键步骤摘要

| 步骤号 | 步骤内容 | 关键点 |

| 1 | 选择目标国家和虚拟主机提供商 | 根据目标用户位置选择国家;比较不同提供商 |

| 2 | 访问官方网站并选择试用计划 | 详细了解并选择适合的试用计划 |

| 3 | 填写试用申请表格 | 提供准确的个人信息;仔细阅读并同意服务条款 |

| 4 | 提交申请并等待审核 | 提交申请后耐心等待审核结果 |

| 5 | 获取并使用试用账户 | 利用提供的登录信息开始使用和测试虚拟主机性能 |

相关问答FAQs:

Q1: 试用期结束后我应该怎么办?

A1: 试用期结束后,您需要决定是否继续使用该虚拟主机服务,如果您选择继续,可以根据服务提供商的价格和付费计划选择合适的服务套餐进行订阅。

Q2: 免费虚拟主机有哪些限制?

A2: 免费虚拟主机通常会有存储空间、带宽、功能等方面的限制,具体限制依据服务提供商的不同而异,因此建议用户在使用前仔细阅读服务条款,以了解可能的限制。

归纳而言,申请外国免费虚拟主机试用一年是一个相对简单但需要细致考虑的过程,通过正确选择服务提供商并严格按照他们的申请程序操作,您可以充分利用这一机会来测试和评估潜在的虚拟主机服务,注意试用期的限制和服务条款,确保试用结束后能够做出合适的决定。