如何高效统计MySQL中多张表的数据条数?

- 行业动态

- 2024-09-29

- 9

UNION ALL将多个

COUNT(*)查询结果合并起来。以下是一个示例:,,“

sql,SELECT 'table1' AS table_name, COUNT(*) AS count FROM table1,UNION ALL,SELECT 'table2' AS table_name, COUNT(*) AS count FROM table2,UNION ALL,SELECT 'table3' AS table_name, COUNT(*) AS count FROM table3;,`

,,这个查询将分别计算table1

、table2

和table3`的

数据条数,并将结果合并成一个新的结果集。

MySQL数据库多张表数据条数统计

在MySQL中,统计多张表的数据条数是一个常见的需求,无论是为了优化查询性能、进行数据分析,还是生成报表,了解如何快速获取各表中的记录数量都是非常有用的技能,本文将详细介绍几种实现这一目标的方法,包括使用UNION操作符、JOIN操作符和子查询,并结合实际示例进行说明。

使用UNION操作符

1. UNION操作符简介

UNION操作符用于合并多个SELECT语句的结果集,它会删除重复的行,如果希望保留所有重复的行,可以使用UNION ALL。

2. 示例代码

假设我们有三张表table1、table2和table3,我们希望分别统计它们各自的数据条数:

SELECT '表1' AS table_name, COUNT(*) AS row_count FROM table1 UNION SELECT '表2' AS table_name, COUNT(*) AS row_count FROM table2 UNION SELECT '表3' AS table_name, COUNT(*) AS row_count FROM table3 ORDER BY table_name;

这个查询会返回三张表的数据条数,并按表名排序,输出结果如下:

| table_name | row_count |

| 表1 | 100 |

| 表2 | 200 |

| 表3 | 150 |

3. 优点与局限性

优点:简单明了,适用于没有关联关系的独立表。

局限性:无法处理有复杂关联关系的表。

使用JOIN操作符

1. JOIN操作符简介

JOIN操作符用于根据某些条件将两个或多个表连接在一起,常用的JOIN类型包括INNER JOIN、LEFT JOIN、RIGHT JOIN等。

2. 示例代码

假设有两个表table1和table2,它们之间存在一个共同的列column1:

SELECT table1.column1, COUNT(table2.column2) AS row_count FROM table1 JOIN table2 ON table1.column1 = table2.column1 GROUP BY table1.column1;

这个查询会返回每个unique column1值对应的table2中的数据条数。

3. 优点与局限性

优点:能够处理有复杂关联关系的表。

局限性:需要表之间有明确的关联关系,否则无法使用。

使用子查询

1. 子查询简介

子查询是指在另一个查询中嵌套的SELECT语句,它可以用于各种复杂的查询需求。

2. 示例代码

假设我们有三张表table1、table2和table3,我们希望找到数据条数最多的表:

SELECT '表1' AS table_name, COUNT(*) AS row_count FROM table1 UNION ALL SELECT '表2' AS table_name, COUNT(*) AS row_count FROM table2 UNION ALL SELECT '表3' AS table_name, COUNT(*) AS row_count FROM table3 AS subquery ORDER BY row_count DESC LIMIT 1;

这个查询会返回数据条数最多的表及其条数。

3. 优点与局限性

优点:灵活性高,可以处理各种复杂的查询需求。

局限性:编写复杂,执行效率可能较低。

常见问题解答

问题1:如何在特定条件下统计每张表的数据条数?

答:可以在每个表的COUNT(*)查询中添加WHERE子句来指定条件。

SELECT '表1' AS table_name, COUNT(*) AS row_count FROM table1 WHERE condition1 UNION SELECT '表2' AS table_name, COUNT(*) AS row_count FROM table2 WHERE condition2 UNION SELECT '表3' AS table_name, COUNT(*) AS row_count FROM table3 WHERE condition3;

问题2:如何比较不同表之间的数据量差异?

答:可以使用子查询和MAX函数来找出数据量最多的表,然后与其他表进行对比。

SELECT table_name, row_count

FROM (

SELECT '表1' AS table_name, COUNT(*) AS row_count FROM table1

UNION ALL

SELECT '表2' AS table_name, COUNT(*) AS row_count FROM table2

UNION ALL

SELECT '表3' AS table_name, COUNT(*) AS row_count FROM table3

) AS subquery

ORDER BY row_count DESC;

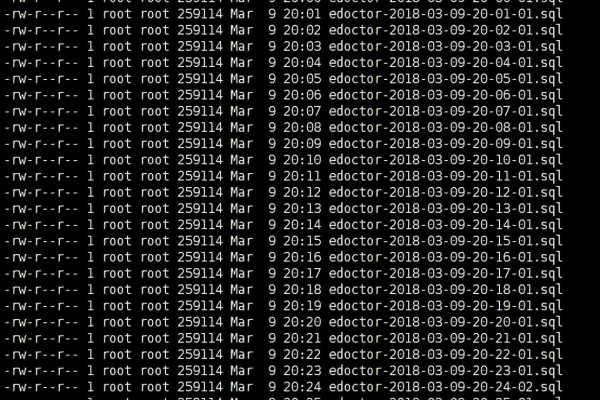

问题3:如何处理包含大量数据的表?

答:对于包含大量数据的表,建议分批次处理,或者使用索引来优化查询性能,可以考虑使用分区表(Partitioned Tables)来提高查询效率。