如何为GaussDB for MySQL实例启用错误日志记录功能?

- 行业动态

- 2024-09-29

- 8

log_error参数。

GaussDB for MySQL实例开启错误日志

GaussDB for MySQL是一种高性能、高可靠性的数据库管理系统,广泛应用于各类企业级应用中,为了确保数据库的稳定性和安全性,记录错误日志是必不可少的,本文将详细介绍如何在GaussDB for MySQL实例中开启错误日志,并提供相关的操作步骤和注意事项。

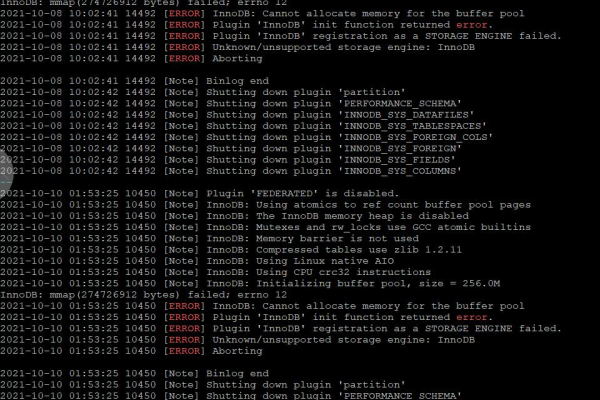

错误日志的重要性

在数据库管理中,错误日志是记录系统运行过程中发生的错误和异常情况的重要工具,通过分析错误日志,可以快速定位和解决系统中的问题,提高系统的可靠性和稳定性,开启错误日志对于维护和管理GaussDB for MySQL实例至关重要。

开启错误日志的步骤

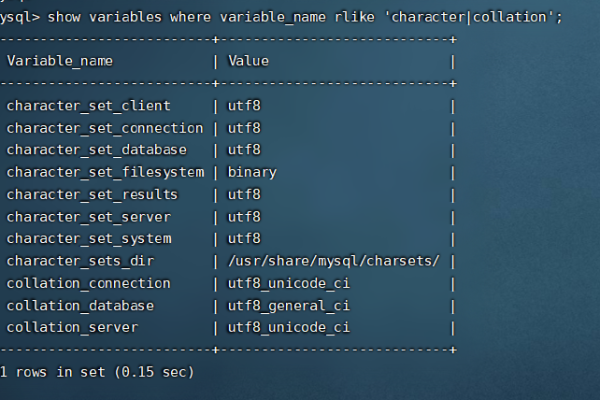

1、检查当前日志设置:

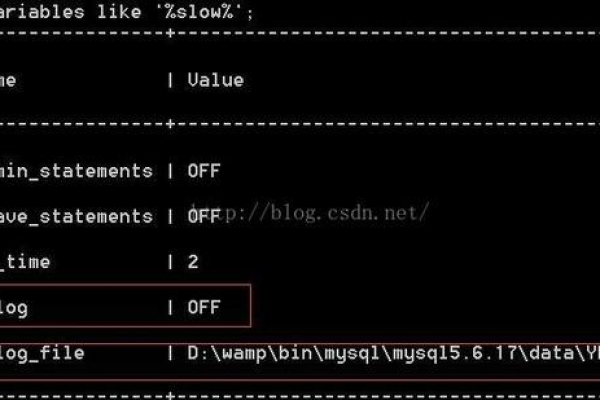

需要查看当前的日志设置,以确定是否已经开启了错误日志,可以通过以下命令查看:

“`sql

SHOW VARIABLES LIKE ‘log_error’;

“`

该命令会返回错误日志文件的路径,如果未设置则返回空值。

2、修改配置文件:

如果错误日志未开启,可以通过修改GaussDB for MySQL的配置文件来启用错误日志,配置文件通常位于/etc/my.cnf或/etc/mysql/my.cnf。

使用文本编辑器打开配置文件,并在[mysqld]部分添加或修改以下行:

“`ini

log_error = /path/to/your/error.log

“`

请将/path/to/your/error.log替换为实际的错误日志文件路径。

3、重启数据库服务:

修改配置文件后,需要重启GaussDB for MySQL服务以使更改生效,可以使用以下命令重启服务:

“`bash

sudo systemctl restart mysql

“`

或者根据系统的不同,使用适当的命令重启服务。

4、验证错误日志:

重启服务后,可以通过执行以下命令验证错误日志是否已成功开启:

“`sql

SHOW VARIABLES LIKE ‘log_error’;

“`

确保返回的路径与配置文件中设置的路径一致。

5、查看错误日志:

错误日志文件可以使用文本编辑器或命令行工具(如less或grep)查看,使用less命令查看错误日志:

“`bash

less /path/to/your/error.log

“`

通过查看错误日志,可以及时发现和处理系统中的错误和异常情况。

注意事项

1、日志文件大小:

错误日志文件可能会随着时间的推移变得很大,建议定期进行日志轮转或清理,以防止占用过多磁盘空间。

2、日志级别:

GaussDB for MySQL支持不同级别的日志记录,可以根据实际需求调整日志级别,错误日志记录的是比较严重的错误信息。

3、权限控制:

确保只有授权的用户能够访问和修改错误日志文件,以防止敏感信息的泄露。

4、备份和恢复:

定期备份错误日志文件,以便在需要时进行恢复和分析,确保在系统崩溃或故障时能够快速恢复错误日志。

FAQs

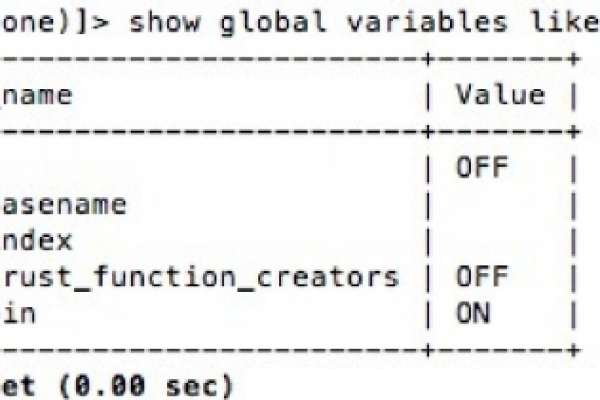

1、如何临时开启错误日志?

可以通过在MySQL命令行中执行以下命令临时开启错误日志:

“`sql

SET GLOBAL log_error = ‘/path/to/your/temporary_error.log’;

“`

这种方法在MySQL服务重启后会失效,因此只适用于临时调试和排查问题。

2、如何限制错误日志的文件大小?

可以通过配置文件中的max_allowed_packet参数来限制错误日志的文件大小,将最大文件大小设置为100M:

“`ini

max_allowed_packet = 100M

“`

这会影响所有类型的日志文件,包括错误日志、查询日志等。

通过以上步骤和注意事项,可以成功开启GaussDB for MySQL实例的错误日志,并有效地管理和监控数据库系统的运行状态,希望本文对您有所帮助!