如何利用MapReduce高效读取和创建大文件?

- 行业动态

- 2024-10-08

- 1

MapReduce 读取大文件_创建大文件

在当今的大数据时代,处理大规模数据已成为许多企业和组织的重要需求,MapReduce作为一种高效的分布式计算框架,广泛应用于处理和分析大规模数据集,本文将详细介绍如何使用MapReduce来读取大文件以及创建大文件,并探讨相关的技术细节和最佳实践。

MapReduce读取大文件

1、基本概念:

MapReduce是一种编程模型,用于处理和生成大规模数据集,它通过将任务分解为多个小任务(即map和reduce阶段),利用分布式系统的优势进行并行处理。

Map阶段负责数据的初步处理,如清洗、过滤等;Reduce阶段则对Map阶段的输出进行汇总和进一步处理。

2、读取大文件的步骤:

配置输入格式:首先需要确定输入文件的格式,如文本、二进制等,并选择合适的输入格式类(如TextInputFormat)。

切片处理:大文件会被自动分成多个逻辑切片,每个切片由一个Map任务处理,切片大小可以通过配置文件调整。

编写Mapper类:实现Mapper接口,重写map方法,定义如何从输入记录中提取键值对。

提交作业:配置Job对象,设置Mapper类、输入输出路径等参数,然后提交作业到集群执行。

3、注意事项:

确保所有节点上的数据块大小一致,以避免数据倾斜问题。

根据数据量和集群规模合理设置切片大小,以优化性能。

创建大文件

1、基本概念:

在MapReduce中,创建大文件通常是Reduce阶段的任务,Reducer会接收来自Mapper的所有输出,并将其合并成最终的结果文件。

结果文件的大小取决于输入数据的规模和Reduce阶段的逻辑。

2、创建大文件的步骤:

编写Reducer类:实现Reducer接口,重写reduce方法,定义如何合并相同键的值。

设置输出格式:选择合适的输出格式类(如TextOutputFormat),并指定输出路径。

提交作业:与读取大文件类似,配置Job对象并提交作业。

3、注意事项:

确保Reducer能够高效地处理大量数据,避免内存溢出等问题。

根据需要调整Reducer的数量,以平衡负载和资源使用。

案例分析

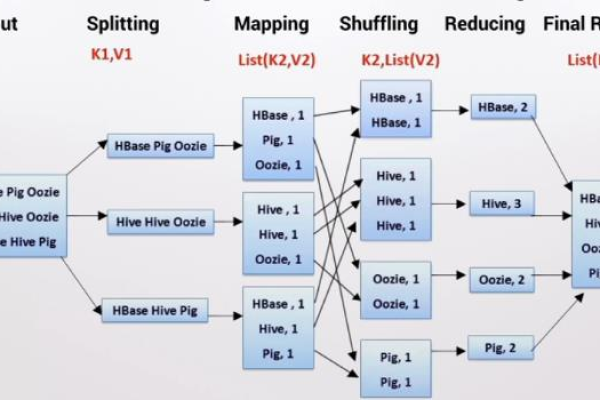

1、单词计数:

这是一个经典的MapReduce示例,用于统计文本文件中每个单词出现的次数。

Mapper负责读取文本行并提取单词;Reducer负责计算每个单词的总次数。

此案例展示了如何从原始数据中提取有用信息,并将结果写入新的大文件中。

2、日志分析:

假设有一个包含数百万条日志记录的大文件,需要分析特定模式的出现频率。

通过配置适当的输入格式和编写自定义的Mapper和Reducer,可以有效地处理这种类型的数据。

结果可能包括各种模式的统计数据,这些数据可以被进一步分析或可视化。

3、机器学习特征提取:

在大数据集上训练机器学习模型时,通常需要先进行特征提取和转换。

MapReduce可以用来并行化这一过程,加速数据处理和模型训练的速度。

可以从社交媒体帖子中提取情感倾向作为特征,用于情感分析模型的训练。

常见问题解答

1、问:如何在MapReduce中处理非结构化数据?

答:对于非结构化数据,如图片或视频,可以使用特定的输入格式(如SequenceFileInputFormat)来读取数据,在Mapper中,可能需要编写更复杂的逻辑来解析数据并提取有用的特征,可以考虑使用第三方库或工具来辅助处理这类数据。

2、问:如何优化MapReduce作业的性能?

答:优化MapReduce作业的性能可以从多个方面入手,确保数据均匀分布以避免数据倾斜;根据数据量和集群规模合理设置切片大小;还可以考虑使用压缩技术来减少数据传输量,以及使用合适的排序策略来加速排序过程,监控作业执行情况并根据反馈进行调整也是提高性能的关键。

通过上述内容的介绍,我们可以看到MapReduce在处理大规模数据时的强大能力,无论是读取还是创建大文件,MapReduce都提供了灵活而有效的解决方案,随着技术的不断发展,我们有理由相信MapReduce将在未来的大数据处理领域发挥更加重要的作用。

| 序号 | 概述 | 操作步骤 |

| 1 | 使用MapReduce读取大文件 | 使用Hadoop的HDFS(Hadoop Distributed File System)存储大文件 |

| 2 | 创建MapReduce作业 | 编写MapReduce作业,包括Map和Reduce函数 |

| 3 | 配置MapReduce作业 | 在Hadoop集群上配置作业,设置输入输出路径等参数 |

| 4 | 编写Map函数 | Map函数读取大文件中的数据,并输出键值对 |

| 5 | 编写Reduce函数 | Reduce函数对Map函数输出的键值对进行聚合处理 |

| 6 | 编译MapReduce作业 | 使用Hadoop的编译工具将作业编译成可执行文件 |

| 7 | 运行MapReduce作业 | 在Hadoop集群上提交作业并运行 |

| 8 | 查看作业输出 | 作业完成后,查看输出结果文件,这些文件通常存储在HDFS或其他文件系统中 |

| 9 | 创建大文件 | 使用Hadoop命令行工具或编程接口创建大文件,例如使用hadoop fs put命令上传文件到HDFS |

| 10 | 优化MapReduce作业 | 根据作业的性能和资源使用情况,调整MapReduce作业的配置参数,如MapReduce框架的内存设置、并行度等 |

以下是一个简单的归纳示例,展示如何使用MapReduce读取大文件并创建大文件:

| 步骤 | 详细说明 |

| 1 | 确保Hadoop集群已经安装并配置好,HDFS服务正在运行。 |

| 2 | 创建一个Java项目,添加MapReduce相关的依赖。 |

| 3 | 在项目中创建Map类和Reduce类,实现Map和Reduce接口。 |

| 4 | 在Map类中,重写map方法,用于读取大文件并生成键值对。 |

| 5 | 在Reduce类中,重写reduce方法,用于聚合Map输出的键值对。 |

| 6 | 在MapReduce作业中,设置输入输出路径,以及配置Map和Reduce任务的数量。 |

| 7 | 编译并打包MapReduce作业。 |

| 8 | 使用Hadoop命令行工具提交作业,如hadoop jar yourjob.jar YourJob。 |

| 9 | 使用hadoop fs put命令将本地文件上传到HDFS,创建大文件。 |

| 10 | 作业完成后,查看HDFS上的输出文件或日志文件,以验证作业的执行结果。 |

本站发布或转载的文章及图片均来自网络,其原创性以及文中表达的观点和判断不代表本站,有问题联系侵删!

本文链接:http://www.xixizhuji.com/fuzhu/5726.html