MySQL是数据库管理系统的一种吗?

- 行业动态

- 2024-09-29

- 13

MySQL数据库是一款开源的关系型数据库管理系统,由瑞典的MySQL AB公司开发,现属于Oracle旗下产品,作为当前最流行的关系型数据库之一,MySQL因其高性能、可靠性和易用性,被广泛应用于各种规模的企业和个人项目中。

特点与优势

1、开源:MySQL是开源软件,用户可以免费使用,这使得它成为中小型企业和个人开发者的首选,开源社区的支持和贡献使得MySQL不断更新和改进,保持了与商业数据库相媲美的性能和功能。

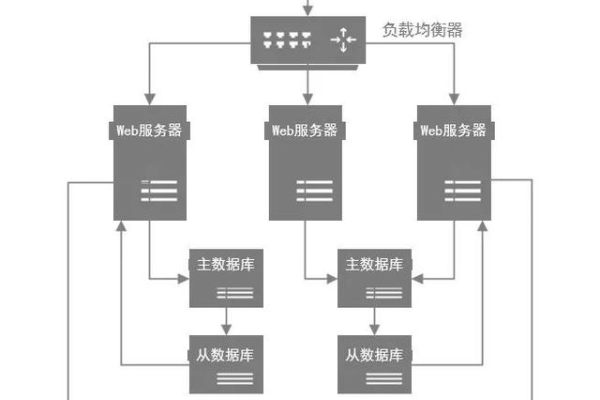

2、高性能:MySQL以其高效的查询处理和优化技术而闻名,它采用了多种查询优化技术,如索引、分区和缓存等,以提高查询速度和响应性能,MySQL还支持并发操作,能够处理大量同时的请求。

3、可靠性与稳定性:MySQL经过多年的实践和验证,具有出色的稳定性和可靠性,它支持事务处理和ACID(原子性、一致性、隔离性和持久性)特性,确保数据的完整性和一致性,MySQL还具备数据备份和恢复功能,可以有效地防止数据丢失。

4、易用性与灵活性:MySQL提供了简单易用的命令行和图形界面工具,使得用户可以轻松地管理和操作数据库,它支持多种编程语言的接口,如Java、Python和PHP等,为开发者提供了灵活的接入方式,MySQL还支持存储过程、触发器和视图等功能,提供了更多的操作和扩展能力。

应用领域

MySQL在各个领域都有广泛的应用,以下是其中几个典型的领域:

1、网站与应用:MySQL是Web开发中最常用的数据库之一,它可以存储和管理网站的用户数据、文章内容、日志信息等,许多著名的网站和应用程序,如Facebook、Twitter和WordPress等,都采用了MySQL数据库来支持其庞大的数据存储和高并发访问。

2、企业级应用:MySQL在企业级应用中也有广泛应用,它可以用于存储和管理企业的客户信息、销售数据、供应链信息等,MySQL的高性能和可靠性使得它成为企业级应用的理想选择。

3、科学计算与数据分析:MySQL在科学计算和数据分析领域也有重要的应用,它可以存储和管理大量的实验数据、统计数据和模型结果等,MySQL的高性能和灵活性使得科研人员可以方便地进行数据查询、分析和挖掘。

MySQL的未来发展

MySQL在过去几年中取得了巨大的成功和发展,但它的发展之路并没有止步于此,作为Oracle旗下的一款产品,MySQL仍然在不断地更新和改进,MySQL将继续致力于提供更高效、更稳定、更易用的数据库解决方案,以满足不断增长的数据管理需求。

FAQs

1、MySQL数据库是什么?

答:MySQL是一款开源的关系型数据库管理系统,由瑞典的MySQL AB公司开发,现属于Oracle旗下产品,它具有高性能、可靠性和易用性等特点,被广泛应用于各种规模的企业和个人项目中。

2、MySQL数据库有哪些应用领域?

答:MySQL在网站与应用、企业级应用以及科学计算与数据分析等领域都有广泛的应用,它可以存储和管理各种类型的数据,并支持高效的查询处理和优化技术。