MySQL数据库中的Float类型数据有哪些特点和用途?

- 行业动态

- 2024-09-29

- 11

FLOAT类型用于存储浮点数,适用于需要表示小数的数据。

在MySQL数据库中,浮点数(float)是一种用于表示实数的数据类型,浮点数的存储和处理方式与定点数(如整数)有所不同,它们能够表示更广泛的数值范围,但同时也存在一些精度问题,以下是关于MySQL数据库中float类型数据的详细解析:

浮点数的概念及误差问题

1、概念:浮点数是一种计算机中表示实数的方式,它使用尾数(M)、基数(B)和指数(E)的组合来表示一个数字,一个浮点数可以表示为 M * B^E。

2、误差问题:由于浮点数在计算机内部是以二进制表示的,而并非所有的十进制小数都能精确地用二进制小数表示,因此在转换过程中会产生误差,这种误差是浮点数固有的,无法完全避免。

MySQL中的浮点数类型

1、FLOAT:FLOAT是单精度浮点数类型,占用4个字节(32位),它适用于表示范围较大但精度要求不高的数值。

2、DOUBLE:DOUBLE是双精度浮点数类型,占用8个字节(64位),与FLOAT相比,DOUBLE提供了更高的精度和更大的范围,适用于对精度要求较高的场合。

3、REAL:REAL类型默认就是DOUBLE,但如果启用了“REAL_AS_FLOAT”模式,则REAL将被视为FLOAT。

浮点数的存储格式

1、单精度浮点数:使用4个字节(32位)表示,包括1位符号位、8位指数位和23位尾数位,其有效数字的二进制位数为24位,相当于十进制的8位。

2、双精度浮点数:使用8个字节(64位)表示,包括1位符号位、11位指数位和52位尾数位,其有效数字的二进制位数为53位,相当于十进制的16位。

浮点数的使用注意事项

1、精度问题:由于浮点数存在精度问题,因此在使用浮点数进行计算时需要注意误差的累积和放大,特别是当涉及到货币等对精度敏感的数据时,应避免使用浮点数。

2、比较操作:由于浮点数存在舍入误差,因此在进行比较操作时应避免直接使用“=”来判断两个浮点数是否相等,可以使用一定的容差范围来进行比较。

3、存储范围:不同的浮点数类型有不同的存储范围和精度,在选择数据类型时应根据实际需求进行权衡。

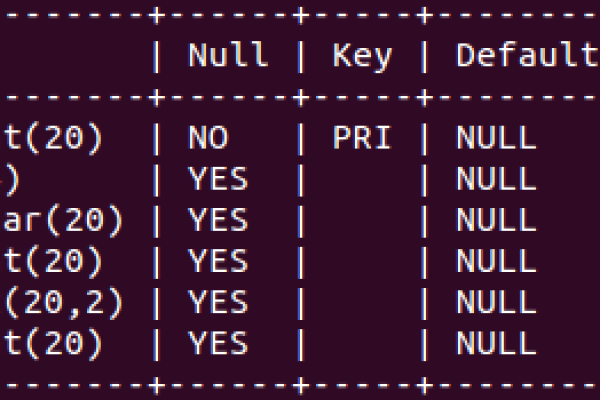

示例代码

CREATE TABLE test_float (

f1 FLOAT,

f2 DOUBLE,

f3 DECIMAL(10, 2)

);

INSERT INTO test_float (f1, f2, f3) VALUES (123.45, 123.45, 123.45);

SELECT * FROM test_float;

在这个例子中,我们创建了一个包含FLOAT、DOUBLE和DECIMAL列的表test_float,并插入了一条记录,由于FLOAT和DOUBLE存在舍入误差,因此在查询结果中可能会看到与插入值略有不同的结果。

FAQs

Q1: 为什么MySQL中的浮点数类型会存在精度问题?

A1: MySQL中的浮点数类型存在精度问题是因为浮点数在计算机内部是以二进制表示的,而并非所有的十进制小数都能精确地用二进制小数表示,在转换过程中会产生舍入误差,导致精度损失。

Q2: 在MySQL中如何选择适合的浮点数类型?

A2: 在选择浮点数类型时,应根据实际需求进行权衡,如果对精度要求不高且需要较大的数值范围,可以选择FLOAT类型;如果对精度要求较高且可以接受较小的数值范围,可以选择DOUBLE类型;对于货币等对精度敏感的数据,建议使用DECIMAL类型以避免精度问题。