MySQL数据库如何实现与SQL模式的兼容?

- 行业动态

- 2024-09-29

- 10

MySQL数据库与SQL_MySQL数据库兼容MySQL模式

MySQL数据库

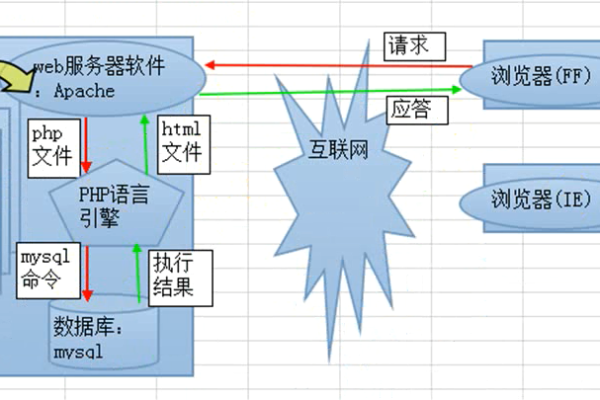

MySQL是一种广泛使用的开源关系型数据库管理系统(RDBMS),由瑞典的MySQL AB公司开发,它以高性能、高可靠性和易用性著称,广泛应用于各种Web应用和企业系统中。

SQL_MySQL数据库

SQL_MySQL是一种基于MySQL协议的关系型数据库系统,旨在提供与MySQL高度兼容的功能和性能,其设计初衷是为了在保持MySQL兼容性的同时,提供一些额外的特性和优化。

兼容性对比

| 特性 | MySQL | SQL_MySQL |

| 数据类型 | 支持所有标准SQL数据类型 | 同样支持所有标准SQL数据类型 |

| SQL语法 | 完全支持ANSI SQL | 完全支持ANSI SQL |

| 性能 | 高性能查询执行 | 类似或略高的查询性能 |

| 存储引擎 | InnoDB, MyISAM等 | 支持InnoDB及其他存储引擎 |

| 安全性 | 用户认证、SSL加密 | 用户认证、SSL加密 |

| 备份与恢复 | 支持多种备份工具和方法 | 支持多种备份工具和方法 |

| 扩展性 | 垂直扩展 | 垂直扩展 |

| 社区支持 | 庞大的用户和开发者社区 | 较小的但活跃的社区 |

KingbaseES数据库与MySQL的兼容性

KingbaseES是一款国产企业级关系型数据库,通过内核兼容实现对MySQL的高度兼容,以下是KingbaseES与MySQL的详细兼容性对比:

1、数据类型:KingbaseES兼容MySQL的绝大部分数据类型,包括数值类型(如INT、BIGINT、FLOAT、DOUBLE等)、日期和时间类型(如DATETIME、TIMESTAMP等)、字符串类型(如CHAR、VARCHAR等)以及其他复杂数据类型(如ENUM、SET、JSON等)。

2、SQL语法:KingbaseES支持MySQL的大部分SQL语法,包括SELECT、INSERT、UPDATE、DELETE等基本操作,以及复杂的SQL查询如子查询、联接操作、聚合函数等,KingbaseES还支持对JSON数据进行查询和操作,提供了丰富的JSON函数。

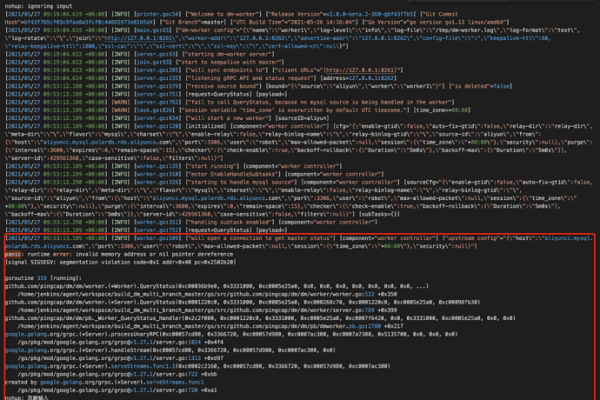

3、存储引擎和分区功能:KingbaseES本质上是一个基线加增量的存储引擎,采用LSM树(LogStructured Merge Tree)作为存储机制,这与传统的关系数据库存储引擎有所不同,尽管如此,KingbaseES仍然提供了与MySQL相似的分区功能,支持分区表和二级分区。

4、优化器和执行计划:KingbaseES的优化器在执行查询时会生成与MySQL相似的执行计划,两者在执行计划的表示和细节上可能存在差异,KingbaseES还支持使用EXPLAIN语法查看执行计划,这有助于用户理解和优化查询性能。

5、备份与恢复:KingbaseES在备份与恢复方面有所不同,KingbaseES不支持冷备份、数据库和表级的备份恢复以及备份数据的有效性验证,在使用KingbaseES时需要考虑这些差异并采取相应的措施来确保数据的完整性和可用性。

6、JDBC驱动的支持:由于KingbaseES兼容MySQL协议,现有的MySQL JDBC驱动可以直接用于KingbaseES,无需额外配置。

7、其他特性:KingbaseES支持BIT、ENUM类型、SET类型等特殊类型,支持INTERVAL表达式,MySQL的用户变量,REPLACE,INSERT ON DUPLICATE KEY子句,INSERT IGNORE INTO子句,DELETE和UPDATE语句支持LIMIT子句,建表兼容CURRENT_TIMESTAMP ON UPDATE CURRENT_TIMESTAMP子句,COMOMENT子句,多表更新等能力。

FAQs

1、问题:KingbaseES是否完全兼容MySQL的所有功能?

解答:虽然KingbaseES在很多方面与MySQL高度兼容,但仍有一些细微的差异,KingbaseES不支持某些特定的存储过程、触发器和外键约束,在迁移到KingbaseES时,可能需要对部分代码进行调整。

2、问题:如何选择适合自己需求的数据库?

解答:选择数据库时应考虑以下因素:

性能需求:是否需要高吞吐量和低延迟。

可扩展性:是否需要水平扩展或垂直扩展。

兼容性:是否需要与现有系统的无缝集成。

成本:开源解决方案(如TiDB)还是商业解决方案(如华为GaussDB)。

社区和支持:是否有活跃的社区和专业的技术支持。