存储视频

- 行业动态

- 2025-02-21

- 10

全面解析与实用指南

在当今数字化时代,视频已成为信息传播、娱乐休闲、工作记录等不可或缺的一部分,无论是个人用户记录生活点滴,还是企业用于宣传推广、在线教育平台提供课程内容,都面临着视频存储的问题,以下将从视频存储的常见方式、存储介质的选择、影响存储的因素以及存储策略等方面进行详细阐述。

一、视频存储的常见方式

| 存储方式 | 特点 | 适用场景 |

| 本地硬盘存储 | 将视频文件直接保存在计算机、移动硬盘、硬盘录像机等本地设备的硬盘上,这种方式存储容量较大,读写速度快,数据安全性相对较高,用户可以方便地对视频进行管理和编辑,但本地硬盘存储存在设备损坏导致数据丢失的风险,且存储空间有限,需要定期清理或扩展存储设备。 | 适合个人用户存储少量珍贵的视频素材,如家庭录像、个人作品等;也适用于一些小型工作室在本地进行视频剪辑和后期制作时暂存视频文件。 |

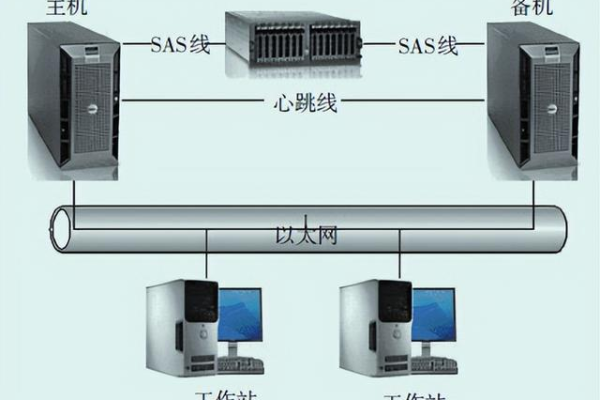

| 网络云盘存储 | 借助互联网将视频上传至云服务提供商的服务器上进行存储,具有存储空间大、可随时随地访问(只要有网络连接)、多设备同步方便等优点,并且云服务提供商通常会采取数据冗余备份等措施来保障数据的安全性,不过,网络云盘的上传和下载速度可能会受到网络带宽的限制,而且部分云盘服务可能需要付费才能获得较大的存储空间或更高的服务质量。 | 常用于个人用户备份重要视频文件、在不同设备间共享视频资料;企业用户也可利用云盘进行团队协作,存储和分享项目相关的视频文档等。 |

| 外部存储设备(如 U 盘、移动硬盘、存储卡等) | 通过 USB 接口或其他数据传输接口与计算机等设备连接,实现视频的存储和传输,其便携性强,易于携带和使用,可根据需要随时插拔,但存储容量相对有限,且容易受到物理损坏(如摔落、进水等)而丢失数据。 | 适合在外出旅行、临时工作等场景下快速转移少量视频文件,或者作为紧急情况下的视频备份手段。 |

二、存储介质的选择

机械硬盘(HDD):传统的机械硬盘采用磁头读取磁盘上的磁性数据来存储信息,它的优点是存储容量大、价格相对较低,适合存储大量的视频数据,常见的台式机机械硬盘容量可达数 TB,能够满足一般用户长期存储大量视频的需求,机械硬盘内部有高速旋转的盘片和移动的磁头,容易受到震动和磁场的影响,导致数据损坏,而且读写速度相对较慢,尤其是在随机读写小文件时性能不佳。

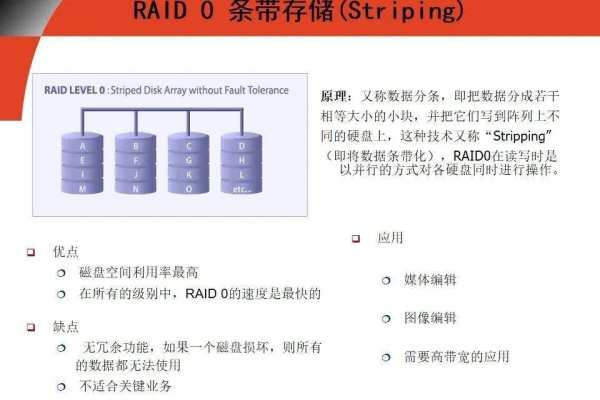

固态硬盘(SSD):固态硬盘使用闪存芯片存储数据,没有机械部件,因此具有更快的读写速度、更低的功耗和更好的抗震性,这使得 SSD 在启动系统、加载软件和传输大型视频文件时表现出色,大大缩短了等待时间,不过,SSD 的价格相对 HDD 较高,同等容量下成本更贵,所以在选择时需要根据预算和使用需求权衡,对于经常处理高清视频、需要进行快速视频剪辑和渲染的专业用户来说,SSD 是更好的选择;而对于普通用户只是单纯存储视频,HDD 则更具性价比。

三、影响视频存储的因素

视频分辨率和编码格式:视频的分辨率越高(如从标清到高清、超高清甚至 4K、8K),每帧图像所包含的像素数量就越多,数据量也就越大,相应地需要的存储空间也就更多,一段时长为 1 分钟的 1080P 视频大小可能在几十 MB 到几百 MB 不等,而同样时长的 4K 视频大小则可能是 1080P 视频的数倍甚至十几倍,不同的视频编码格式对视频的压缩程度不同,从而影响存储空间需求,常见的编码格式如 H.264、H.265 等,H.265 在保证相同视频质量的前提下,能够比 H.264 更有效地压缩视频数据,节省存储空间。

视频时长:显而易见,视频时长越长,所需的存储空间就越大,在录制或获取视频时,如果预计视频时长较长且对画质有一定要求,就需要提前规划好足够的存储空间,以免出现存储空间不足的情况。

四、视频存储策略

定期整理和分类:随着时间的推移,积累的视频文件会越来越多,为了避免混乱和方便查找,应定期对视频进行整理和分类,可以按照视频的主题(如家庭生活、旅游、工作项目等)、拍摄时间、分辨率等标准建立文件夹,并为每个文件夹和视频文件添加详细的描述性标签或备注信息,这样在需要查找特定视频时就能快速定位。

多副本备份:为了防止因硬件故障、人为误操作或自然灾害等原因导致视频数据丢失,建议采用多副本备份的策略,可以将重要的视频文件同时存储在本地硬盘、外部存储设备和网络云盘等多个位置,确保即使其中一个存储介质出现问题,其他副本仍然可用,定期检查备份数据的完整性,及时修复或更新损坏的备份文件。

相关问答 FAQs:

问题 1:如何选择适合自己的视频存储方式?

解答:选择视频存储方式需要综合考虑多个因素,如果您注重数据的安全性和大容量存储,且对读写速度要求不高,本地硬盘存储是一个不错的选择;如果您需要随时随地访问视频并方便在不同设备间共享,网络云盘存储可能更适合您;而如果您只是偶尔临时存储少量视频文件且追求便携性,外部存储设备则是较为合适的方式。

问题 2:如何判断自己的存储介质是否需要升级?

解答:当您发现现有的存储介质经常出现存储空间不足的情况,或者在存储、读取视频文件时速度明显变慢影响到您的正常使用,可能就需要考虑升级存储介质了,如果您是一名视频创作者,随着创作量的增加和视频素材质量的提高,原有的机械硬盘存储空间已满且读写速度无法满足实时剪辑的需求,此时就可以升级到容量更大、速度更快的固态硬盘或外接高速存储设备。

小编有话说:视频存储虽然看似简单,但其中涉及到的方方面面都需要我们认真对待,选择合适的存储方式、存储介质,并制定良好的存储策略,不仅能帮助我们更好地保存珍贵的视频回忆和重要的工作资料,还能避免因数据丢失而带来的损失和困扰,希望大家都能根据自己的实际需求,找到最适合自己的视频存储方案,让数字时代的视频记忆得以长久留存。