服务器上跑深度学习

- 行业动态

- 2025-02-25

- 7

在服务器上运行深度学习项目,可以充分利用服务器的强大计算能力、稳定性和可扩展性,从而高效地完成模型训练、评估和部署等任务,以下将详细介绍如何在服务器上运行深度学习项目:

1、准备工作

选择服务器:可以选择租用云服务器(如AWS、Google Cloud、Azure等)或在本地搭建,如果选择云服务,需要注意选择具有GPU资源的实例,能够极大提高深度学习的训练效率。

安装必要的工具和库:在服务器上,需要确保安装Python(建议使用3.x版本)、pip(Python包管理工具)、深度学习框架(如TensorFlow、PyTorch等)以及其他依赖库(如NumPy、Pandas、Matplotlib等)。

2、项目结构

创建适当的项目结构可以使项目更具可读性和可维护性,一个典型的深度学习项目可以按照以下结构组织:

data/:存放数据集的位置。

models/:存放模型的定义文件。

notebooks/:存放Jupyter Notebook的文件,用于数据探索和可视化。

scripts/:存放执行脚本(如训练模型的脚本)。

requirements.txt:记录项目依赖包。

3、数据处理

在深度学习项目中,数据处理是至关重要的,需要加载、预处理和划分训练集和测试集,可以使用Python的sklearn.model_selection模块中的train_test_split函数来划分数据集。

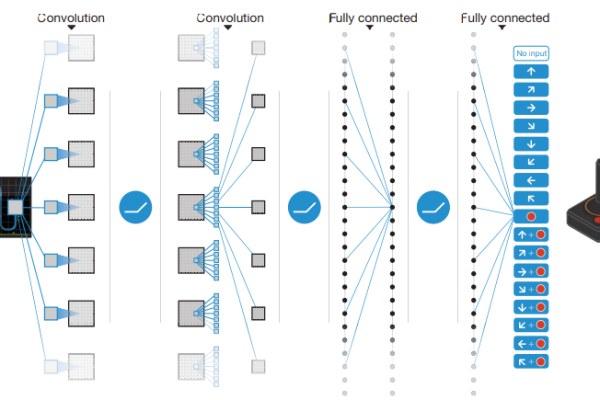

4、模型定义

在模型部分,可以根据需要定义不同的深度学习模型,可以定义一个简单的卷积神经网络(CNN)作为示例。

5、模型训练

使用定义好的模型及数据集进行模型训练,在训练过程中,需要指定优化器、损失函数等参数,并监控训练过程中的损失值和准确率等指标。

6、模型评估

在训练完成后,需要对模型进行评估以了解其性能,通常使用测试数据集来评估模型,并比较模型在测试数据集上的准确率和损失值等指标。

7、模型部署

如果模型的性能满足要求,就可以将模型部署到生产环境中使用了,在部署时,需要考虑生产环境和服务器之间的网络连接、选择合适的部署框架或工具等因素。

以下是两个关于在服务器上跑深度学习的常见问题及解答:

1、问:在服务器上跑深度学习需要哪些硬件配置?

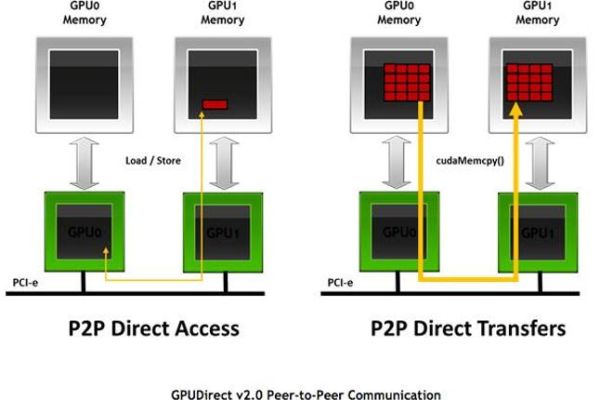

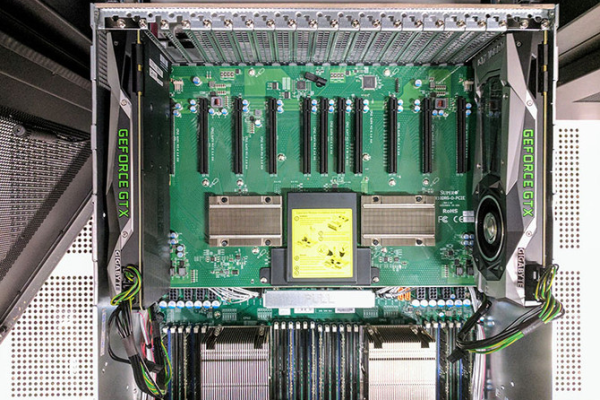

答:在服务器上跑深度学习需要具备一定的硬件配置,包括高性能的CPU、大量的内存和存储空间以及GPU加速卡等,具体配置要求取决于深度学习项目的规模和复杂度,对于大规模的深度学习项目,建议选择具有多个GPU的服务器实例来保证计算性能和内存充足。

2、问:如何在服务器上安装深度学习框架?

答:在服务器上安装深度学习框架可以通过多种方式进行,一种常见的方式是通过包管理工具(如pip或conda)来安装,可以使用以下命令来安装TensorFlow框架:

“`

pip install tensorflow

也可以从深度学习框架的官方网站下载预编译的二进制文件进行安装。

小编有话说:在服务器上跑深度学习可以充分利用服务器的强大计算能力和存储资源,提高模型训练和推理的效率,在进行深度学习项目时,建议根据实际需求选择合适的服务器配置和深度学习框架,并遵循相关的最佳实践和指南来确保项目的顺利进行。