ai服务器的构造,究竟包含哪些关键零部件?

- 行业动态

- 2024-08-14

- 1

AI服务器的零部件主要包括CPU(中央处理器)、GPU(图形处理器)、内存、存储设备、网络接口卡、主板、电源和散热系统。这些部件共同工作,以处理和执行复杂的人工智能算法和任务。

AI服务器作为计算密集型的任务承载设备,其设计和构成对运行效率和处理能力起着至关重要的作用,这类服务器不仅需要强大的算力支持,还要求有高速的数据处理能力和大量的存储空间以适应复杂的人工智能算法和大数据处理需求,我们将详细探讨AI服务器的主要零部件及其功能,帮助读者更好地理解这些高性能机器的内部构造。

CPU

CPU,即中央处理器,是AI服务器的大脑,它负责处理指令、运算数据以及控制服务器的所有其他硬件,AI服务器中的CPU通常采用高性能的设计,如X86、ARM、MIPS、RISCV等不同架构来满足多样化的处理需求,随着技术的发展,CPU的性能不断提升,核数增多,能够同时处理更多的计算任务。

GPU

GPU,图形处理器,原本设计用于加速图形渲染,现在已经成为AI服务器中不可或缺的部分,与CPU相比,GPU在并行处理大量数据时更为高效,特别适用于机器学习、深度学习和其他需要高强度计算的AI任务。

FPGA/ASIC/NPU

这些定制的加速芯片,如现场可编程门阵列(FPGA)、专用集成电路(ASIC)和神经网络处理单元(NPU),专为特定的AI应用或算法优化设计,它们能够提供更高的效率和处理速度,是AI服务器中重要的加速组件。

内存

AI服务器中使用的内存主要包括DRAM和高带宽存储器(HBM),DRAM以其高速的数据处理能力被广泛使用于AI服务器中,而HBM则因其更高的数据传输速率和更低的功耗而逐渐受到青睐,尤其是在处理大规模数据集时。

本地存储SSD

固态硬盘(SSD)在AI服务器中承担着快速数据读写的角色,基于NAND Flash技术的SSD提供了高速的存取速率和较大的存储容量,是存储密集型AI应用的理想选择。

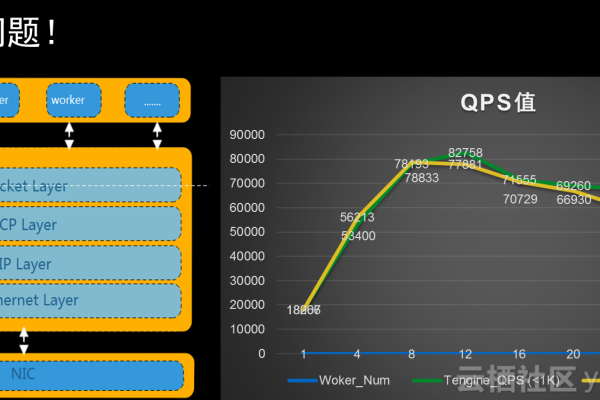

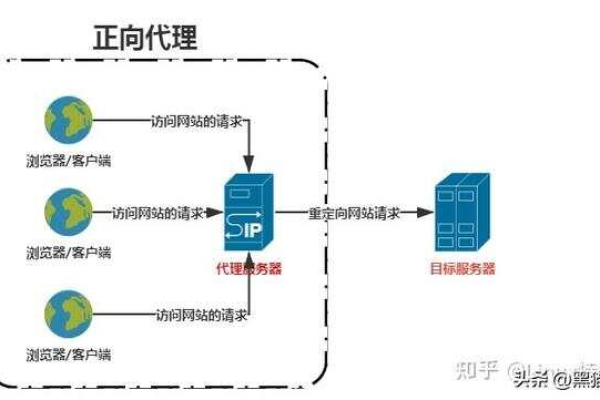

网络接口卡NIC

网络接口卡(NIC)是AI服务器与外界通信的桥梁,尤其在云计算和数据中心的应用中尤为重要,高速的网络连接保证了数据的迅速传输,对于维持AI服务的响应速度和稳定性至关重要。

PCIe插槽

PCIe插槽为AI服务器提供了扩展能力,可以通过插接额外的卡如GPU加速卡、网络卡等来增强服务器的功能,这一模块化设计使得服务器可以根据具体的应用需求进行定制和升级。

散热系统

由于AI服务器在运行时会产生大量热量,高效的散热系统是必不可少的,这包括风扇、散热片、液冷系统等多种散热方案,确保服务器能在最佳温度下运行,提高稳定性和寿命。

电源管理

稳定的电源管理系统不仅保证AI服务器的持续运行,还能在保证能效的同时提升整体性能,电源系统需要有足够的容量和高效率来支持服务器的高负载操作。

FAQs

Q1: AI服务器与传统服务器有什么不同?

A1: AI服务器相较于传统服务器拥有更复杂的硬件架构,常采用“CPU+其他加速卡”的异构形式,尤其是CPU+GPU配置,AI服务器的设计更加独特,针对系统结构、散热和拓扑等方面进行了专门的优化,技术也更为专用。

Q2: 为什么AI服务器需要高速的内存和存储设备?

A2: 高速的内存如DRAM和HBM以及快速的本地存储SSD对于AI服务器至关重要,主要是因为AI任务,特别是机器学习和深度学习模型需要处理和分析大量数据,高速的内存和存储设备可以显著提高数据处理速度和存取效率,从而加快AI模型的训练和推理速度。

本站发布或转载的文章及图片均来自网络,其原创性以及文中表达的观点和判断不代表本站,有问题联系侵删!

本文链接:http://www.xixizhuji.com/fuzhu/53197.html