Android神经网络框架,如何实现高效深度学习模型?

- 行业动态

- 2025-03-04

- 8

Android神经网络框架

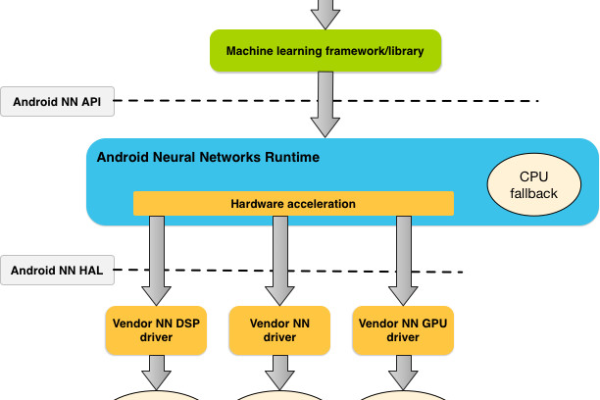

1、Android Neural Networks API (NNAPI):

简介:NNAPI是一个Android C API,旨在为更高层级的机器学习框架(如TensorFlow Lite和Caffe2)提供基本功能层,用于建立和训练神经网络,它支持在Android设备上进行推断,具有延迟低、可用性高、速度快、隐私性好和费用低等优势。

主要抽象概念:包括模型(由数学运算和常量值构成的计算图)、编译(将模型编译到更低级别代码的配置)、内存(表示共享内存等缓冲区)和执行(将模型应用到输入并收集结果的接口)。

编程模型:使用NNAPI执行计算时,需先构造有向图定义计算,结合输入数据构成模型,然后进行模型创建、编译、执行等操作。

已知问题:在某些情况下,如将特定类型的张量传递到某些运算时可能会出现兼容性问题。

2、TensorFlow Lite:

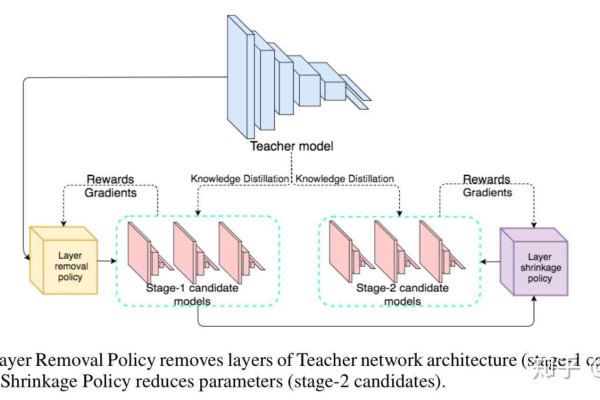

简介:是Google针对移动设备开发的开源神经网络软件包,支持各种类型的神经网络架构,并提供了一系列的API和转换工具,以便在Android应用程序中进行集成和使用,它还针对移动设备的特点进行了优化,如量化、剪枝等,以提高推理速度和降低内存消耗。

特点:具有较好的跨平台性,能够在不同操作系统上运行;支持多种硬件加速方式,可利用设备的GPU、CPU等资源提高推理性能;提供了丰富的预训练模型和工具,方便开发者快速构建和部署应用。

应用场景:适用于各种需要神经网络推理的移动应用,如图像识别、语音识别、自然语言处理等领域。

3、Kotlin Neural Networks:

简介:是Kotlin语言的一个扩展库,专门用于神经网络的开发,它提供了一种简洁易用的API,使开发者能够使用Kotlin语言轻松地创建和训练神经网络。

特点:与Kotlin语言无缝集成,语法简洁直观,提高了开发效率;支持各种类型的神经网络模型,并提供了针对性的优化方法,以满足不同场景的需求。

应用场景:主要应用于基于Kotlin语言开发的Android应用中的神经网络相关任务,如智能推荐、数据分析等。

4、Hexagon NN:

简介:高通数字信号处理器的神经网络框架,旨在充分发挥DSP在移动环境中的优势,提升模型推理速度和降低功耗。

特点:针对DSP的硬件特性进行了深度优化,能够高效地处理8bit int等运算;在推理过程中,一般情况下8bit int的运算就够了,这正是dsp最擅长的计算。

应用场景:适用于在高通芯片的设备上运行的神经网络应用,能够充分发挥硬件的性能优势,提高应用的响应速度和续航能力。

5、Samsung Eden delegate:

简介:三星的移动端推理框架,其Quantized与FP类型都走Eden Delegate。

特点:针对三星自家的硬件设备进行了优化,能够更好地发挥设备的性能;提供了统一的接口,方便开发者在不同的三星设备上进行应用的移植和部署。

应用场景:主要用于三星品牌的Android设备上的神经网络应用开发,能够充分利用三星硬件的特性,提供更好的性能和用户体验。

6、MediaTek Neuron delegates:

简介:联发科的神经网络代理框架,为基于联发科芯片的设备提供了神经网络推理的支持。

特点:与联发科的芯片紧密结合,能够充分发挥硬件的性能优势;针对不同的神经网络模型和应用需求,提供了相应的优化策略,以提高推理的准确性和效率。

应用场景:适用于搭载联发科芯片的Android设备上的神经网络应用开发,能够满足用户对高性能神经网络推理的需求。

相关问题与解答

1、问:为什么Android设备上的神经网络框架需要进行量化?

答:量化是将神经网络中的浮点数参数转换为整数的过程,在Android设备上进行量化主要有以下原因:一是可以降低内存消耗,因为整数类型的数据占用的内存空间比浮点数小;二是能够提高计算速度,整数运算在硬件上的执行效率通常比浮点数运算要高;三是减少功耗,对于移动设备来说,功耗是一个重要的考虑因素,量化后的模型在推理时所需的计算量减少,从而降低了功耗。

2、问:如何选择合适的Android神经网络框架?

答:在选择Android神经网络框架时,需要考虑以下几个因素:一是应用的需求,如模型的类型、复杂度、精度要求等;二是设备的性能和硬件支持,不同的框架对硬件的要求不同,需要根据设备的处理器、内存等硬件条件来选择;三是开发难度和成本,一些框架可能提供了更丰富的工具和文档,便于开发者快速上手和开发;四是社区支持和生态系统,一个活跃的社区和完善的生态系统能够提供更多的资源和支持,帮助开发者解决问题和进行应用的维护。