小程序服务器费用如何影响开发预算?

- 行业动态

- 2024-08-28

- 3108

小程序服务器费用

在当今移动互联网时代,微信小程序已经成为企业和个人进行线上业务拓展的重要工具之一,小程序的开发不仅需要前端的技术实现,还需要后端的服务器支持以保障数据存储、处理和交互等功能的正常运行,了解小程序服务器的费用构成对于预算规划至关重要。

服务器费用的主要组成

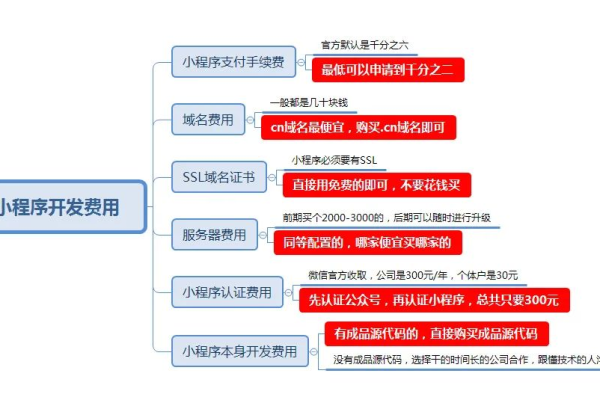

小程序服务器的费用通常包括以下几个部分:

1、服务器租赁费:这是最基本的费用,取决于你选择的服务器类型(如虚拟主机、云服务器等)、配置(cpu核心数、内存大小、硬盘空间等)以及服务商的定价。

2、带宽费用:根据小程序的访问量,你需要选择相应的带宽,高访问量意味着需要更大的带宽,相应的费用也会增加。

3、数据库费用:大多数小程序都需要数据库来存储用户数据、交易记录等信息,数据库的选择(如mysql、mongodb等)和规模会影响成本。

4、域名费用:如果你的小程序需要通过独立域名访问,那么还需要计入域名注册和续费的费用。

5、ssl证书费用:为了保证数据传输的安全,小程序通常会采用https协议,这就需要购买ssl证书。

6、备份和恢复服务费用:定期的数据备份和恢复服务可以防止数据丢失,这也是额外的成本来源。

7、维护和支持费用:包括服务器监控、故障排除、安全更新等服务,有些服务商可能会将这些服务包含在租赁费中,有些则需额外支付。

费用估算表格

| 项目 | 说明 | 预估费用范围 |

| 服务器租赁费 | 根据服务器类型和配置不同而变化 | ¥500¥3000/月 |

| 带宽费用 | 依据访问量调整 | ¥200¥2000/月 |

| 数据库费用 | 按需求选择不同规模 | ¥100¥1000/月 |

| 域名费用 | 通常年付 | ¥50¥100/年 |

| ssl证书费用 | 可选购单域名或多域名证书 | ¥0¥1000/年 |

| 备份和恢复服务费用 | 依据服务商提供方案而定 | ¥100¥500/月 |

| 维护和支持费用 | 可选服务,视服务商而定 | ¥0¥1000/月 |

相关问题与解答

q1: 我可以选择免费服务器吗?

a1: 市面上有一些免费的服务器选项,但这些通常适用于个人学习或小型项目,对于商业级别的小程序来说,免费服务器往往无法满足性能、稳定性和安全性的需求,免费服务器可能伴随有广告或者功能限制。

q2: 如何降低小程序服务器费用?

a2: 降低费用的方法包括选择合适的服务器配置以避免资源浪费、利用云服务的弹性伸缩功能来根据实际使用调整资源、选择性价比高的服务商、以及合理规划带宽和数据库的使用,可以考虑年度预付等方式获取折扣,以及及时关注服务商的优惠活动。

本站发布或转载的文章及图片均来自网络,其原创性以及文中表达的观点和判断不代表本站,有问题联系侵删!

本文链接:http://www.xixizhuji.com/fuzhu/51710.html