存储系统究竟能为我们带来哪些实际应用和功能?

- 行业动态

- 2025-01-25

- 9

存储系统是计算机系统中不可或缺的一部分,它负责数据的保存、管理和检索,无论是个人电脑、服务器还是云平台,存储系统都扮演着至关重要的角色,下面将详细探讨存储系统的功能和用途。

存储系统的基本功能

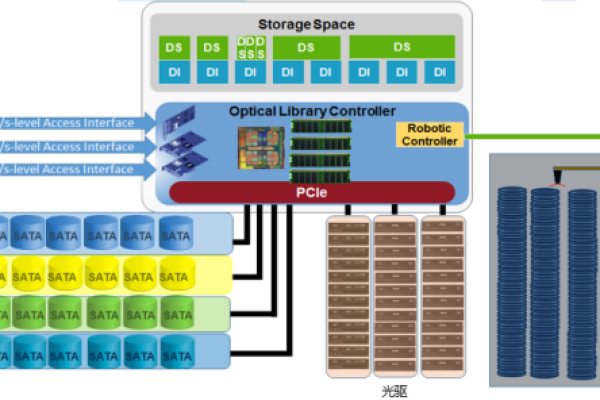

1、数据存储:这是存储系统最基本的功能,包括硬盘、固态硬盘(SSD)、光盘、磁带等介质,用于持久保存数据。

2、数据管理:包括文件系统的创建、维护和管理,确保数据能够被有效地组织和访问。

3、数据备份与恢复:提供数据备份的解决方案,以防数据丢失或损坏,同时支持快速的数据恢复。

4、数据安全:通过加密、访问控制等手段保护数据不被未授权访问或改动。

5、性能优化:通过缓存、冗余等技术提高数据访问速度和系统的整体性能。

6、可扩展性:支持存储容量的灵活扩展,以适应不断增长的数据需求。

存储系统的应用场景

| 场景 | 描述 | 典型应用 |

| 个人电脑 | 用户日常使用,存储个人文件、照片、视频等 | 内部硬盘、外置硬盘、U盘 |

| 企业数据中心 | 大规模数据存储和管理,支持业务运营 | SAN(存储区域网络)、NAS(网络附加存储) |

| 云计算 | 提供按需分配的存储资源,支持弹性伸缩 | 对象存储、块存储、文件存储服务 |

| 大数据分析 | 处理和分析海量数据,提取有价值的信息 | Hadoop分布式文件系统(HDFS)、云存储服务 |

| 媒体娱乐 | 存储和分发音乐、视频等内容 | 内容分发网络(CDN)、数字版权管理(DRM) |

| 移动设备 | 为智能手机、平板电脑等提供便携的数据存储 | 内置存储、SD卡、云同步服务 |

存储系统的高级功能

数据去重:减少存储空间的浪费,通过识别和消除重复的数据块来节省空间。

快照:创建数据在某个时间点的副本,用于灾难恢复或数据回溯。

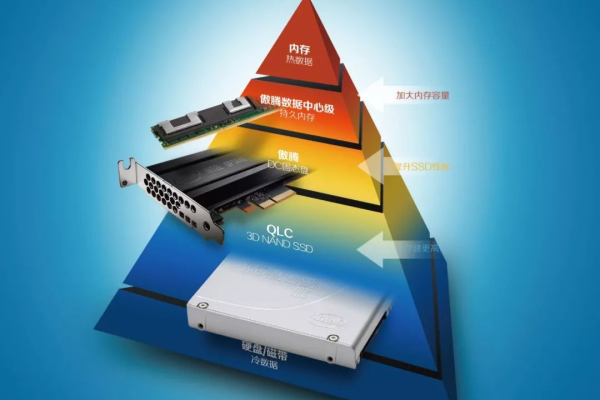

分层存储:根据数据的访问频率和重要性,自动将数据迁移到不同性能和成本的存储层。

远程复制:在不同地理位置之间复制数据,以提高数据的可用性和灾难恢复能力。

相关问答FAQs

Q1: 什么是RAID,它在存储系统中有什么作用?

A1: RAID(独立磁盘冗余阵列)是一种将多个物理磁盘组合成一个逻辑单元的技术,它可以提高数据的可靠性、可用性和存储性能,不同的RAID级别提供了不同的数据保护和性能特点,如RAID 1提供镜像备份,RAID 5提供奇偶校验等。

Q2: 云存储和本地存储有什么区别?

A2: 云存储是指通过互联网提供的在线存储服务,用户可以随时随地通过网络访问和管理数据,而本地存储则是指直接连接到用户设备的物理存储介质,如硬盘或SSD,云存储具有可扩展性强、成本较低、便于共享等优点,但可能会受到网络带宽和服务提供商的限制;本地存储则提供更快的数据访问速度和更好的数据控制。

小编有话说

在当今数字化时代,数据已成为企业和个人的宝贵资产,选择合适的存储系统对于保障数据的安全性、可用性和性能至关重要,随着技术的不断进步,存储系统也在不断发展,从传统的机械硬盘到现代的固态硬盘,再到云存储和分布式存储解决方案,每一种技术都有其独特的优势和适用场景,在选择存储系统时,需要根据具体的需求和预算进行综合考虑,也要注意数据的安全和隐私保护,确保数据不会被非规访问或滥用。