cudnn70linux

- 行业动态

- 2025-01-29

- 8

在深度学习和高性能计算领域,cuDNN(CUDA Deep Neural Network library)是NVIDIA开发的一款基于CUDA的深度学习加速库,它为深度学习框架提供了高效的GPU加速,对于Linux系统用户来说,cuDNN 7.0是一个常用的版本,以下是关于cudnn7.0linux的详细介绍:

一、安装步骤

1、确认CUDA版本:在安装cuDNN之前,需要先确保系统中已经安装了与cuDNN兼容的CUDA版本,cuDNN 7.0通常与CUDA 9.x或10.x兼容,但具体的最佳兼容性可能会因不同的硬件和软件配置而有所不同,建议参考NVIDIA官方文档或相关资源来确认最佳的CUDA版本。

2、下载cuDNN:访问NVIDIA开发者网站或其他可靠的资源网站,找到cuDNN 7.0 Linux版本的下载链接,根据系统的架构(如x86_64等)选择合适的安装包进行下载。

3、解压安装包:将下载的安装包解压到合适的目录中,可以使用以下命令进行解压:

tar -xzvf cudnn-7.0-linux-x64-v*.tgz -C /usr/local

这将会把cuDNN文件解压到/usr/local目录下。

4、设置环境变量:为了让系统能够找到cuDNN库,需要将其路径添加到环境变量中,可以在~/.bashrc或~/.profile文件中添加以下行:

export PATH=/usr/local/cuda-9.0/bin:$PATH export LD_LIBRARY_PATH=/usr/local/cuda-9.0/lib64:$LD_LIBRARY_PATH

这里的路径可能需要根据实际情况进行调整,以匹配你的CUDA安装路径。

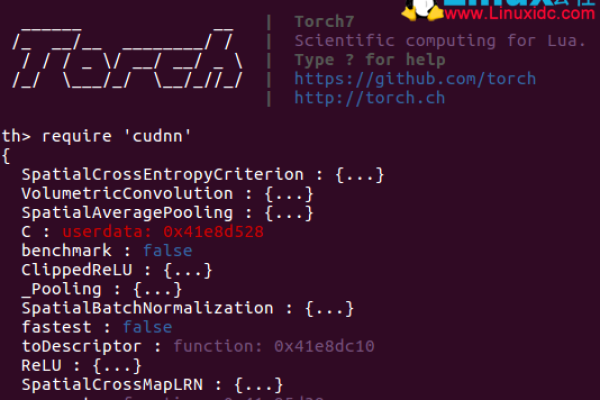

5、验证安装:为了验证cuDNN是否成功安装,可以尝试编译和运行一个简单的CUDA程序,该程序使用cuDNN函数,如果程序能够正确编译和运行,并且输出结果符合预期,那么说明cuDNN已经成功安装。

二、主要功能与特点

1、卷积操作加速:cuDNN提供了高度优化的卷积操作实现,可以显著提高卷积神经网络的训练和推理速度,这对于图像识别、目标检测等任务至关重要。

2、池化层支持:除了卷积操作外,cuDNN还支持多种池化层操作,如最大池化、平均池化等,这些操作在神经网络中用于减小数据维度和提取特征。

3、归一化层加速:归一化层是神经网络中常用的一种层类型,用于对输入数据进行归一化处理,cuDNN提供了多种归一化层的实现,包括批归一化、层归一化等,可以加速这些层的训练和推理过程。

4、激活函数支持:激活函数是神经网络中不可或缺的一部分,用于增加网络的非线性特性,cuDNN支持多种常见的激活函数,如ReLU、Sigmoid等,可以方便地在GPU上进行计算。

三、应用场景与优势

1、深度学习框架集成:多数主流的深度学习框架(如TensorFlow、PyTorch、Caffe等)都集成了cuDNN,这意味着当开发者使用这些框架并在NVIDIA GPU上运行时,他们可以自动从cuDNN的高效运算中受益。

2、性能提升:通过利用GPU的并行处理能力,cuDNN可以显著提高深度学习模型的训练和推理速度,这对于需要处理大量数据的深度学习任务来说尤为重要。

3、简化编程:cuDNN提供了简洁易用的API接口,使得开发者可以轻松地在GPU上实现复杂的深度学习算法,这降低了开发难度并提高了开发效率。

四、注意事项

1、硬件要求:安装和使用cuDNN需要NVIDIA GPU的支持,请确保你的系统配备了兼容的NVIDIA GPU。

2、软件依赖:除了CUDA外,cuDNN还依赖于其他一些软件包和库,在安装过程中,请确保这些依赖项已经满足。

3、版本更新:随着技术的不断发展,新的版本的cuDNN可能会提供更好的性能和更多的功能,建议定期关注NVIDIA官方发布的新版本并及时更新。

cuDNN 7.0 for Linux是一个强大的工具,它为深度学习框架提供了高效的GPU加速支持,通过正确的安装和配置以及充分利用其功能特点,开发者可以在Linux系统上更加高效地进行深度学习模型的开发和训练。