如何实现CPU与GPU之间的负载均衡以优化计算性能?

- 行业动态

- 2025-01-24

- 11

在CPU+GPU的混合异构计算系统中,负载均衡是确保系统高效运行的关键因素之一,由于CPU和GPU在计算能力和内存架构上的差异,实现有效的负载均衡面临诸多挑战,以下是关于CPU+GPU负载均衡的详细回答:

CPU+GPU协同计算模式

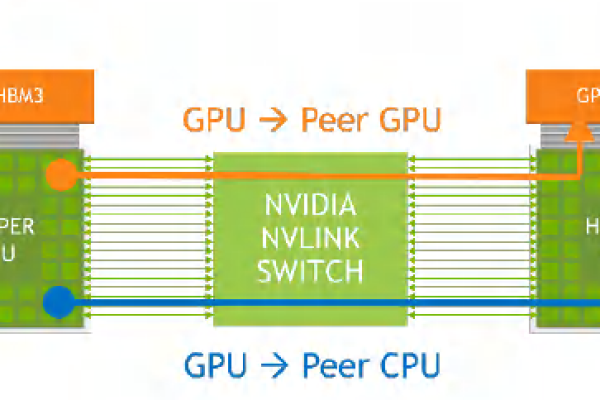

1、节点间分布式:各个节点之间采用网络连接,形成分布式计算环境,节点间通过MPI等消息通信机制进行并行计算。

2、节点内异构式:每个节点包含多核CPU和一块或多块GPU卡,采用主从式编程模型,即每个GPU卡由CPU进程/线程调用,根据CPU是否参与并行计算,可分为CPU/GPU协同计算和CPU+GPU共同计算两种模式。

3、设备内共享式:

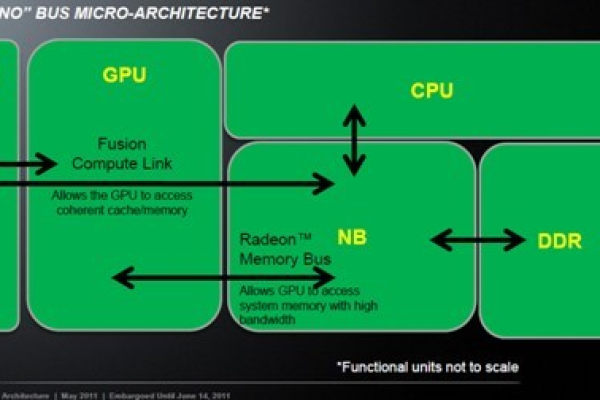

CPU设备:节点内的所有多核CPU采用共享存储模型,可使用MPI进程、OpenMP线程或pThread线程控制CPU核的并行计算。

GPU设备:GPU设备有独立的DRAM存储,采用CUDA或OpenCL编程控制GPU众核的并行计算,其中CUDA编程模式只在NVIDIA GPU上支持,OpenCL编程模式在NVIDIA GPU和AMD GPU都支持。

CPU+GPU协同计算负载均衡性设计

以CPU+GPU共同计算模式为例,该模式下的进程和线程与CPU核和GPU设备对应关系明确,若采用主从式MPI通信机制,在节点0上多起一个进程作为主进程,控制其他所有进程,每个节点上启动多个计算进程,分别控制GPU设备和其余CPU核的并行计算,在GPU内采用CUDA/OpenCL并行,在CPU设备内采用OpenMP多线程并行。

由于CPU+GPU协同计算模式分为多个层次,负载均衡性也需要在这些层次上分别设计,在上述编程方式下,节点内和节点间均采用MPI进程,设计负载均衡时,需做到进程间(设备之间)的负载均衡以及CPU设备内OpenMP线程负载均衡、GPU设备内CUDA线程负载均衡。

对于设备内,采用共享存储器模型,CPU设备上的OpenMP线程可采用schedule(static/ dynamic/ guided)方式;GPU设备上只要保证同一warp内的线程负载均衡即可。

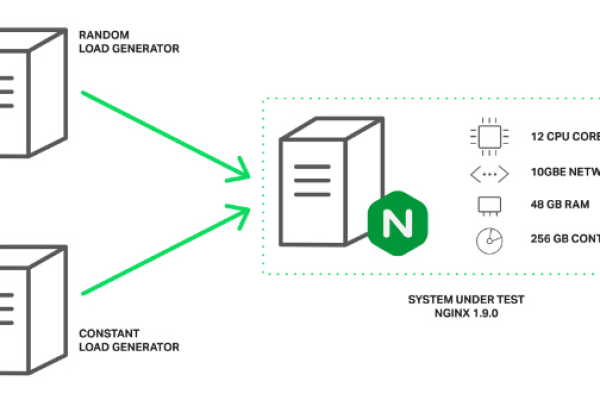

动态划分和静态划分

1、动态划分:对于一些高性能计算应用程序,可采用动态负载均衡的优化方法,例如有N个任务/数据,一个节点内有2个GPU卡及CPU,动态负载均衡的方法是每个设备先获取一个任务/数据进行计算,计算之后立即获取下一个任务,无需等待其他设备,直到N个任务/数据计算完成,这种方式只需在集群上设定一个主进程,负责给各个计算进程分配任务/数据。

2、静态划分:在一些应用中,无法采用动态划分的方式,需要静态划分方法,然而静态划分方法会使异构设备间的负载均衡变得困难,有时甚至无法实现,对于一些迭代应用程序,可以采用学习型的数据划分方法,如先让CPU和GPU分别做一次相同计算量的计算,然后通过各自的运行时间计算出CPU与GPU的计算能力比例,再对数据进行划分。

FAQs

1、如何选择合适的负载均衡策略?

选择负载均衡策略需根据具体的应用场景和计算任务特点来决定,如果任务计算量差异大且实时性要求高,动态负载均衡可能更合适;如果是迭代应用程序且对负载均衡精度要求不是特别高,静态划分或学习型数据划分方法可能更为适用,还需考虑系统的扩展性和资源利用率等因素。

2、如何评估负载均衡的效果?

可以通过多种指标来评估负载均衡的效果,如各设备的利用率、任务的平均等待时间、系统的吞吐量等,在实际应用中,可通过性能监测工具收集相关数据,分析不同阶段的负载情况,对比采用不同负载均衡策略前后的性能指标变化,从而评估负载均衡策略的有效性。