分布式存储系统究竟有何特点与重要意义?

- 行业动态

- 2024-12-31

- 8

分布式存储系统是一种将数据分散存储在多台独立的设备上的存储技术,它通过网络连接这些设备,形成一个虚拟的、统一的存储池,供用户和应用访问,这种系统具有以下显著特点:

1、大容量:通过使用通用的X86架构存储服务器作为构建单元,分布式存储系统可以根据用户需求横向无限扩展存储节点,形成一个统一的共享存储池。

2、高性能:相比传统存储系统,分布式存储系统提供更高的聚合IOPS和吞吐量,并且随着存储节点的扩容而线性增长,专用的元数据模块可以提供非常快速精准的数据检索和定位,满足前端业务快速响应的需求。

3、高可靠性:整个系统无任何单点故障,数据安全和业务连续性得到保障,每个节点可视为一块硬盘,节点设备之间有专门的数据保护策略,可实现系统的设备级冗余,并且可在线更换损坏的硬盘或节点设备。

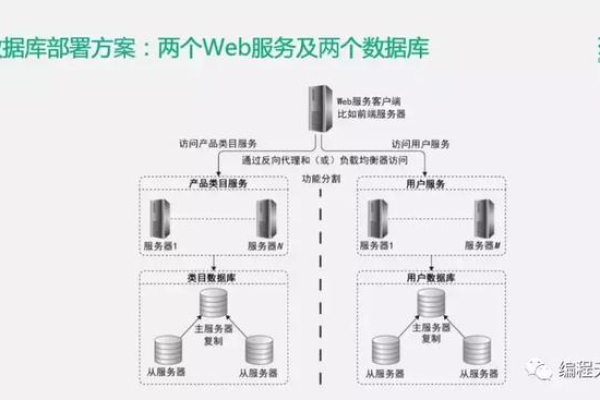

4、易扩展:系统支持在线无缝动态横向扩展,在采用冗余策略的情况下,任何一个存储节点的上线和下线对前端的业务没有任何影响,完全是透明的,系统在扩充新的存储节点后可以选择自动负载均衡,所有数据的压力均匀分配在各存储节点上。

5、易整合:兼容任何品牌的X86架构通用存储服务器,在标准的IP/IB网络环境下即可轻松实施,无需改变原有网络架构。

6、易管理:可通过一个简单的WEB界面对整个系统进行配置管理,运维简便,管理成本极低。

分布式存储系统的意义在于:

1、提高数据可靠性和可用性:通过数据分片和副本复制技术,即使某些节点出现故障,仍然可以从其他节点中恢复数据,从而提高了数据的可靠性和可用性。

2、易于扩展:随着数据量的增长,分布式存储系统可以方便地增加节点,提高存储容量和计算能力。

3、降低成本:分布式存储系统采用廉价的服务器组件,通过规模效应降低成本,高效的存储和计算资源利用率也减少了能源消耗。

4、灵活性强:分布式存储系统可以根据应用程序的需求进行配置和调整,以满足不同的数据存储和访问需求。

以下是两个关于分布式存储系统的常见问题及其解答:

问题1:分布式存储系统如何确保数据的一致性?

答:分布式存储系统通常使用数据同步和管理机制来确保数据的一致性,可以使用Paxos算法、Raft算法或ZooKeeper等分布式协调服务来实现数据同步和管理,这些机制通过选举、投票、复制等过程来保证不同节点上的数据副本是一致的。

问题2:分布式存储系统如何处理大数据?

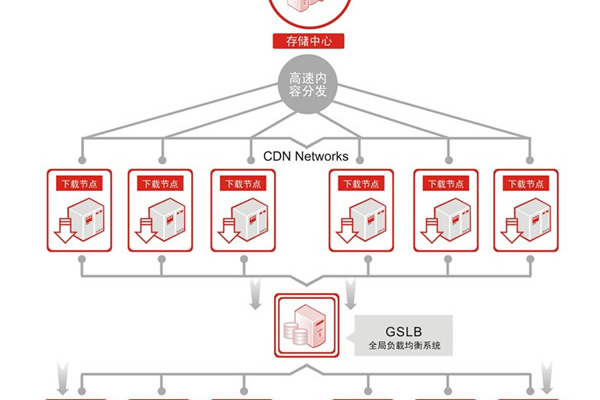

答:分布式存储系统处理大数据的方式主要包括数据分片、数据备份、负载均衡以及数据压缩和优化等,数据分片是将大数据拆分成多个小块进行存储,每个小块存储在不同的节点上,实现数据的分布式存储和并行处理,数据备份则是为了提高数据的可靠性和容错性,将数据存储在多个节点上,一旦某个节点发生故障,数据可以从备份节点中恢复,负载均衡算法用于均衡数据的访问和处理负载,确保每个节点的负载均衡,以提高系统的性能和可靠性,还可以采用数据压缩和优化技术来减少数据的存储和传输开销。

小编有话说:随着数据量的爆炸式增长,传统的集中式存储方式已经难以满足大规模数据存储的需求,分布式存储系统以其大容量、高性能、高可靠性和易扩展等特点,成为了大数据时代的理想选择,在选择和部署分布式存储系统时,我们也需要注意其复杂性和管理难度,建议在选择分布式存储系统时,充分考虑自身的业务需求和技术实力,选择适合自己的解决方案。