如何在Chrome浏览器中使用JS搜索快捷键?

- 行业动态

- 2024-12-20

- 2386

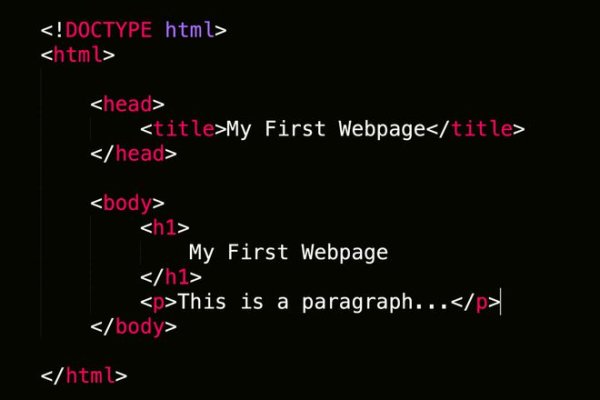

1、基本快捷键

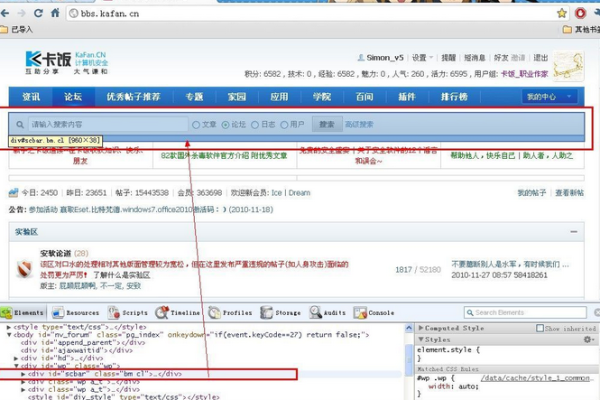

Ctrl + Shift + F:在Windows系统中,使用Ctrl + Shift + F可以全局搜索所有资源中的关键字,这个快捷键非常适用于需要在整个项目中快速查找特定字符串或变量的情况。

Cmd + Opt + F:在Mac系统中,对应的快捷键是Cmd + Opt + F,这个功能同样强大,可以帮助开发者快速定位代码中的特定部分。

2、文件名搜索快捷键

Ctrl + O:在Windows系统中,使用Ctrl + O可以根据文件名查找特定的JavaScript文件,这个快捷键特别适用于项目较大时,快速跳转到目标文件。

Cmd + O:在Mac系统中,对应的快捷键是Cmd + O,这个功能可以帮助开发者节省大量时间,特别是在处理多个文件的情况下。

3、样式属性搜索快捷键

Ctrl + Click on property:在Windows系统中,点击CSS属性值可以定位到样式属性定义的位置,这对于调试和修改样式非常有用。

Cmd + Click on property:在Mac系统中,对应的操作是Cmd + Click on property,这个功能可以帮助开发者快速找到并编辑样式属性。

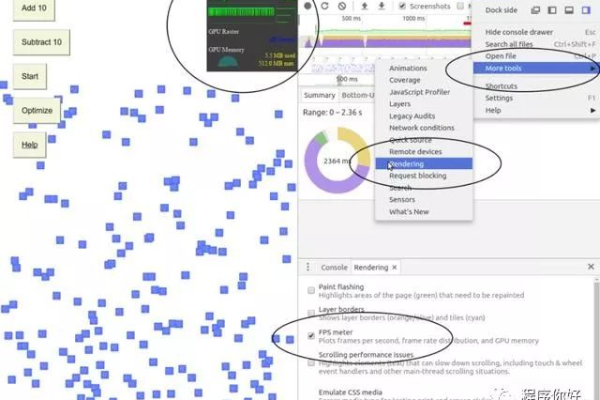

4、颜色值循环快捷键

Shift + Click on color picker box:在Windows系统中,使用Shift + Click可以循环颜色值(rgba, hsl等),这对于前端开发者调整颜色非常有用。

Opt + Click on color picker box:在Mac系统中,对应的操作是Opt + Click,这个功能可以帮助开发者更直观地选择和调整颜色。

5、控制台运行代码快捷键

Ctrl + Shift + E:在Windows系统中,使用Ctrl + Shift + E可以在控制台中立即运行当前选中的代码片段,这对于测试和调试代码非常有用。

Cmd + Shift + E:在Mac系统中,对应的快捷键是Cmd + Shift + E,这个功能可以帮助开发者快速验证代码的正确性。

6、断点管理快捷键

F8, F10, Ctrl+:在Windows系统中,这些快捷键用于暂停、恢复脚本运行以及删除断点,这对于调试复杂的JavaScript代码非常有用。

Fn+F8, Fn+F10, Cmd+:在Mac系统中,对应的快捷键是Fn+F8, Fn+F10, Cmd+,这些功能可以帮助开发者更好地控制代码的执行流程。

7、代码格式化快捷键

Ctrl + Shift + P:在Windows系统中,使用Ctrl + Shift + P可以格式化压缩后的代码,使其更具可读性,这对于阅读和维护代码非常重要。

Cmd + Shift + P:在Mac系统中,对应的快捷键是Cmd + Shift + P,这个功能可以帮助开发者快速整理代码,提高开发效率。

8、代码折叠与展开快捷键

Ctrl + Alt + [:在Windows系统中,使用Ctrl + Alt + [可以隐藏元素及其子元素,这对于聚焦特定代码部分非常有用。

Opt + Click on arrow icon:在Mac系统中,对应的操作是Opt + Click on arrow icon,这个功能可以帮助开发者更好地组织和管理代码结构。

以下是两个相关的FAQs:

Q1: 如何在Chrome DevTools中快速查找某个函数的定义?

A1: 在Chrome DevTools中,你可以使用Ctrl + Shift + F(Windows)或Cmd + Opt + F(Mac)进行全局搜索,输入函数名即可快速定位到该函数的定义位置,你还可以使用Ctrl + O(Windows)或Cmd + O(Mac)根据文件名查找特定的JavaScript文件,进一步缩小搜索范围。

Q2: Chrome DevTools中有哪些实用的快捷键可以提高开发效率?

A2: Chrome DevTools提供了许多实用的快捷键,如Ctrl + Shift + F(Windows)或Cmd + Opt + F(Mac)进行全局搜索,Ctrl + O(Windows)或Cmd + O(Mac)根据文件名查找JavaScript文件,Ctrl + Click on property(Windows)或Cmd + Click on property(Mac)定位到样式属性定义的位置,以及Shift + Click on color picker box(Windows)或Opt + Click on color picker box(Mac)循环颜色值等,掌握这些快捷键可以大大提高开发效率。

Chrome DevTools提供了丰富的快捷键,帮助开发者更高效地进行Web前端开发和调试,通过熟练掌握这些快捷键,开发者可以大大提高工作效率,减少不必要的操作步骤。

以上内容就是解答有关“chrom js搜索快捷键”的详细内容了,我相信这篇文章可以为您解决一些疑惑,有任何问题欢迎留言反馈,谢谢阅读。

本站发布或转载的文章及图片均来自网络,其原创性以及文中表达的观点和判断不代表本站,有问题联系侵删!

本文链接:http://www.xixizhuji.com/fuzhu/44969.html