服务器建邮件服务

- 行业动态

- 2025-02-13

- 8

服务器建邮件服务的详细步骤与要点

在当今数字化时代,拥有自己的邮件服务对于企业或个人来说都具有重要意义,通过在服务器上搭建邮件服务,能够实现更加自主、安全且定制化的邮件通信,以下将详细介绍如何在服务器上建立邮件服务的各个方面。

一、前期准备

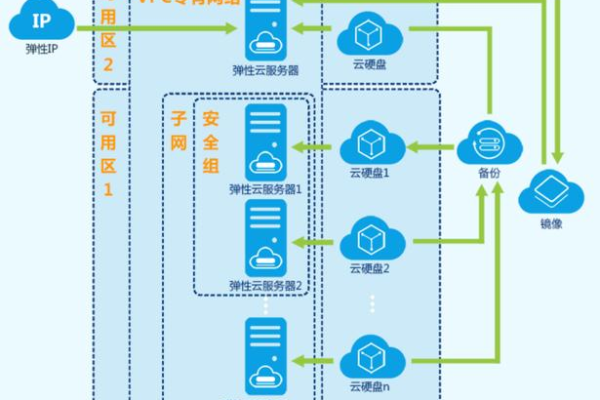

1、选择合适的服务器

硬件要求:需要具备足够的 CPU 核心数、内存容量和存储空间,对于小型企业或轻量级使用场景,至少 2 核 CPU、4GB 内存和 50GB 存储空间较为合适;而对于大型企业或高流量的邮件服务,可能需要更强大的配置,如多核高频 CPU、32GB 以上内存和大容量的硬盘阵列(RAID),以确保邮件服务的流畅运行和数据安全。

网络带宽:稳定且高速的网络连接至关重要,建议选择具有至少 10Mbps 对称带宽的网络接入,以保障邮件的快速收发,避免因网络瓶颈导致的邮件延迟或丢失。

2、确定操作系统

Linux 系列:如 Ubuntu Server、CentOS 等是搭建邮件服务的常用操作系统,它们具有高度的稳定性、安全性和可定制性,并且拥有丰富的开源软件资源,便于进行邮件服务器的配置和管理,Ubuntu Server 的长期支持版本(LTS)提供了长达数年的安全更新和技术支持,适合对稳定性要求较高的邮件服务环境。

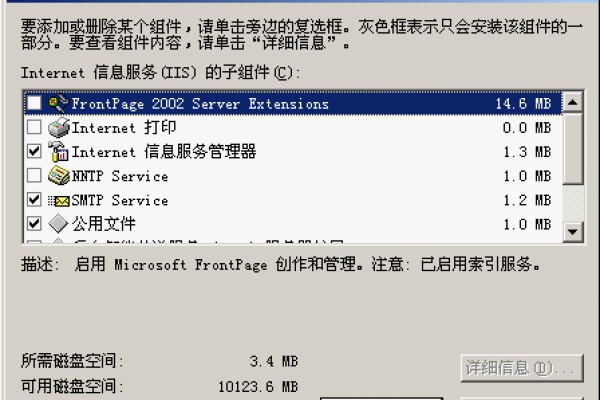

Windows Server:如果对 Windows 环境更为熟悉或有特定的软件依赖,也可以选择 Windows Server 作为邮件服务器的操作系统,不过,相对而言,其在开源软件支持和系统资源占用方面可能不如 Linux 系统表现优异。

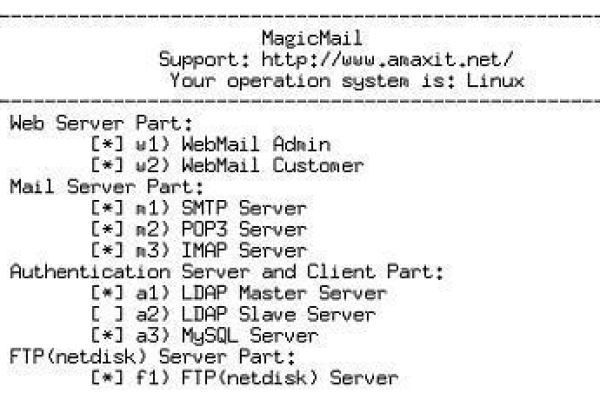

二、安装邮件服务器软件

1、Postfix

简介:Postfix 是一款功能强大且高效的开源邮件传输代理(MTA),它采用模块化设计,具有良好的可扩展性和安全性,能够处理大量的邮件流量,适用于各种规模的邮件服务需求。

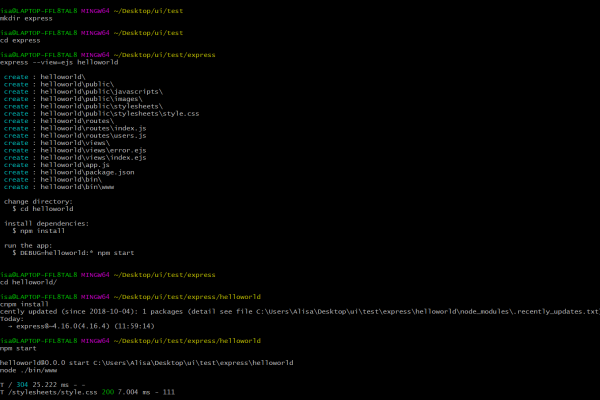

安装步骤(以 Ubuntu 为例):

| 步骤 | 命令 |

| 更新软件包列表 | sudo apt update |

| 安装 Postfix | sudo apt install postfix |

| 配置 Postfix | sudo dpkg-reconfigure postfix |

在配置过程中,需要根据实际需求设置邮件域名、邮件存储位置等参数,将邮件域名设置为example.com,邮件存储路径设置为/var/mail/。

2、Dovecot

简介:Dovecot 是一个流行的开源 IMAP 和 POP3 邮件服务器,用于提供邮件的存储和检索服务,它可以与 Postfix 协同工作,实现完整的邮件收发功能。

安装步骤(以 Ubuntu 为例):

| 步骤 | 命令 |

| 更新软件包列表 | sudo apt update |

| 安装 Dovecot | sudo apt install dovecot-imapd dovecot-pop3d |

| 配置 Dovecot | 编辑/etc/dovecot/dovecot.conf 文件,设置协议(IMAP、POP3)、监听端口、用户认证方式等参数,将 IMAP 监听端口设置为 143,POP3 监听端口设置为 110,并启用 SSL/TLS 加密连接以提高安全性。 |

三、配置域名解析

1、DNS 记录设置

MX 记录:MX(Mail Exchange)记录用于指定处理该域名邮件的邮件服务器,将example.com 的 MX 记录指向邮件服务器的 IP 地址,优先级设置为 10,这样,当外部邮件服务器向example.com 域发送邮件时,会首先查询该域名的 MX 记录,找到对应的邮件服务器并进行投递。

A 记录或 AAAA 记录:为邮件服务器设置 A 记录(IPv4 地址)或 AAAA 记录(IPv6 地址),确保外部网络能够正确解析邮件服务器的域名到其 IP 地址,将mail.example.com 的 A 记录设置为邮件服务器的公网 IP 地址xxx.xxx.xxx.xxx。

2、反向域名解析(PTR 记录)

许多邮件服务提供商会检查发件服务器的 PTR 记录,以确保邮件的来源合法,需要在域名注册商处为邮件服务器的 IP 地址设置反向域名解析记录,使其指向相应的域名,如果邮件服务器的 IP 地址是xxx.xxx.xxx.xxx,那么应设置 PTR 记录为mail.example.com。

四、安全设置

1、防火墙配置

仅允许必要的端口对外开放,如 Postfix 的 SMTP 端口(25、465、587)和 Dovecot 的 IMAP(143、993)及 POP3(110、995)端口,对于其他不必要的端口,应予以关闭以减少潜在的安全风险,可以使用ufw(在 Ubuntu 上)或firewalld(在 CentOS 上)等防火墙工具进行端口管理,在 Ubuntu 上使用以下命令开放 Postfix 的 SMTP 端口:

| 命令 | 说明 |

sudo ufw allow 25/tcp | 开放 SMTP 端口 25 |

sudo ufw allow 465/tcp | 开放 SMTPS 端口 465 |

sudo ufw allow 587/tcp | 开放 StartTLS 端口 587 |

2、加密通信

SSL/TLS 证书:为 Postfix 和 Dovecot 配置 SSL/TLS 证书,以加密邮件传输过程,防止邮件内容被窃取或改动,可以使用自签名证书或从权威证书颁发机构(CA)购买证书,在配置过程中,将证书文件路径和私钥文件路径分别指定到 Postfix 和 Dovecot 的配置文件中相应的参数位置,在 Postfix 的主配置文件main.cf 中设置smtpd_tls_cert_file = /path/to/certificate.crt 和smtpd_tls_key_file = /path/to/private.key。

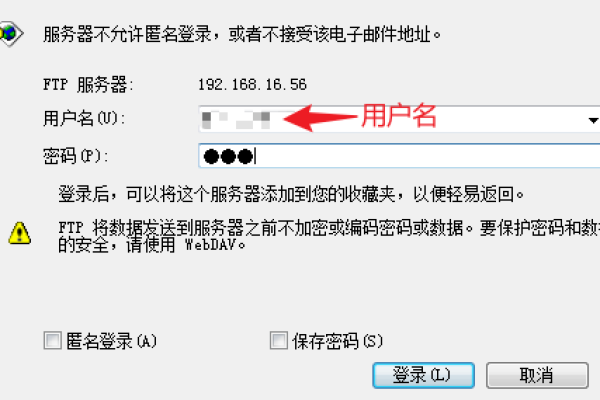

3、用户认证与访问控制

本地用户认证:可以创建本地用户账户用于登录邮件服务器,并通过设置用户密码或使用 PAM(可插拔认证模块)集成系统用户认证机制来验证用户身份,在 Dovecot 中,通过编辑/etc/dovecot/passwd 文件或使用dovecot-pw 工具管理用户密码。

基于域的访问控制:根据用户的邮箱域名或 IP 地址范围限制其对邮件服务的访问权限,只允许特定域名的用户登录邮件服务器,或者限制某些 IP 地址段的访问,以防止未经授权的访问尝试。

五、测试与监控

1、邮件收发测试

使用本地邮件客户端(如 Thunderbird、Outlook 等)或命令行工具(如telnet、openssl)连接到邮件服务器,测试邮件的发送和接收功能是否正常,使用telnet 命令连接到 Postfix 的 SMTP 端口并发送一封简单的邮件:

| 命令 | telnet mail.example.com 25 |

| 操作步骤 | 1. 输入EHLO example.com2. 输入 MAIL FROM: 3. 输入 RCPT TO: 4. 输入 DATA5. 输入邮件正文内容,以 . 结尾表示结束 |

2、日志监控与故障排除

密切关注 Postfix 和 Dovecot 的日志文件(通常位于/var/log/mail.log、/var/log/mail.err、/var/log/dovecot.log 等),及时发现并解决可能出现的问题,常见的错误信息包括网络连接问题、用户认证失败、邮件格式错误等,通过分析日志文件中的错误代码和描述信息,可以定位问题根源并采取相应的解决措施,如果日志中出现“临时无法连接到对方服务器”的错误信息,可能是由于网络故障或对方服务器繁忙导致,此时可以检查网络连接或稍后重试。

FAQs:

1、问:如何在服务器上搭建一个简单但安全的邮件服务?

答:首先选择合适的服务器和操作系统,如 Ubuntu Server,安装 Postfix 作为 MTA,配置基本的域名和邮件存储路径;安装 Dovecot 用于邮件存储和检索,设置好协议和端口,并启用 SSL/TLS 加密,在域名解析方面,正确设置 MX、A(或 AAAA)记录以及 PTR 记录,通过防火墙限制不必要的端口访问,配置 SSL/TLS 证书实现加密通信,同时做好本地用户认证与访问控制,最后进行邮件收发测试和日志监控,确保邮件服务正常运行并及时处理故障。

2、问:如果邮件服务器遭受大量垃圾邮件攻击怎么办?

答:可以采取多种措施应对,一是启用反垃圾邮件插件或服务,如 SpamAssassin(可与 Postfix 集成),它能够根据预设的规则和模式识别并过滤垃圾邮件;二是加强用户认证机制,防止反面用户利用服务器发送垃圾邮件,例如使用更强的密码策略或多因素认证;三是监控邮件流量和来源,对于来自已知垃圾邮件源的邮件进行拦截或限制;四是定期清理邮箱中的垃圾邮件,避免邮箱被填满导致正常邮件无法接收。

小编有话说:搭建服务器建邮件服务需精心规划,从硬件到软件,从安全到测试,每个环节都至关重要,希望本文能为你提供清晰的思路和实用的指导,助你在服务器上成功搭建起稳定可靠的邮件服务。