如何使用JavaScript实现复选框列表(CheckboxList)的功能?

- 行业动态

- 2024-12-18

- 3645

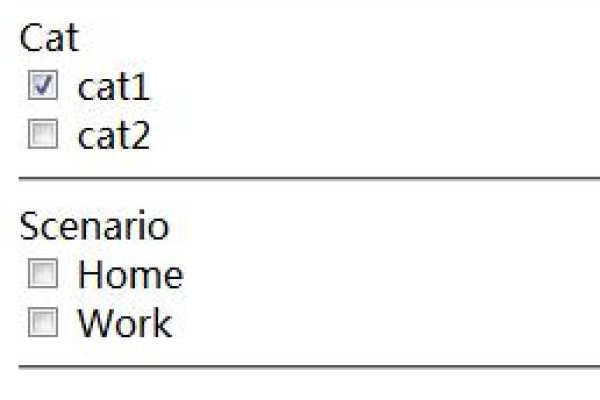

在网页开发中,复选框列表(Checkbox List)是一种常见的用户界面元素,允许用户从多个选项中选择一个或多个,使用JavaScript可以增强复选框列表的功能,比如动态添加或删除选项、全选/取消全选等,本文将详细介绍如何使用JavaScript操作复选框列表,包括基本用法和高级功能。

基本用法

我们来看一个简单的HTML复选框列表示例:

<!DOCTYPE html>

<html lang="en">

<head>

<meta charset="UTF-8">

<title>Checkbox List Example</title>

</head>

<body>

<h2>Fruits</h2>

<form id="fruitForm">

<input type="checkbox" id="apple" name="fruit" value="Apple">

<label for="apple">Apple</label><br>

<input type="checkbox" id="banana" name="fruit" value="Banana">

<label for="banana">Banana</label><br>

<input type="checkbox" id="cherry" name="fruit" value="Cherry">

<label for="cherry">Cherry</label><br>

<button type="button" onclick="selectAll()">Select All</button>

<button type="button" onclick="deselectAll()">Deselect All</button>

</form>

<script>

function selectAll() {

document.querySelectorAll('input[name="fruit"]').forEach(function(checkbox) {

checkbox.checked = true;

});

}

function deselectAll() {

document.querySelectorAll('input[name="fruit"]').forEach(function(checkbox) {

checkbox.checked = false;

});

}

</script>

</body>

</html>

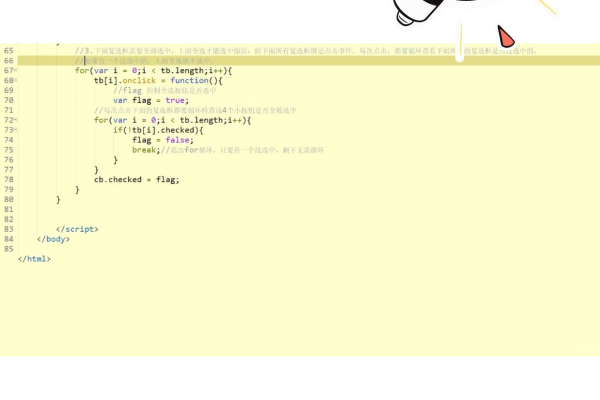

在这个例子中,我们创建了一个包含三个复选框的表单,每个复选框代表一种水果,我们还添加了两个按钮,一个用于全选,另一个用于取消全选,通过JavaScript函数selectAll和deselectAll,我们可以分别实现这两个功能。

动态添加和删除选项

有时候我们需要根据用户的输入或其他条件动态地添加或删除复选框选项,以下是一个示例:

<!DOCTYPE html>

<html lang="en">

<head>

<meta charset="UTF-8">

<title>Dynamic Checkbox List</title>

</head>

<body>

<h2>Dynamic Fruits</h2>

<form id="dynamicForm">

<div id="fruitContainer"></div>

<button type="button" onclick="addFruit()">Add Fruit</button>

</form>

<script>

let fruitIndex = 0;

function addFruit() {

const fruitContainer = document.getElementById('fruitContainer');

const newInput = document.createElement('input');

newInput.type = 'checkbox';

newInput.id =fruit${fruitIndex};

newInput.name = 'fruit';

newInput.value =Fruit ${fruitIndex + 1};

const newLabel = document.createElement('label');

newLabel.htmlFor = newInput.id;

newLabel.appendChild(document.createTextNode(Fruit ${fruitIndex + 1}));

newLabel.appendChild(document.createElement('br'));

fruitContainer.appendChild(newInput);

fruitContainer.appendChild(newLabel);

fruitIndex++;

}

</script>

</body>

</html>

在这个例子中,我们使用了一个按钮来添加新的复选框选项,每次点击按钮时,都会创建一个新的复选框和一个标签,并将它们添加到页面上的容器中。

高级功能:统计选中的选项数量

有时我们需要统计用户选中了多少个选项,以下是一个示例:

<!DOCTYPE html>

<html lang="en">

<head>

<meta charset="UTF-8">

<title>Checked Count</title>

</head>

<body>

<h2>Count Selected Fruits</h2>

<form id="countForm">

<input type="checkbox" id="apple" name="fruit" value="Apple">

<label for="apple">Apple</label><br>

<input type="checkbox" id="banana" name="fruit" value="Banana">

<label for="banana">Banana</label><br>

<input type="checkbox" id="cherry" name="fruit" value="Cherry">

<label for="cherry">Cherry</label><br>

<button type="button" onclick="countSelected()">Count Selected</button>

<p id="selectedCount">Selected: 0</p>

</form>

<script>

function countSelected() {

const selectedCheckboxes = document.querySelectorAll('input[name="fruit"]:checked');

document.getElementById('selectedCount').textContent =Selected: ${selectedCheckboxes.length};

}

</script>

</body>

</html>

在这个例子中,我们添加了一个按钮和一个段落来显示选中的复选框数量,当用户点击按钮时,countSelected函数会被调用,它会计算所有被选中的复选框的数量,并更新段落中的文本。

本文介绍了如何使用JavaScript操作复选框列表,包括基本用法、动态添加和删除选项以及统计选中的选项数量等功能,这些技巧可以帮助开发者创建更加交互性和用户友好的网页表单。

以上内容就是解答有关“checkboxlist js”的详细内容了,我相信这篇文章可以为您解决一些疑惑,有任何问题欢迎留言反馈,谢谢阅读。

本站发布或转载的文章及图片均来自网络,其原创性以及文中表达的观点和判断不代表本站,有问题联系侵删!

本文链接:http://www.xixizhuji.com/fuzhu/44188.html