如何处理MySQL查询中出现的重复数据库记录?

- 行业动态

- 2024-09-22

- 1

sql,SELECT DISTINCT 来电号码 FROM 表名;,“

在操作MySQL数据库时,查询和处理重复的记录是维护数据完整性和优化性能的关键步骤,下面将详细解析如何在MySQL中有效地标识和处理重复的数据,确保数据库的整洁和高效运行。

1、识别重复数据

使用SHOW DATABASES列出所有数据库:这是查看MySQL服务器上所有数据库的第一个步骤,通过这个命令,管理员可以快速获取服务器上存在的所有数据库的列表。

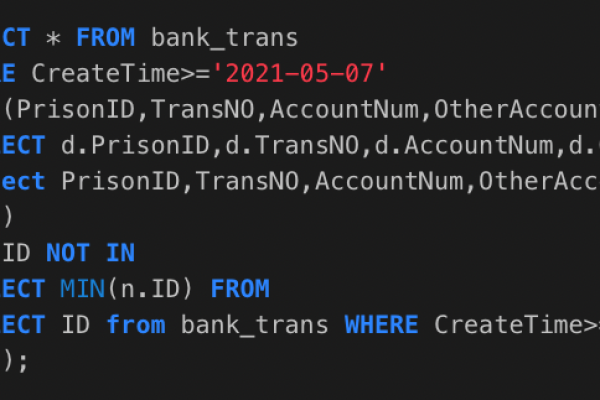

SELECT COUNT(*)统计重复**:通过使用SELECT COUNT(*)结合GROUP BY子句,可以对特定列的值进行计数,以识别哪些值出现多次,这个步骤是确认是否存在重复记录的直接方法。

使用临时表:创建一个临时表,将疑似重复的数据导入其中,这样做的好处是可以在一个隔离的环境中操作,不会影响到原始数据,然后可以通过编写查询对该临时表进行更深入的分析。

多表连接查询:当确定了哪些数据是重复的后,可以使用多表连接查询来进一步操作这些数据,这可能包括删除重复项或更新相应的记录。

2、处理重复数据

删除重复记录:一旦识别了重复的数据,接下来的任务是删除这些重复记录,在MySQL中,可以在一个事务中执行删除操作,确保数据的一致性和完整性被保护。

预防措施:为避免未来数据重复,可以设置表的唯一约束或主键约束,这样可以从根本上阻止重复数据的再次出现,提升数据质量。

定期检查和清理:数据库应定期进行检查,清除或合并重复的数据记录,这可以通过设置定期任务来实现,比如使用MySQL的事件调度器来自动执行去重脚本。

使用数据分析工具:借助专业的数据分析和数据库管理工具,可以帮助更直观、更方便地进行数据去重和维护操作。

3、数据备份与恢复

定期备份数据:在进行任何形式的数据库优化和清理之前,应该先对数据进行备份,这可以防止在处理过程中发生数据丢失的情况。

恢复策略:确保有明确的数据恢复策略,在删除重复数据后,如果发现某些数据被误删,应能迅速恢复。

使用日志记录操作:在处理数据库时记录详细的日志,包括处理的时间、范围及具体操作,这样,当需要回溯或排查问题时,可以有据可查。

在深入理解MySQL数据库去重的同时,考虑以下几点将有助于提升操作的效率和安全性:

保证操作前的数据备份是最新和完整的。

在执行删除操作前,先在测试环境中验证去重逻辑的正确性。

监控数据库性能,特别是在处理大量数据时,确保系统资源不会过度消耗。

可以看到,在MySQL中查询和处理重复数据是一个涉及多个步骤的过程,需要精确的策略和周密的计划,通过智能地使用SQL语句和数据库管理工具,可以有效地维护数据库的清洁和性能,定期的维护和预防措施也是确保数据库健康的重要方面。

本站发布或转载的文章及图片均来自网络,其原创性以及文中表达的观点和判断不代表本站,有问题联系侵删!

本文链接:http://www.xixizhuji.com/fuzhu/43922.html