在mapreduce框架中,block_BLOCK机制如何优化数据处理效率?

- 行业动态

- 2024-10-05

- 1

MapReduce 中的 Block 和 BLOCK

概述

在 MapReduce 框架中,数据被分割成多个小的数据块(Block),这些数据块是 MapReduce 处理的基本单位,每个数据块通常对应于 Hadoop 分布式文件系统(HDFS)中的一个数据块,以下是对 Block 和 BLOCK 的详细描述。

Block

定义:

Block 是 HDFS 中的基本存储单位。

每个Block通常包含一个或多个文件的数据。

特点:

默认大小为 128MB 或 256MB,具体取决于 Hadoop 配置。

HDFS 使用 Block 来实现数据冗余和高效的数据访问。

每个Block都有一个唯一的标识符(Block ID)。

作用:

在 MapReduce 处理过程中,每个Block会被分配给一个 Mapper 处理。

Mapper 对 Block 中的数据进行读取、处理,并输出中间结果。

BLOCK

定义:

BLOCK 在 MapReduce 上下文中通常指的是 MapReduce 中的一个基本执行单元。

它通常对应于一个特定的任务,例如一个 Mapper 或一个 Reducer。

特点:

BLOCK 可以是单个 Mapper 或 Reducer 任务。

每个 BLOCK 处理一个或多个 Block 的数据。

BLOCK 之间的数据传输通常通过网络进行。

作用:

BLOCK 是 MapReduce 作业执行的基本调度单位。

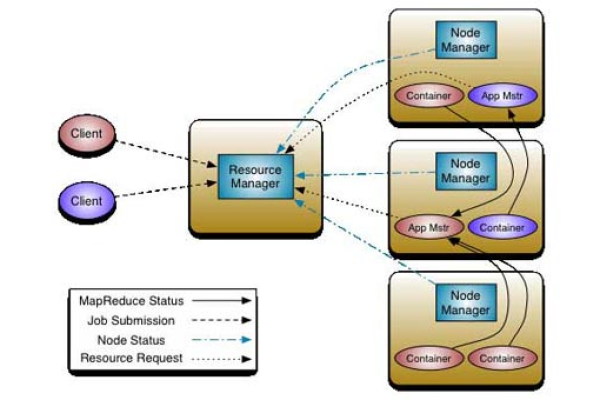

Hadoop 的作业调度器负责将作业分解成多个 BLOCK,并分配给不同的节点执行。

每个 BLOCK 的执行结果会经过 Shuffle 和 Sort 阶段,最终输出到 HDFS 或其他存储系统中。

Block 是 HDFS 中的数据存储单位,是 MapReduce 处理数据的基本来源。

BLOCK 是 MapReduce 中的执行单元,包括 Mapper 和 Reducer 任务,负责处理数据并生成最终结果。

通过理解 Block 和 BLOCK 的概念和作用,可以更好地掌握 MapReduce 的工作原理和性能优化。

本站发布或转载的文章及图片均来自网络,其原创性以及文中表达的观点和判断不代表本站,有问题联系侵删!

本文链接:http://www.xixizhuji.com/fuzhu/4387.html