服务器导入规则

- 行业动态

- 2025-02-01

- 10

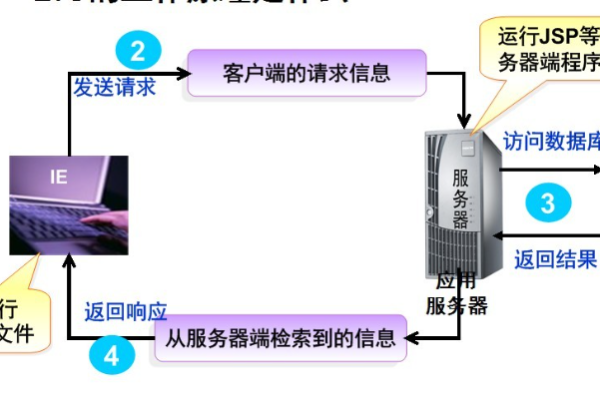

服务器导入规则是确保数据在传输和加载过程中的一致性、安全性和效率的重要准则,以下是一些关键的服务器导入规则,它们可以帮助管理员和开发者有效地管理数据导入过程:

数据验证与清洗

规则:在导入前对数据进行彻底的验证和清洗,以确保数据的准确性和完整性。

目的:防止错误或不完整的数据破坏现有系统的数据完整性。

格式标准化

规则:确保所有导入的数据遵循统一的格式标准,如CSV、XML或JSON。

目的:简化数据处理流程,减少解析错误。

安全传输

规则:使用加密协议(如SSL/TLS)在数据传输过程中保护数据安全。

目的:防止数据在传输过程中被截获或改动。

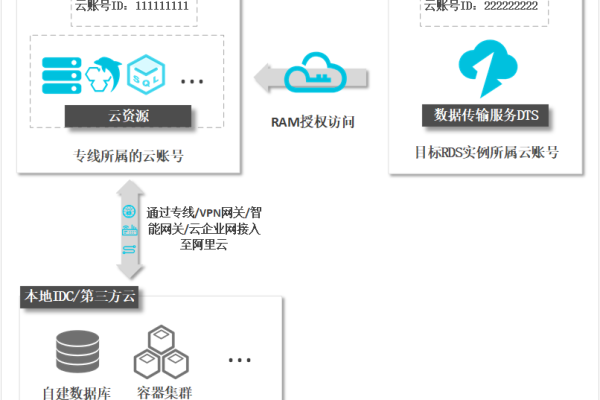

权限控制

规则:限制对导入功能的访问权限,仅允许授权用户执行导入操作。

目的:增强数据安全性,防止未授权访问。

事务管理

规则:使用数据库事务确保导入操作的原子性,即要么全部成功,要么全部失败。

目的:保持数据一致性,避免部分更新导致的数据不一致问题。

日志记录

规则:详细记录每次导入操作的过程和结果,包括时间、操作者、数据量等信息。

目的:便于追踪问题和审计,提高系统透明度。

错误处理

规则:设计健壮的错误处理机制,能够捕获并报告导入过程中的任何异常。

目的:快速定位并解决问题,减少系统停机时间。

性能优化

规则:在导入大量数据时,采取分批处理、索引优化等措施以提高导入效率。

目的:减少对服务器资源的消耗,加快数据可用速度。

兼容性测试

规则:在正式环境导入前,先在测试环境中进行充分的兼容性测试。

目的:确保导入操作不会对现有系统造成负面影响。

备份与恢复

规则:在进行大规模数据导入前,确保有最新的数据备份,以便在出现问题时能够迅速恢复。

目的:降低数据丢失的风险,保障业务连续性。

FAQs

Q1: 如果发现导入的数据存在错误,应该怎么办?

A1: 应立即停止当前的导入进程,并根据日志文件确定错误的具体原因,对原始数据进行修正或重新准备,并在修复问题后重新尝试导入,如果错误影响了部分已导入的数据,可能需要根据情况回滚或修正这些数据。

Q2: 如何确保大规模数据导入的性能?

A2: 为了确保大规模数据导入的性能,可以采取以下措施:

使用高效的数据传输工具和技术,如批量插入、并行处理等。

在导入前对数据进行预处理,如压缩、分割等,以减少单次传输的数据量。

优化数据库配置,如调整缓冲区大小、增加索引等,以提高写入效率。

监控服务器资源使用情况,及时调整硬件或软件配置以避免瓶颈。